pesquisafapesp

Un gas que emiten los árboles de la Amazonia acelera la formación de nubes

Organismos que viven solamente un día logran prever los cambios de estación

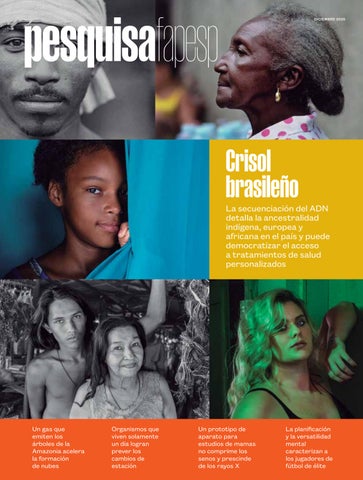

Crisol brasileño

La secuenciación del ADN detalla la ancestralidad indígena, europea y africana en el país y puede democratizar el acceso a tratamientos de salud personalizados

Un prototipo de aparato para estudios de mamas no comprime los senos y prescinde de los rayos X

La planificación y la versatilidad mental caracterizan a los jugadores de fútbol de élite

La importancia de la diversidad poblacional

ALEXANDRA OZORIO DE ALMEIDA directora de redacción

Cuando comenzaron los enormes proyectos de secuenciación del genoma humano, a finales del siglo XX, se creía que las diferencias existentes entre distintos individuos en lo que atañe a su composición genética serían mínimas. Por tal motivo, para alcanzar el objetivo de obtener un genoma completo de referencia, no se le puso demasiada atención a la diversidad poblacional en las muestras que serían secuenciadas. Pero resultó ser que los humanos poseen muchos menos genes de lo esperado y que los mismos no constituyen realmente la clave para develar las diferencias entre los individuos. Los avances tecnológicos han hecho posible la identificación de millones de pequeños cambios en el genoma: variaciones que pueden alterar la forma y la función de las proteínas o el patrón de activación-desactivación de los genes que las codifican. Dichas variaciones pueden presentarse como una característica común a ciertas poblaciones y tener importantes consecuencias sobre la salud pública, tales como la propensión a desarrollar ciertas enfermedades o el modo en que reaccionan los distintos organismos a ciertos medicamentos.

En un artículo publicado en la revista Science el pasado mes de mayo, se reportó la secuenciación del genoma de 2.700 personas de todo Brasil. Estos resultados no solamente permiten profundizar la comprensión de la diversidad genética de la población, sino que también respaldan los esfuerzos que se llevan adelante en el país en lo que concierne a la medicina de precisión y su disponibilidad en el sistema nacional de salud ( página 6 ).

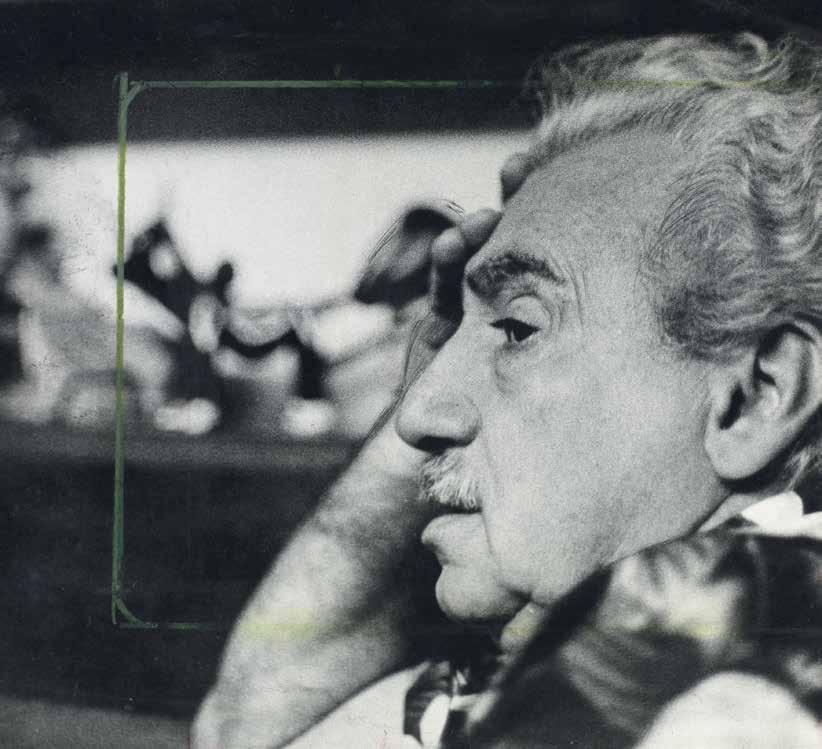

La diversidad genética también es fundamental en otro reportaje, pero en este caso el tema es la mandioca, no los genes humanos. Algunas prácticas de cultivo que emplean ciertas poblaciones indígenas, como en el caso del pueblo Waurá, son importantes para el mantenimiento de la variedad genética, como así también para garantizar la seguridad alimentaria ( página 37). Esta edición también presenta una diversidad de otros temas, como las investigaciones que revisitan la obra de Jorge Ama-

do (1912-2001), uno de los escritores brasileños más y mejor conocidos en el exterior ( página 58). En cuanto a la tecnología, las novedades provienen de arriba: nanosatélites para localizar naufragios ( página 57) y drones equipados con radares que pueden monitorear cultivos y buscar hormigueros y restos óseos enterrados ( página 40).

La edición de mayo de Pesquisa FAPESP en portugués incluyó una entrevista con el filósofo Luiz Henrique Lopes dos Santos, de la Universidad de São Paulo. Investigador en el campo de la lógica, Lopes dos Santos tuvo una larga trayectoria como asesor de la dirección científica de la FAPESP. Ayudó a crear varios programas de investigación y fue durante 21 años el coordinador científico de esta revista. Se hace difícil resumir su importancia en la construcción de la identidad de esta publicación. Poco después de conceder dicha entrevista, Lopes dos Santos fue diagnosticado con cáncer y falleció el pasado mes de julio. Su legado en nuestra redacción perdura en la búsqueda diaria de una escritura de calidad combinada con la precisión científica, con miras a llegar a un público cada vez más amplio ( página 16 ).

Mientras preparamos esta edición para su impresión, tiene lugar la COP30 por primera vez en Brasil. La cobertura de la ciencia inherente al cambio climático siempre ha sido una parte fundamental de nuestro trabajo. Un ejemplo de ello lo constituye el artículo referente a una investigación que resalta la importancia de los aerosoles –un tipo de partículas–en la formación de las nubes ( página 44). Desde hace tiempo se sabe que los aerosoles se acumulan sobre la selva amazónica. Y un estudio reciente muestra que el isopreno, un gas que emiten los árboles a manera de mecanismo térmico regulatorio, acelera la formación de estas partículas, que pueden viajar miles de kilómetros hasta convertirse en núcleos de condensación.

Esta edición internacional contiene una recopilación de artículos publicados originalmente en portugués entre enero y junio de 2025. Subimos mensualmente nuevos contenidos en español a nuestro sitio web (revistapesquisa.fapesp.br/es/).

revistapesquisa fapesp

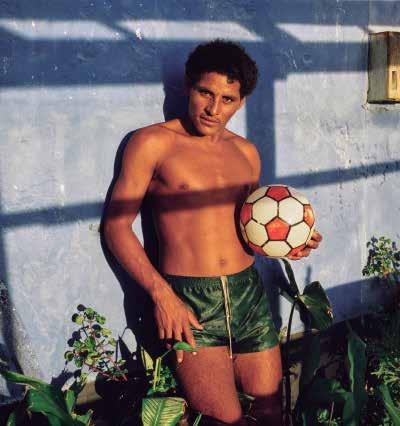

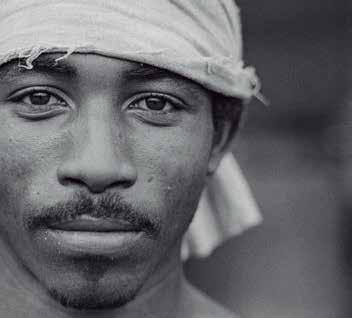

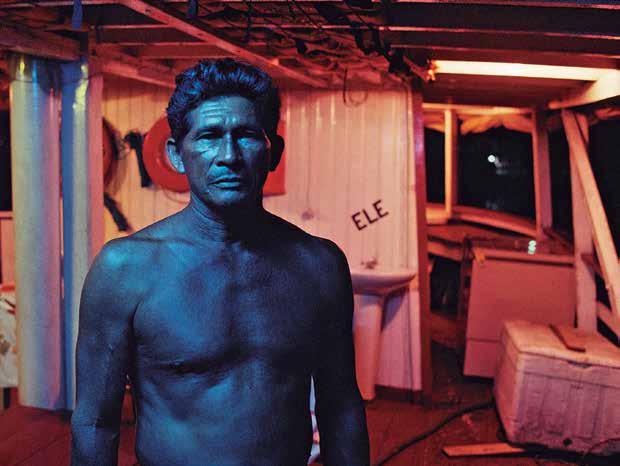

TAPA

Un ensayo de retratos del fotógrafo

Luiz Braga , del estado brasileño de Pará, ilustra la portada de esta edición, como así también sus reportajes. Una retrospectiva de su trabajo con el registro de los rostros de la región amazónica en el transcurso de 50 años fue objeto de una exposición en el Instituto Moreira Salles de São Paulo durante este año 2025

3 CARTA DE LA EDITORA

TAPA

6 La secuenciación del ADN de 2.723 brasileños echa luz sobre el proceso de mestizaje en el país

12 La información genómica puede democratizar el acceso a los tratamientos personalizados

ENTREVISTA

16 El filósofo Luiz Henrique Lopes dos Santos repasa su trayectoria académica y habla sobre sus más de 30 años de trabajo dedicados a la FAPESP

INNOVACIÓN

22 Un estudio detalla de qué manera los laboratorios universitarios erigen asociaciones con la industria

PSICOLOGÍA

26 Los jugadores de fútbol de élite poseen buena memoria y versatilidad mental

FISIOLOGÍA

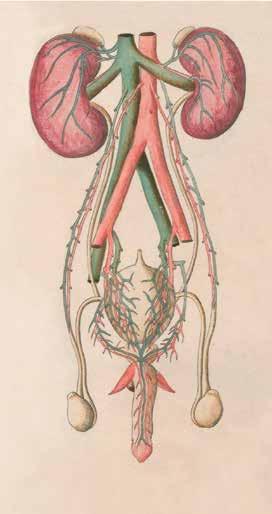

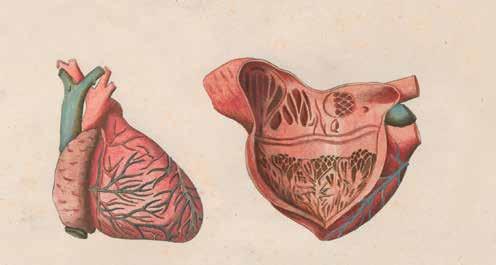

30 Los vasos sanguíneos liberan compuestos que modulan los latidos cardíacos y la presión arterial

CRONOBIOLOGÍA

34 Las cianobacterias viven un solo día, pero aun así logran prepararse para los cambios de estación

AGRICULTURA

37 Una técnica de cultivo del pueblo Waurá, en tierras indígenas del Alto Xingú (Brasil), enriquece la diversidad genética de la mandioca

AGRONOMÍA

40 Un radar a bordo de un dron monitorea cultivos y localiza hormigueros y osamentas en el subsuelo

QUÍMICA ATMOSFÉRICA

44 Un gas que emiten los árboles de la Amazonia acelera la producción de nubes

CAMBIOS CLIMÁTICOS

48 Los eventos extremos que congregan olas de calor, acidificación y escasez de clorofila asolan al Atlántico Sur

FÍSICA

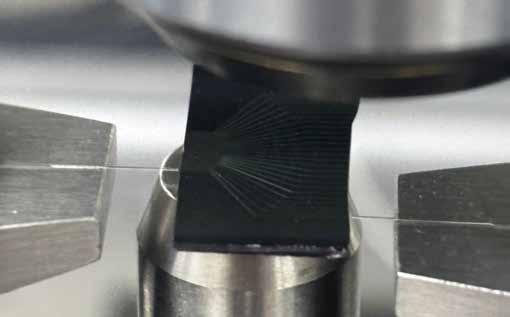

51 La interacción entre ondas de luz y ondas mecánicas puede generar avances en el área de la información cuántica

SALUD

54 Un nuevo aparato de examen de mamas evita la compresión de los senos y la radiación

INGENIERÍA ESPACIAL

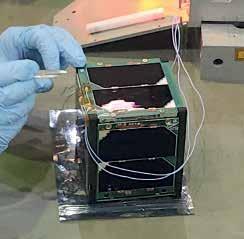

57 Proyectan lanzar un nanosatélite brasileño con la misión de localizar náufragos

LITERATURA

58 Nuevos estudios revisitan la obra del escritor Jorge Amado

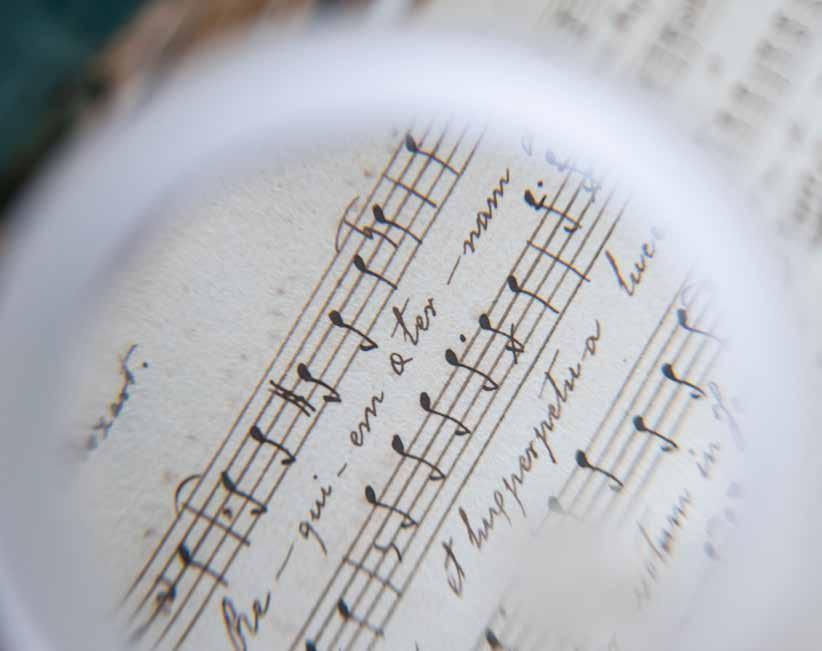

MÚSICA

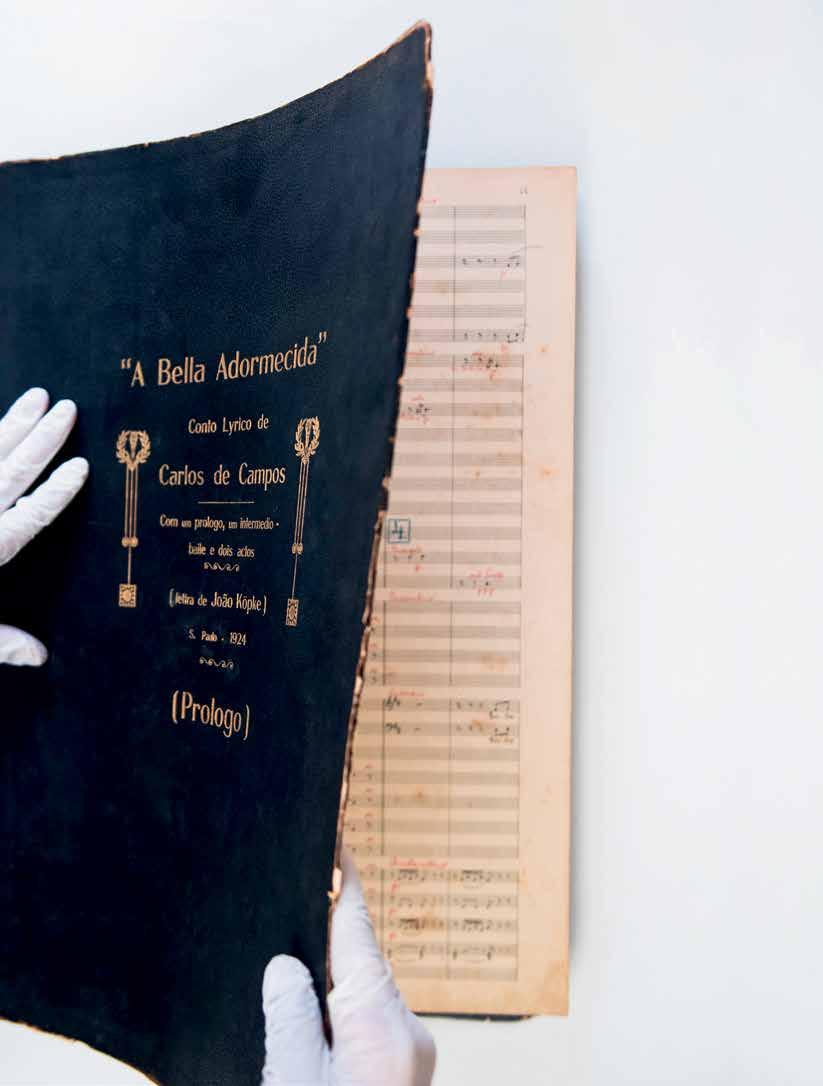

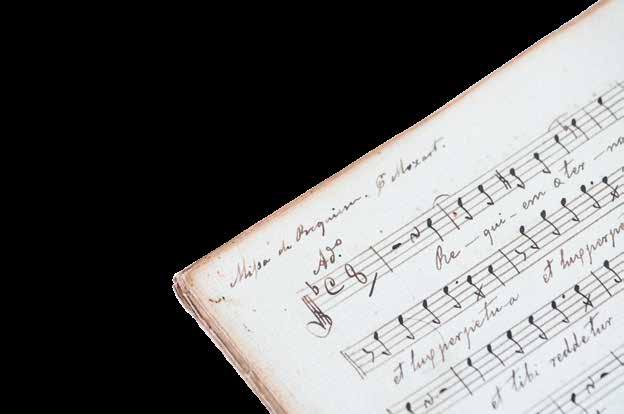

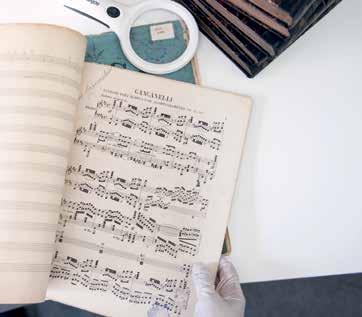

62 Investigaciones revelan rarezas musicales y expanden el acceso a colecciones poco conocidas

66 FOTOLAB

Padre europeo, madre africana o indígena

Nuevos resultados de la secuenciación del material genético de 2.723 personas ponen de relieve las huellas de violencia en el proceso de mestizaje que dio forma al pueblo brasileño

MARIA GUIMARÃES fotos LUIZ BRAGA

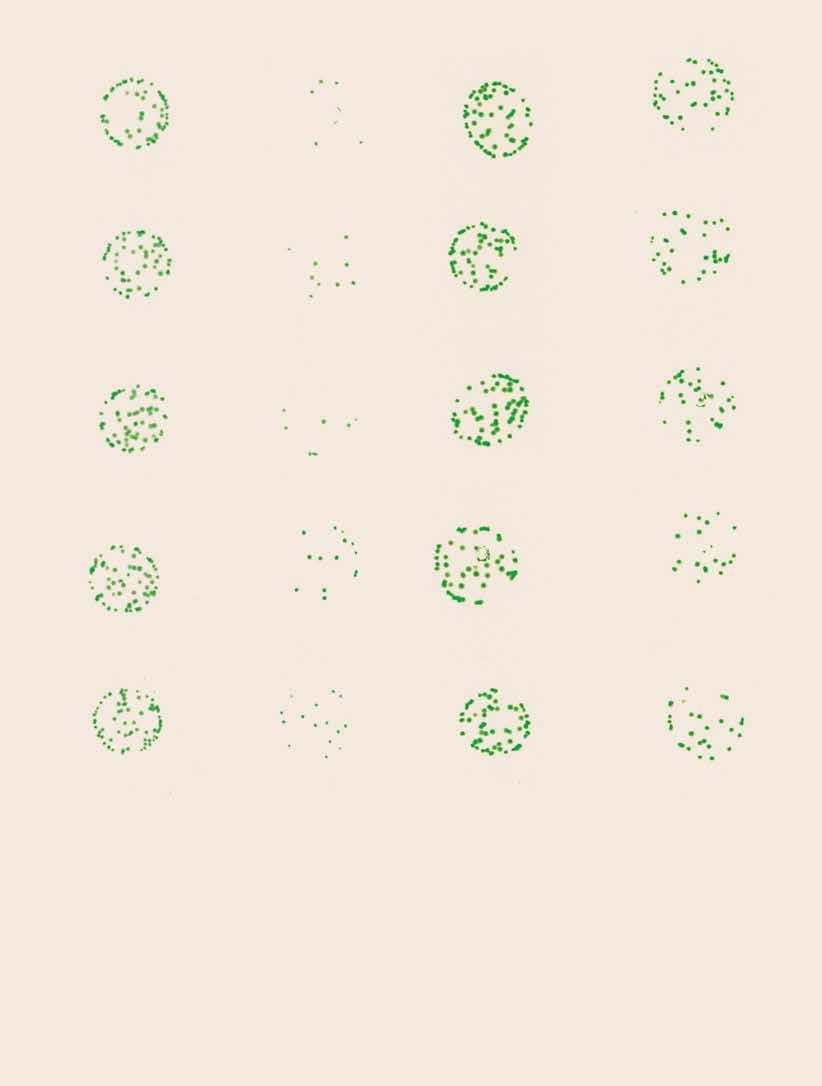

No es ninguna novedad que el pueblo brasileño es mestizo, pero los pormenores sobre cómo transcurrió esta historia y sus consecuencias vienen siendo revelados poco a poco por los genetistas, además de los historiadores. El estudio más reciente, que salió publicado en mayo en la revista científica Science, ahonda y amplía el retrato de los brasileños con base en la secuenciación del material genético de 2.723 personas de todas las regiones del país. Estos resultados revelan una marcada ascendencia africana e indígena en el linaje materno, como resultado de una dinámica de violencia contra las mujeres, y una cantidad inesperada de variantes genéticas desconocidas, con potenciales consecuencias sobre la salud.

“Es muy lindo poder constatar en el ADN lo que ya sabíamos por los libros de historia”, dice la genetista Lygia da Veiga Pereira, del Instituto de Biociencias de la Universidad de São Paulo (IB-USP) e ideadora del proyecto denominado ADN de Brasil, cuyo objetivo es elaborar un retrato genómico de la población mediante la secuenciación completa de las muestras tomadas en todo el país. Según la investigadora, hasta hace unos 10 años, el muestreo de la diversidad genética de las poblaciones humanas era muy bajo, con un porcentaje de ascenden-

cia europea cercano al 80 %. Esto se debe a que los estudios en su mayor parte se llevaban a cabo en el hemisferio norte. En Brasil, los mismos se centraban en el sur y en el sudeste del país, donde hasta ahora se ha encontrado una menor presencia de ascendencia africana e indígena. La inversión con miras a ampliar ese retrato fue el puntapié inicial del Programa Genomas Brasil del Departamento de Ciencia y Tecnología (Decit) del Ministerio de Salud nacional, puesto en marcha a finales de 2019, aunque sus actividades se retrasaron casi dos años debido al inicio de la pandemia de covid-19.

Da Veiga Pereira empezó a interesarse por la diversidad genética de la población cuando se percató, hace aproximadamente 20 años, de que los embriones desechados en las clínicas de reproducción asistida de São Paulo, disponibles para su investigación con células madre, tenían un 90 % de ancestralidad europea, lo que no parecía correcto tratándose de Brasil, pero que reflejaba cuál era el público de ese servicio. Mientras tanto, el genetista Sérgio Pena, de la Universidad Federal de Minas Gerais (UFMG), escudriñaba el ADN de brasileños de diversas regiones con las herramientas disponibles en ese entonces, mucho más limitadas que las actuales. En el año 2000, el investigador publicó los resultados del análisis de 200 muestras de personas blancas, primero en la revista de divulgación cientí-

El mestizaje en la historia

Los contextos de violencia en la formación del pueblo brasileño dejaron huellas en el genoma

1500

A su llegada, los europeos se encontraron con una población de alrededor de 10 millones de indígenas, que posteriormente fueron diezmados; la violencia sexual contra las mujeres fue la norma desde el principio

Siglo XVII

Huellas genéticas que se remontan a 16 generaciones revelan el mestizaje entre mujeres indígenas y hombres europeos

Siglo XVIII

El período de la extracción de diamantes, hace casi 12 generaciones, concretó un gran flujo de europeos hacia Brasil; la trata de personas esclavizadas de origen africano se multiplicó por 10

Comienzos del siglo XIX

Hasta la prohibición de la trata, unos 2 millones de esclavizados siguieron llegando desde África durante ese siglo; es el período de mayor mestizaje entre varones de ascendencia europea y mujeres afrodescendientes, hace ocho generaciones

1822 – Independencia

Se fomentan los matrimonios entre libertos y europeos como estrategia civilizatoria: se pregonaba la europeización de la población mestiza

1850

Se prohíbe la trata de esclavizados

1871

Con la Ley de Libertad de Vientres, los niños aún pueden ser explotados hasta los 21 años, pero ya no se permite la trata. Con la consiguiente pérdida de valor de mercado, los amos dejan de interesarse por la reproducción de las mujeres esclavizadas y el mestizaje disminuye

1888

Abolición de la esclavitud

Finales del siglo XIX y principios del siglo XX

El gobierno brasileño estimula la inmigración de varones blancos, en particular, italianos, alemanes, españoles y portugueses. El aporte de alrededor de 4 millones de europeos puede detectarse en la composición genética

Último siglo

Los matrimonios pasan a concretarse principalmente entre personas de ascendencia similar

fica Ciência Hoje, y después en la revista académica American Journal of Human Genetics. Tres de cada cinco individuos tenían ascendencia indígena o africana por línea materna, lo que según Pena era superior a lo esperado. El estudio fue divulgado en el segundo año de actividad de Pesquisa FAPESP Luego de eso, Pena continuó profundizando sus estudios y unió fuerzas con otro grupo pionero en el estudio del ADN brasileño, el del genetista Francisco Salzano (1928-2018), de la Universidad Federal de Rio Grande do Sul (UFRGS). En el marco de esa colaboración con el grupo de Minas Gerais, los genetistas de Rio Grande do Sul se dieron cuenta, en un trabajo dirigido por Maria Cátira Bortolini que abarcó la maestría de Tábita Hünemeier, de que el aporte africano era mucho más amplio de lo que indicaban los registros históricos sobre la esclavización, centrada principalmente en Angola, en el centro-oeste del continente. La región occidental, donde se encuentran Senegal y Nigeria, también reveló una aportación significativa en el material genético, mayor en São Paulo que en Río de Janeiro, lo que revela una asimetría en la trata de personas, según un artículo publicado en 2007 en la revista científica American Journal of Biological Anthropology . “No hay otro país en el mundo con tanto mestizaje como Brasil”, afirmó Pena en una entrevista concedida en 2021. Los medios actuales son muy distintos a los de aquella época, lo que hizo posible el estudio publi-

cado en la revista Science. En el mismo, la herencia europea se redujo a alrededor de un 60 %, mientras que la ascendencia africana emerge con un 27 % de la contribución y la indígena con un 13 %, con la asimetría sexual que apuntara Pena: el linaje paterno que se expresa en el cromosoma Y, presente tan solo en los varones, es predominantemente europeo (el 71 %). En cambio, el ADN mitocondrial, la parte de las células que se transmite solamente de la madre a los hijos, tiene un 42 % de ascendencia africana y un 35 % indígena. “La única explicación de esto son los cuatro siglos de violencia padecida en diversos sentidos”, resume Hünemeier, actual docente del IB-USP y una de las coordinadoras del estudio. La investigadora destaca que no es raro escuchar a personas mayores contar historias del tipo “a mi abuela la agarraron con el lazo”, sin prestarle atención a lo que eso significa. En las generaciones más recientes, lo característico pasó a ser el matrimonio entre personas de ascendencia similar. Para Hünemeier, estos resultados ayudan a echar por tierra la farsa de la democracia racial que conforma la identidad nacional, ya que en gran medida el mestizaje no fue consentido.

“Brasil necesita hacer una exégesis de su historia y dejar de decir que somos un país voluntariamente mestizo”, añade la historiadora Maria Helena Machado, de la USP, quien no participó en el trabajo. “Nuestra madre es africana, nuestra abuela es indígena y nuestro abuelo es un europeo

que no se casó con ella y tuvo hijos ilegítimos”. La historiadora es especialista en género y maternidad en la esclavitud, sistema que se extendió a lo largo de todo el período colonial y el Imperio. Entre otros trabajos, en 2024 publicó, en colaboración con el historiador Antonio Alexandre Cardoso, de la Universidad Federal de Maranhão, el libro Geminiana e seus filhos: Escravidão, maternidade e morte no Brasil do século XIX (editorial Bazar do Tempo). “Las mujeres esclavizadas, ya sea que fueran indígenas o africanas, estaban al servicio del esclavizador, lo que hacía que el acoso y las violaciones fueran habituales”, dice.

Por lo tanto, las mujeres eran esclavizadas por partida doble: funcionaban como trabajadoras y reproductoras. “La colonización operó en el cuerpo de las mujeres esclavizadas”. Machado explica que las políticas coloniales portuguesas y, a partir de 1822, del país independiente, siempre estimularon el mestizaje y el blanqueamiento. Un ejemplo: José Bonifácio de Andrada e Silva (1763-1838), como diputado de la Asamblea Constituyente de 1823, presentó propuestas para contribuir a la formación del pueblo brasileño mediante matrimonios entre mujeres afrodescendientes e indígenas con hombres blancos. Esto formaba parte de un proyecto “civilizatorio” en el que la

población negra se integraría a la europea. Sin embargo, la continuidad de la esclavitud hasta 1888 mantuvo a las mujeres esclavizadas sujetas a aquellos que ostentaban el control sus cuerpos.

“Todo esto conduce a la situación que ahora describen los genetistas”, culmina diciendo Machado.

También resulta interesante la amplia diversidad de etnias africanas, tal como Hünemeier lo había observado desde el comienzo de su carrera científica.

Personas que en África nunca se hubieran encontrado, por vivir en países y comunidades alejadas entre sí, se subieron a la fuerza a los barcos negreros y luego se las agrupó en contextos de trabajo esclavizado. La idea era reunir gente de diferentes culturas, que ni siquiera hablaban el mismo idioma, con miras a minimizar el riesgo de que se organizaran para luchar contra sus “amos”. El resultado de ello es una amalgama de todo un continente, que solo puede encontrarse en el territorio brasileño. “Es el país con mayor ancestralidad africana fuera de África”, dice la genetista.

Más allá de la afluencia inicial portuguesa a partir del siglo XVI, la diversidad europea también se muestra elevada, con un gran aporte de inmigrantes de Alemania e Italia en los siglos XIX y XX, además de una muestra más dispersa procedente de otros países. Un dato peculiar fueron los 10 descendientes de japoneses de la muestra de São Paulo que no mostraban huellas de mestizaje, lo que reveló una contribución muy limitada y reciente a la composición genética de la población nacional.

El artículo define a la colonización de América como el mayor desplazamiento poblacional de la historia humana. En Brasil, alrededor de 5 millones de europeos y otro tanto de africanos fueron trasplantados a la región hasta entonces poblada por

La ancestralidad por regiones

unos 10 millones de indígenas que hablaban más de 1.000 idiomas. Estos pueblos fueron diezmados, lo que causó un declive poblacional de un 83 % en el interior del país y un 98 % en el litoral desde principios del siglo XVI hasta los días actuales.

“Esperábamos hallar nuevas variantes genéticas, pero los resultados fueron mucho más allá”, dice la genetista Kelly Nunes, quien se dedicó a analizar los datos durante su pasantía posdoctoral en el IB-USP, en el laboratorio de Hünemeier, junto a otros tres colegas con quienes comparte la autoría principal del artículo: Marcos Castro e Silva, Maira Ribeiro y Renan Lemes. Las variantes son divergencias en la secuencia de un individuo en comparación con el genoma de referencia. “Detectamos 78 millones de variantes, de las cuales casi 9 millones no estaban registradas en ninguna otra base de datos”. Quedó claro que el ADN que compone la población brasileña incluye una muestra de poblaciones dejadas de lado desde el punto de vista genómico, especialmente africanas e indígenas de América del Sur. Próximamente, con la ampliación del muestreo, podrán precisarse mejor las dimensiones de este manantial de novedades genéticas. “Hemos establecido colaboraciones con miras a obtener muestras de las cinco regiones brasileñas, lo que nos ha permitido tener un mayor acceso a la ancestralidad africana e indígena”, explica la investigadora.

Unas 36.000 de las casi 9 millones de variantes nuevas descritas parecen tener efectos nocivos, ya que generan anomalías en las proteínas respectivas con pérdida de su función, por ejemplo, y pueden estar asociadas a dolencias como el cáncer, disfunciones metabólicas o enfermedades infecciosas.

“Lo que hemos descubierto sobre estas variantes puede extrapolarse a pueblos que no han sido muestreados, como en el continente africano”, propone Nunes. El conocimiento de la ancestralidad y de cómo se distribuye en el genoma y en las distintas

El nordeste de Brasil presenta zonas más africanas, mientras que el sudeste y el sur del país son europeos y la herencia indígena se concentra más en el norte

AFRICANA INDÍGENA

poblaciones del mundo la propensión a contraer enfermedades puede contribuir a democratizar el acceso a la salud de precisión, tal como se lo describe en el reportaje que comienza en la página 12.

Al analizar los genes con signos de haber sido favorecidos por la selección natural, por lo general un aumento de frecuencia en comparación con lo que se esperaría aleatoriamente, sobresalieron aquellos relacionados con la fertilidad o la cantidad de hijos generados, con origen en la ascendencia europea. Se trata de un rasgo que sin duda aportó beneficios durante el proceso de colonización, en el que los portugueses que se instalaron aquí expandieron rápidamente su presencia. Asimismo, los genes de respuesta inmunológica de origen africano exhiben signos de selección, lo que refleja un historial de una amplia variedad de agentes patogénicos. Los resultados también revelan indicios genéticos de enfermedades metabólicas concentradas en la ascendencia indígena, aparentemente vinculadas al contexto de un cambio gradual de los hábitos alimentarios. “Empezamos a consumir alimentos industrializados, lo que genera un ambiente de selección natural para ciertos genes”, explica Nunes. Uno de los retos que planteó el estudio fue el análisis de los datos, que contó con la infraestructura de computación en la nube cedida por

Google. “En Brasil no había profesionales calificados para lidiar con ese volumen de información”, comenta la genetista, quien afirma haber aprendido mucho con el proyecto, que también aportó calificación a muchas otras personas. Ya se han secuenciado otros 7.000 genomas, lo que amplía la búsqueda de representatividad. Las autoras prometen arribar a nuevos resultados en breve. Iniciativas similares en otros países de la región también podrían contribuir a la comprensión de la historia sudamericana. “Hemos detectado un componente específico de ascendencia genética precolombina, presente fundamentalmente en el centro-oeste de Argentina”, le comentó a Pesquisa FAPESP vía correo electrónico el genetista argentino Rolando González-José, investigador del Centro Nacional Patagónico (Cenpat) y coordinador del Programa de Referencia y Biobanco Genómico de la Población Aregentina (PoblAr), quien no participa en el proyecto de la USP. “Las suposiciones de larga data sobre la dinámica de la población durante el período posterior al contacto con los colonizadores son insuficientes para explicar la historia evolutiva que subyace a la diversidad genética en las poblaciones argentinas modernas”. A su juicio, las colaboraciones con investigadores brasileños pueden rendir frutos. l

El proyecto, los artículos científicos y el libro consultados para la elaboración de este reportaje aparecen listados en la versión online

Medicina de precisión para todos

La información genómica sobre la población brasileña puede democratizar el acceso a tratamientos personalizados y bajar los costos de la atención de la salud en el país

La salud de precisión es fruto de los proyectos en cuyo marco se secuenció el genoma humano, y no es un lujo. Al contrario: hace posible formular un diagnóstico más certero de algunas enfermedades y una planificación mejor y más segura de la medicación. Esto es bueno para el sistema sanitario, que deja de desperdiciar recursos en procedimientos ineficaces, y también para los pacientes, que reciben el tratamiento que mejor les funciona, con menos efectos colaterales. Sin embargo, Brasil padece una escasez de aquellos parámetros biológicos que permitirían saber qué variantes genéticas causan enfermedades en el país. Esto se debe a que las secuenciaciones que sirven de referencia internacional se obtuvieron en su mayoría a partir de personas de ascendencia europea del hemisferio norte.

El enfoque en la diversidad local y regional no es localismo. Aunque la mayor parte del genoma es similar entre personas diferentes, ciertas alteraciones puntuales pueden marcar una gran diferencia en el funcionamiento de genes que, cuando son defectuosos, causan enfermedades. Por lo tanto, es fundamental entender la composición genética de la población brasileña: de ahí surge el interés del Departamento de Ciencia y Tecnología (Decit) del Ministerio de Salud nacional en crear el Programa Nacional de Genómica y Salud de Precisión – Genomas Brasil. Además del ADN de Brasil (véase el reportaje que comienza en la página 6), el mismo abarca otros proyectos, entre ellos el Genomas

SUS –una referencia a las siglas del Sistema Único de Salud, la red nacional de salud pública–, que articula a varias universidades con miras a evaluar el impacto de la genómica en la salud. El proyecto, que se puso en marcha en abril de 2024, prevé terminar en noviembre la secuenciación de 21.000 genomas completos de brasileños. En el transcurso de tres años, el objetivo es llegar a 80.000 genomas, tomando el recaudo de realizar un muestreo de ancestralidades muy diverso. A su vez, la FAPESP anunció que emitió una convocatoria a la presentación propuestas para financiar la secuenciación de otras 15.000 muestras. La idea es seleccionar proyectos más pequeños de investigadores que actualmente no participan en Genomas SUS. “Será una contrapartida de la Fundación para el proyecto nacional”, explica el médico Leandro Machado Colli, de la Facultad de Medicina de Ribeirão Preto de la Universidad de São Paulo (FMRP-USP), coordinador del proyecto. “Las muestras podrán extraerse en cualquier lugar de Brasil, siempre que los investigadores estén radicados en São Paulo”. Tal como Machado Colli lo explica, la estrategia actual del proyecto Genomas SUS radica en utilizar la tecnología denominada short reads, que consiste en leer el genoma a partir de fragmentos cortos de 150 pares de bases, un método cuyo costo es más viable. Con secuenciaciones más completas para garantizar el contexto, los beneficios son muy buenos. “De las 21.000 muestras con las que contamos, analizaremos 200 con la tecnología long reads para tener una referencia más precisa”, dice

MARIA GUIMARÃES fotos LUIZ BRAGA

el investigador. En este caso se trata de fragmentos más grandes, que llegan a contener cientos de miles de pares de bases. En esta contextualización de los genes relacionados con enfermedades, es fundamental conocer la ascendencia de cada fragmento del ADN del paciente. “Podemos saber qué permite decir ese fragmento de material genético, en esa localización geográfica, sobre la salud de la persona”. Esto se debe a que, con las secuenciaciones, incluso las menos precisas, es posible saber en qué parte de cada cromosoma se encuentran las variantes alteradas y, de este modo, posiblemente asociarlas a la propensión a contraer enfermedades relacionadas con ellas.

Para asegurar la representación de la diversidad nacida del mestizaje, Genomas SUS cuenta con nueve centros de anclaje distribuidos por todo el país: dos de ellos en São Paulo y los demás en Río de Janeiro, Minas Gerais, Paraná, Pernambuco y Pará. “La población brasileña tiene una gran representatividad de pueblos que se mestizaron durante su proceso de formación, entre ellos indígenas y de ascendencia africana”, dice la genetista Ândrea Ribeiro-dos-Santos, coordinadora del único centro del país ubicado en la región norte, con sede en la Universidad Federal de Pará y en funcionamiento desde septiembre de 2024. “En la región amazónica, las mujeres indígenas a menudo eran recibidas en el seno de las comunidades habitantes de palenques o quilombolas, pues ellas conocían los secretos y los modos de vida de la selva”, ejemplifica, con base en los resultados de las investigaciones de su grupo que detectaron esta asimetría sexual en la contribución genética. Al igual que el centro de la región nordeste, el de la Amazonia aún no cuenta con un equipo de secuenciación, razón por la cual debe enviar las moléculas de ADN extraídas para que se las analice en otros centros. Por ahora, ya se han secuenciado 1.800 muestras, la mayoría del estado de Pará. Pero esto ha de cambiar con la inclusión de otros estados de la región. “Hace dos semanas estuvimos en una misión sanitaria en el estado de Amapá, donde extrajimos muestras en el marco de un trabajo conjunto con las secretarías de Salud del estado y del municipio, y también con la Universidad Federal de Amapá”. Se están negociando acuerdos con instituciones de los estados de Amazonas y Acre, con especial atención a las cuestiones éticas obligatorias que deben cumplirse. Los retos en esta región son considerables: la llegada a ciertas comunidades tradicionales puede comprender viajes en avión y en coche, seguidos de días a bordo de un barco. Pero es precisamente en estos rincones donde se encuentra una riqueza

única del territorio brasileño: la diversidad genética y cultural de su población humana.

Ribeiro-dos-Santos pone de relieve la importancia que reviste para el Sistema Único de Salud (SUS) comprender las variantes genéticas regionales y raras a los efectos de implementar protocolos de tratamientos para enfermedades tales como la diabetes y el cáncer. En general, no es tan solamente un gen el que está por detrás de estas afecciones, sino una infinidad de sendas que pueden causar disfunciones en la replicación de las células o en el metabolismo, lo que conduce al cáncer o, en el segundo caso, a la diabetes, y cualquier pieza alterada puede desencadenar la enfermedad. Una medicación eficaz es aquella que actúa sobre el foco del problema. “Sin este conocimiento específico, la persona puede morirse como resultado del tratamiento, o bien podría ser que el mismo no surta ningún efecto.”

“Es importante saber cómo aplicar la genómica para comprender las desigualdades sociales y arribar a un mejor diagnóstico de las enfermedades genéticas complejas”, añade el biólogo Eduardo Tarazona, de la Universidad Federal de Minas Gerais (UFMG), coordinador del Instituto Nacional de Ciencia y Tecnología de Ancestralidad Genómica, Enfermedades y Bioinformática en Brasil (INCT-AncesGen) y uno de los investigadores que se encuentran al frente del Genomas SUS. “Cuanto menos europea es una persona, menos saben la ciencia y la genética sobre sus enfermedades.”

Un ejemplo de ello es el trabajo internacional –que contó con la participación de Machado Colli–que mapeó áreas del genoma vinculadas a la susceptibilidad al cáncer renal, publicado en 2024 en la revista científica Nature Genetics. “En las etapas

anteriores del estudio no se incluyeron muestras brasileñas, por temor a que el mestizaje redujera el poder de análisis de la asociación”, afirma el médico. Pero sucedió lo contrario: al incluir en los análisis una cohorte brasileña, apareció una variante genética hasta entonces desconocida, presente en las personas afrodescendientes.

Cuando el genetista estadounidense Francis Collins, a la sazón director de los Institutos Nacionales de Salud (NIH) de su país, dictó una conferencia en la sede de la FAPESP en 2014, la médica genetista Iscia Lopes-Cendes, de la Universidad de Campinas (Unicamp), le pidió su opinión sobre la concreción de un proyecto genómico poblacional en Brasil. Collins lo consideró innecesario, ya que la diversidad genética humana ya se encontraría bien caracterizada. “Estaba completamente equivocado: los estadounidenses no entienden que las demás poblaciones latinas no son iguales a la mexicana”, bromea la investigadora, quien no quedó convencida con la respuesta. En 2015, fundó la plataforma BIPMed (Iniciativa Brasileña en Medicina de Precisión, por sus siglas en inglés). “Se trata de la primera base de datos genómicos de América Latina”, dice. “Tenemos un proyecto conjunto con Angola que es Genomas Angola (Genan), en cuyo marco ya hemos recolectado 750 muestras”, añade Lopes-Cendes, quien dirige a una estudiante doctoral angoleña en este proyecto. La experta espera hallar variantes genéticas aún no descritas, lo que tendrá potencialmente una utilidad práctica para ambos países, vinculados ancestralmente como

consecuencia del flujo de personas esclavizadas traídas a Brasil durante el período colonial.

“Si hay un lugar en donde es posible tener una salud de precisión al alcance de todos, ese lugar es Brasil”, sostiene. “Tenemos el SUS”. Ella refuta la idea de que esta tecnología solamente estaría al servicio de los países y de las personas ricas. Al contrario: según sostiene, la misma puede erigirse como una herramienta importante para la medicina preventiva. “La salud personalizada permite arribar a tratamientos más eficientes, con las dosis adecuadas destinadas a las personas adecuadas, con menos efectos adversos y con menores costos.”

Lopes-Cendes y la genetista Thais de Oliveira, quien cumple una pasantía posdoctoral en su laboratorio, publicaron en enero un comentario en la revista Annual Reviews of Genomics and Human Genetics en donde hacen hincapié en la importancia de las bases de datos públicas que recopilen información genómica sobre las poblaciones latinoamericanas. El genetista argentino Rolando González-José, investigador del Centro Nacional Patagónico (Cenpat) y coordinador del Programa de Referencia y Biobanco Genómico de la Población Argentina (PoblAr), coincide. “Es importante que los gobiernos lleguen a acuerdos para conectar las bases genómicas de la región”, sugirió por correo electrónico a Pesquisa FAPESP. Al igual que Machado Colli, González-José sostiene que la secuenciación con tecnología short reads aporta beneficios y optimiza los presupuestos disponibles. El proyecto ADN de Brasil, que forma parte del Programa Genomas Brasil, apunta a contribuir a la salud de precisión elaborando un retrato detallado de la variación genética brasileña. La industria farmacéutica también podrá beneficiarse de estos avances. La genetista Lygia da Veiga Pereira, de la USP y fundadora del proyecto, aprovechó en 2021 los conocimientos adquiridos en el transcurso de su trayectoria académica para crear una startup llamada gen-t, ahora financiada por el Programa de Investigación Innovadora en Pequeñas Empresas (Pipe) de la FAPESP. “Estamos construyendo una infraestructura de datos sobre salud, estilos de vida y multiómicas con 200.000 genomas que la industria podrá emplear para acelerar la búsqueda de nuevos fármacos”, explica.

Puede llegar a erigirse como un buen complemento con miras a la implementación de posibles nuevas estrategias en el ámbito del SUS. “Recién estamos asomándonos a la comprensión del impacto de la genómica en la salud de la población”, afirma Machado Colli. l

Los proyectos y artículos científicos consultados para la elaboración de este reportaje aparecen listados en la versión online

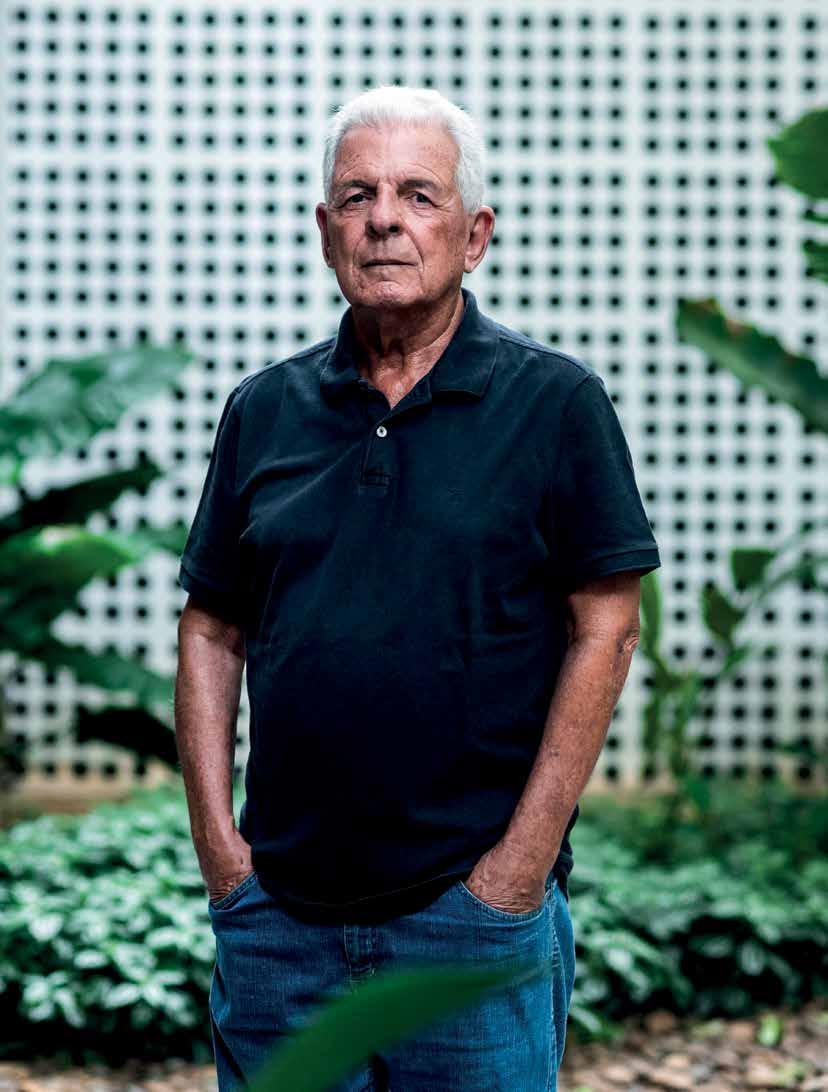

Un llamado de la lógica

El filósofo paulistano revisita su trayectoria académica y comenta sus más de 30 años de labor en la gestión de la financiación de la investigación científica en la FAPESP

ANA PAULA ORLANDI Y FABRÍCIO MARQUES retrato

LÉO RAMOS CHAVES

En 1972, con tan solo 22 años, Luiz Henrique Lopes dos Santos se convirtió en docente del Departamento de Filosofía de la Facultad de Filosofía, Letras y Ciencias Humanas de la Universidad de São Paulo (FFLCH-USP), en donde cursó sus estudios de grado y actualmente es profesor sénior. Por entonces, él formaba parte de una generación de jóvenes investigadores llamada a cubrir el vacío dejado por la jubilación compulsiva y prematura de docentes perseguidos por el régimen militar en Brasil. Bajo la dirección de figuras de renombre como Otília Arantes, José Arthur Giannotti (1930-2021) y Oswaldo Porchat (1933-2017), Lopes dos Santos forjó una carrera que abarcó la filosofía de la lógica y la historia de la filosofía en instituciones tales como la USP, la Universidad de Campinas (Unicamp), la École Normale Supérieure, de P arís, la Universidad París 7 y la Universidad Federal de Río de Janeiro (UFRJ). Su producción académica se centra principalmente en las obras del matemático, lógico y filósofo alemán Gottlob Frege (1848-1925), que fue el tema de su tesis doctoral defendida en 1981 en la USP, y del filósofo austríaco Ludwig Wittgenstein (1889-1951). Uno de sus mayores aportes fue la traducción al portugués del Tractatus logico-philosophicus, escrito en 1921 por Wittgenstein, que incluye una introducción crítica de su autoría.

En simultáneo a su labor docente y su producción en filosofía, se dedicó a la gestión del fomento de la investigación científica. Durante más de tres décadas se desempeñó como coordinador de filosofía y humanidades de la Dirección Científica de la FAPESP, evaluando miles de proyectos presentados por investigadores y ayudando a formular programas de la Fundación. Su trabajo en la FAPESP incluyó la coordinación científica de la revista Pesquisa FAPESP durante 21 años y la formulación del Código de Buenas Prácticas de la Fundación, en 2011. En febrero de 2025, le concedió a Pesquisa FAPESP la siguiente entrevista. Poco tiempo después, Lopes dos Santos recibió un diagnóstico de cáncer y falleció en julio.

¿Cómo surgió su interés por la filosofía?

Cuando tenía alrededor de 15 años me uní al movimiento estudiantil secundario y empecé a leer filosofía política, aunque enseguida migré hacia la filosofía en general. Pero a la hora de decidir qué trayectoria seguiría dudaba entre una opción más clásica, que en mi caso sería el derecho, y la filosofía. Vengo de una familia con muchos abogados y mi padre, que era corredor de bolsa, quería que estudiara derecho. Me presenté al examen de ingreso de ambas carreras y en 1968 empecé en derecho en la USP, donde cursaba por la mañana, y en filosofía en la PUC-SP [Pontificia Universidad Católica de São Paulo], por la tarde.

¿Cuándo eligió el que sería su camino profesional?

En la década de 1960, el recorrido natural de un filósofo era la carrera académica y estaba muy poco institucionalizada. Daba cierta inseguridad. Fue Otília Arantes, mi profesora en la PUC y una de mis grandes referencias académicas quien me puso en la senda de la filosofía. Me mostró que ese camino profesional era

ESPECIALIDAD

Filosofía de la lógica e historia de la filosofía

INSTITUCIÓN

Facultad de Filosofía, Letras y Ciencias

Humanas de la Universidad de São Paulo (FFLCH-USP)

ESTUDIOS

Título de grado (1971) y doctorado (1981) por la USP

posible. Cuando decidí trasladarme a la carrera de filosofía en la USP, en gran parte por influencia suya, ya presentía que la balanza se inclinaba hacia la filosofía. Volví a presentarme al examen de ingreso y entré en la promoción de 1969.

¿Cómo fue ese cambio a filosofía en la USP?

Fue un poco frustrante. En aquella época el departamento perdió docentes debido a las persecuciones a que fueron sometidos por el régimen militar. Durante el primer mes tuve clases con José Arthur Giannotti, quien poco después fue obligado a jubilarse, al igual que Bento Prado Júnior [1937-2007]. Otros, como Ruy Fausto [1935-2020], tuvieron que huir de Brasil. El departamento quedó completamente menguado. A mediados de 1969, en un acto de guapeza, concerté una entrevista con Giannotti en Cebrap [Centro Brasileiro de Análise e Planejamento], institución que él ayudó a fundar y le dije: “Fui a estudiar filosofía a la USP por profesores como usted, que ya no están. ¿Qué hago?”. Él estaba preparando un artículo sobre Durkheim [1858-1917], teórico de la sociología, y me pidió que leyera algunos textos y le expusiese. Pasé la prueba y a partir de entonces, hice de manera informal lo que hoy se conoce como iniciación a la investigación científica bajo la dirección de Giannotti. Cada 15 días iba a su casa a discutir sobre Kant [1724-1804]. Nos hicimos muy amigos.

¿Se recibió en derecho y en filosofía? Durante tres años cursé ambas carreras en forma simultánea. Eso fue así hasta que el asistente de Oswaldo Porchat, mi profesor de lógica, aceptó una excelente oferta de empleo, en términos remunerativos, del Banco do Brasil. A finales de 1970, Porchat se me acercó y me dijo que, si concluía mi carrera el año siguiente, podría ser contratado como su asistente. Para poder hacer dos años en uno tuve que abandonar derecho, pero dejé esa carrera sabiendo que iba a empezar una trayectoria en la filosofía. El llamado de Porchat fue decisivo porque me debatía entre la estética y la lógica.

¿Cómo fue convertirse en docente universitario siendo tan joven? Obviamente estaba muy nervioso. Tenía 22 años y era más joven que la mayoría

de los alumnos. Pero como ya dije, el departamento estaba muy falto de docentes. Recuerdo que también contrataron a varios profesores de mi generación, tales como Carlos Alberto de Moura, Ricardo Ribeiro Terra y Olgária Mattos, entre otros. Algunos fueron invitados por Giannotti a participar en un seminario en Cebrap, que se extendió de 1971 a 1973. Esa experiencia fue muy importante para mi formación por el alto nivel de los debates.

¿La noticia de que había sido contratado dejó a su padre más tranquilo en cuanto a su elección profesional? Se sintió aliviado al enterarse de la novedad, ya que estaba muy preocupado por mi futuro. Pero por desgracia murió poco tiempo después, a los 49 años, a finales de 1971. Él tenía un buen pasar, pero no era rico. Prefería viajar antes que ahorrar dinero. Después de su muerte, mi madre, que era ama de casa, tuvo que mantenerse por su cuenta. Fue a trabajar con su hermano y decidió estudiar ciencias sociales. A sus casi 43 años, aprobó el examen de ingreso en la USP, en la década de 1970. Solíamos cruzarnos en la universidad, yo como docente y ella como alumna. Tras graduarse, entró a trabajar en la Fundación

de Apoyo a los Trabajadores Presos, donde permaneció hasta jubilarse en la década de 1990. Su tarea era ocuparse del departamento de alfabetización y cumpliendo esa labor mantuvo contacto con reclusos como Chico Picadinho, un famoso asesino serial de las décadas 1960 y 1970. Mi mamá era muy dinámica y ya en la época en que era ama de casa se había sumado a la militancia católica progresista. Para mí eso incluso fue un aliciente para unirme al movimiento estudiantil secundario en 1964, poco antes del golpe militar.

¿Qué estudió en su maestría?

No tengo título de magíster. Comencé mi investigación de maestría en la USP bajo la dirección de Porchat, en 1972, que versaba sobre el matemático, lógico y filósofo alemán Gottlob Frege. Pero cuando iba a empezar a redactar mi tesina, Porchat me pidió que fuera su mano derecha en el Centro de Lógica, Epistemología e Historia de la Ciencia y también en el Departamento de Filosofía que se aprestaba a crear en la Unicamp. Eso fue en 1975. Cuando acepté su invitación, me advirtió que de momento sería imposible que continuara con mi investigación de maestría.

¿Cómo surgió la idea del centro?

Cuando mi padre murió, mi madre tuvo que salir a trabajar y simultáneamente, casi con 43 años, ingresó a la carrera de ciencias sociales en la USP

Porchat había querido crearlo en la USP, pero el departamento de filosofía rechazó su propuesta por diferencias ideológicas. Vivíamos en un ambiente muy polarizado. Los de la lógica éramos considerados reaccionarios y alienados, porque nuestro campo estaba supuestamente vinculado al capitalismo, como pensaban algunos miembros del departamento. Pero Porchat era muy amigo del que a la sazón era el vicerrector de la Unicamp, el ingeniero y físico Rogério Cesar de Cerqueira Leite [1931-2024], quien le dijo al entonces rector de la Unicamp, Zeferino Vaz [19081981], que estaban ante una oportunidad única para la universidad en el área de la filosofía. Vaz se entusiasmó con la idea de un centro interdisciplinario y suministró las condiciones materiales que ninguna otra iniciativa vinculada con la filosofía disponía en aquel momento en Brasil. Ello hizo posible, por ejemplo, traer investigadores visitantes del exterior y organizar coloquios internacionales. El centro fue fundado en 1977 y aún sigue activo.

¿Cómo estaba compuesto?

Estaba formado por investigadores del departamento de filosofía de la Unicamp y de áreas tales como matemática, sociología, física, lingüística y teología. A mí me tocó cooperar con el Instituto de Estudios del Lenguaje [IEL], en donde dicté clases entre 1977 y 1981.

¿Existía una comunidad de lógicos en Brasil?

En efecto, pero era y sigue siendo muy pequeña. El más conocido era Newton da Costa [1929-2024], quien en aquella época estaba en la USP, pero era una gran influencia para algunos de los miembros del centro como Ayda Arruda e Itala D’Ottaviano. En aquel entonces yo también me acerqué a Da Costa y a su lógica paraconsistente y publiqué algunos trabajos. Más allá de sus aportes al campo de la lógica, el centro fue fundamental para la conformación de una comunidad académica de la filosofía en Brasil. Había entonces varios centros con gente altamente calificada, diseminados por diversos estados del país. Al articular estas islas de conocimiento a través de sus actividades, el centro contribuyó, por ejemplo, para la creación de la Anpof [Asociación Nacional de Posgrado en Filosofía], en 1983.

¿Qué estudió en su doctorado?

Mi doctorado, bajo la dirección de Porchat, fue una ampliación de mi investigación de maestría inconclusa. Procuré entender de qué manera Frege promovió, en la segunda mitad del siglo XIX, una ruptura con el modelo lógico aristotélico, vigente por casi 2.000 años. Para dar respuesta a las preguntas que surgieron durante su investigación sobre los fundamentos de la matemática, se vio obligado a repensar la lógica, lo que lo llevó a la concepción de lo que hoy en día llamamos lógica matemática. La Unicamp me ofreció un contrato como profesor doctor, con el compromiso de que concluyera mi tesis en 1980, pero me costó mucho terminarla. Entre 1975 y 1978 prácticamente no avancé en la investigación, porque estaba inmerso en la burocracia del departamento y del centro, dando clases y realizando seminarios. En 1978 la retomé y logré defender la tesis en 1981. Mi trabajo salió publicado en 2008 con el título O olho e o microscopio [Nau Editora].

Permaneció en la Unicamp hasta 1981. ¿Qué lo motivó a volver a la USP?

El centro que creamos en la Unicamp en los años 1970 fue fundamental para la formación de una comunidad académica de la filosofía en Brasil

Fue una cuestión personal. Entonces me había separado y mis hijos, que todavía eran pequeños, vivían con la madre en São Paulo. Como no quería vivir yendo y viniendo por la carretera, regresé al departamento de filosofía de la USP. Por la misma época Giannotti también retornó a la USP e impartíamos juntos la asignatura de Introducción a la Filosofía en el primer año de la carrera. Él dictaba la clase inaugural o las teóricas y yo hacía seminarios con los alumnos, analizando los textos, leyéndolos y releyéndolos varias veces. Formamos a varias generaciones de filósofos.

En la década de 1990 tradujo para la editorial de la Universidad de São Paulo [Edusp] el Tractatus logico-philosophicus, escrito en 1921 por el austríaco Ludwig Wittgenstein. ¿Cuáles fueron los retos que supuso ese trabajo? No es nada fácil traducir del alemán al portugués una obra tan compleja como la de Wittgenstein, uno de los grandes filósofos del lenguaje. Para hacerse una idea, el estudio introductorio que hice para explicar el lugar que ocupa el Tractatus en la historia de la filosofía es más extenso que la obra en sí. Giannotti ya lo había

traducido y había escrito una introducción en 1968. Fue la segunda traducción de la obra en el mundo, después de la inglesa, y fue una tarea hercúlea para Giannotti, ya que Wittgenstein había muerto hacía tan solo 17 años. Era su contemporáneo y prácticamente no existía literatura sobre su obra. En la década de 1990, Edusp le propuso a Giannotti hacer una nueva edición de su versión en portugués.

El propio Giannotti dijo que el trabajo que hizo en la década de 1960 contenía muchos errores. ¿Está de acuerdo? Tenía algunos errores, pero no en la traducción del alemán en sí, sino conceptuales, porque en la época había muy poca familiaridad con aquel universo. Es el caso de algunos términos específicos de la filosofía alemana de finales del siglo XIX, referentes a filósofos como Franz Brentano [1838-1917], que pocos leían en Brasil. Cuando recibió la propuesta de Edusp en la década de 1990, Giannotti me pidió que hiciera una revisión, pero consideré que eso daría lugar a una especie de frankenstein y propuse rehacer la traducción. Giannotti aceptó y me encomendó esa misión.

Entre 1986 y 2007, Giannotti dirigió el Programa de Formación de Cuadros de Cebrap. ¿Qué papel cumplió usted en él?

Era un programa de formación interdisciplinaria dirigido a estudiantes de posgrado de diversas áreas del conocimiento, posible gracias a un convenio entre la Capes [Coordinación de Perfeccionamiento del Personal de Nivel Superior] y Cebrap. El ingreso al mismo era difícil. A lo largo de dos años, estos alumnos participaban en actividades tales como seminarios de antropología, ciencia política, sociología, economía y filosofía. Los encuentros tenían lugar dos veces por semana y entre los docentes estaban Paul Singer [1932-2018] y Ruth Cardoso [1930-2008]. Yo participé activamente en el núcleo de filosofía hasta que me fui a París, a finales de la década de 1990.

En 1986 llegó a la FAPESP. ¿Cómo era la Fundación en aquella época?

En 1986, Flavio Fava de Moraes, en ese entonces director científico de la FAPESP, me invitó a sumarme en reemplazo de João Paulo Monteiro [1938-2016] en el área de filosofía de la Coordinación de Ciencias Humanas y Sociales. No existía

la figura del coordinador general, pero, por su personalidad y su trayectoria, esa función la cumplía Leôncio Martins Rodrigues [1934-2021]. Estaban Boris Fausto [1930-2023] en Historia, Maria Alice Vanzolini en Psicología, Cláudia Lemos en Lingüística y estaba yo en Filosofía.

El volumen de trabajo era pequeño en aquella época en comparación con lo que es actualmente, ¿verdad? Íbamos los lunes y lo primero que hacíamos al empezar la reunión era comentar los partidos de fútbol de la fecha del domingo: Boris Fausto, como yo, era fanático de Corinthians. Había unos 15 o 20 expedientes para analizar por semana. Cada uno de nosotros recibía unos cuatro. Los estudiábamos, elaborábamos un informe y decidíamos si se concedía la ayuda o la beca o no. Y nos íbamos. Era otro mundo. Acababa de producirse un cambio que transformaría el perfil de la FAPESP, merced a una enmienda introducida en la Constitución del Estado de São Paulo, presentada por el diputado Fernando Leça y aprobada en 1983, que establecía que las transferencias del Tesoro a la FAPESP, que eran el 0,5 % de la recaudación fiscal de la época, se calcularían sobre la base del año en curso y se girarían en 12 cuotas mensuales. Anteriormente, el cálculo era sobre la base de la recaudación del año anterior y los fondos llegaban corroídos por 13 meses de inflación. Tras la Enmienda Leça, como pasó a conocérsela, la Fundación tomó conciencia de que contaba con potencial financiero para volar más alto. Esto se hizo patente en 1989, cuando la nueva Constitución del Estado aumentó los fondos asignados a la Fundación al 1 % de los ingresos fiscales del estado paulista.

En la práctica, ¿cómo se materializó esa ambición?

Uno de los hitos fue la iniciativa de los proyectos temáticos. En los años 1960 y 1970, la FAPESP había tenido grandes proyectos, pero fueron puntuales, como el estudio de la biodiversidad amazónica que llevó a cabo el zoólogo Paulo Vanzolini [1924-2013] en la década de 1960. Los proyectos temáticos fueron la primera línea regular de grandes ayudas. En el seno de la FAPESP surgió un debate sobre si valía la pena darle tanto dinero a las humanidades: una cosa era conceder becas de maestría y otra muy distinta aprobar el

presupuesto de un proyecto temático. El mérito fue de Fava de Moraes, quien fue muy firme realmente. Uno de los primeros proyectos temáticos de humanidades fue del cineasta Jean-Claude Bernardet, de la USP, cuyo producto fue una película. Yo fui el coordinador del área de filosofía hasta 1989. Martins Rodrigues se fue y Fava de Moraes me invitó a asumir como coordinador adjunto. Hasta 1989, los coordinadores de área asistían a la FAPESP una vez por semana y no mantenían ninguna relación orgánica con la Fundación. Cuando Fava de Moraes creó la figura de los coordinadores adjuntos, éstos pasaron a efectuar la mediación entre los coordinadores de área y el director científico. En 1993, José Fernando Perez asumió la dirección científica, me pidió que continuara y acepté.

En 1997 se alejó de la FAPESP para pasar una temporada en Francia, pero al volver al país regresó a la Fundación. ¿Cómo se dio este retorno? Pasé dos años en París como investigador visitante en la École Normale Supérieure y como docente en la Universidad París 7, y durante ese tiempo me reemplazó en la Fundación la antropóloga Paula Montero.

Cuando regresé, a principios de 1999, me convocaron para que trabajara con ella, porque ya eran necesarios dos coordinadores adjuntos en el área de humanidades. Perez tenía una dinámica creativa propia y reestructuró la dirección científica. Amplió la cantidad de coordinadores adjuntos y cada semana nos reuníamos durante dos o tres horas en una mesa redonda para hablar de lo que estaba ocurriendo. Muchos de los programas de la FAPESP fueron alumbrados en el marco de aquellas reuniones. La efervescencia de la época de Perez tuvo mucho que ver con ese diálogo entre la gente de todas las áreas. Eso alcanzó una escala aún mayor cuando Carlos Henrique de Brito Cruz asumió la dirección científica. Una vez al mes, los 15 coordinadores adjuntos se reunían y conversaban toda una tarde.

¿Con cuántos directores científicos trabajó?

Uno de los primeros proyectos temáticos del área de humanidades fue el del cineasta

Jean-Claude Bernardet, de la USP, que resultó en una película

Fueron cuatro. La última administración, de Luiz Eugênio Mello, quedó muy comprometida debido a la pandemia, pero él hizo milagros. Me reemplazó en la coordinación adjunta por Ângela Alonso, pero solo la conoció en persona al final de su mandato. Mantuvo la dirección científica funcionando e hizo cosas importantes, como el esfuerzo para generar investigaciones sobre el covid-19 y los primeros proyectos del Programa Generación, dirigido a los investigadores más jóvenes, que aún no tenían empleo. También impulsó la adopción de políticas de inclusión y equidad. La gestión de Fava de Moraes le imprimió a la FAPESP ambiciones mayores y creó una estructura institucional para que la Fundación trabajase de forma creativa. Perez sacó provecho de ello gracias a su personalidad. Era el entusiasmo en persona. Cuando Brito Cruz asumió el cargo, ya había una cantidad enorme de programas con cuatro o cinco años de antigüedad. Por su propia personalidad, racional y sistemática, Brito Cruz también impuso un orden a las cosas, las formalizó, vio lo que funcionaba y lo que no. Intensificó y perfeccionó los programas existentes y le abrió la puerta a un arduo esfuerzo de internacionalización de la investigación científica paulista.

¿Cuál fue su aporte a la implementación del Programa de Educación Pública?

Una de las revoluciones que encaró Perez

fueron los programas de investigación tecnológica, principalmente en colaboración con empresas. Pero tuvo el acierto de tener en cuenta a la investigación aplicada en un sentido amplio. La investigación en el campo de las humanidades puede aplicarse y llevar a la formulación y a la puesta en marcha de políticas públicas. La idea de Perez era que cuando se trata de investigación aplicada, se necesita tener un socio que potencialmente vaya a utilizarla. De ahí surgió la idea de empezar por la educación pública, haciendo investigaciones en colaboración con las escuelas públicas. Convocamos a Maria Malta Campos, de la PUC-SP y la Fundación Carlos Chagas para que nos asesorara. Durante un tiempo coordiné el proyecto y luego le pasé la posta a Marilia Sposito. Como funcionó, hubo demanda, colaboraciones, de todo. Y después se lanzó el Programa de Políticas Públicas.

¿Cómo surgió la revista Pesquisa FAPESP, de la que usted sería coordinador científico entre 2001 y 2022? El proyecto surgió de una charla entre Perez y quien entonces era la directora de redacción, Mariluce Moura. Yo me subí al tren ya en marcha, porque cuando surgió la idea me encontraba en París. Desde un principio, el objetivo fue hacer una revista de divulgación, no de la FAPESP, sino de la ciencia brasileña y, en particular, la ciencia producida en São Paulo. En segundo lugar, tenía que ser un medio de carácter periodístico y orientado por científicos. Para ello fue fundamental que haya sido un proyecto vinculado a la Dirección Científica. Esto permitió la creación de estándares que garantizaron la calidad que la revista fue desarrollando.

¿Se refiere, por ejemplo, a que la revista cuente con un Comité Científico integrado por coordinadores de área y adjuntos de la Dirección Científica? Desde el principio, los artículos de la revista eran leídos por los coordinadores de las áreas temáticas abordadas. La idea era que mantener un equilibrio entre el lenguaje periodístico y el rigor científico. Por un lado, hubo quienes dijeron que la revista no era lo suficiente rigurosa desde un punto de vista científico. Y por otro, que planteaba temas difíciles de entender para el público lego. Las críticas de unos y otros nos hicieron pensar que la revista iba por el camino correcto, el camino del medio.

La política de buenas prácticas científicas debe ser pedagógica, pero una manera de educar es no dejar que las conductas equivocadas queden impunes

que se mantiene hasta los días actuales en la página web de la FAPESP. Luego, Brito Cruz me pidió que redactara un anteproyecto de un código de buenas prácticas. Pasé seis meses dedicado a esa tarea. Discutí el borrador con Celso Lafer, por entonces presidente de la FAPESP, quien me proporcionó el sostén jurídico necesario. Así salió la segunda versión, que Brito Cruz hizo circular entre prorrectores y sociedades científicas. Llevamos a cabo una consulta amplia y lo publicamos a finales de 2011. Diez años después de la publicación del código, todas las universidades públicas paulistas ya tenían sus propias comisiones de buenas prácticas.

En 2001, usted y el profesor Perez escribieron un artículo sobre los conflictos de intereses en la investigación científica. ¿Eso marcó el inicio del debate que desembocaría en el Código de Buenas Prácticas Científicas, una década más tarde?

Fue algo puntual. La FAPESP no contaba con una política de conflicto de intereses porque nunca se había topado con un problema serio al respecto. Y hubo un problema grave con un proyecto de un investigador para evaluar los riesgos del amianto o asbesto para la salud humana. Se invirtió mucho dinero y los resultados fueron favorables al amianto. Entonces, salió a la luz que el investigador en cuestión estaba vinculado a una empresa productora de amianto.

¿Y cómo surgió el Código de Buenas Prácticas Científicas?

Fue algo que se me ocurrió de repente. En septiembre de 2010, me había sometido a una cirugía de apéndice en Río de Janeiro y me estaba recuperando, cuando recibí un pedido de Brito Cruz para que estudiara lo que existía en el mundo en materia de buenas prácticas. Me aboqué a ese estudio, que dio lugar a un texto, a principios de 2011,

Después usted empezó a realizar un seguimiento de los casos de mala conducta que llegaban a la Fundación. Siempre insistí, y Brito Cruz me dio todo su apoyo, en que el eje principal de la política de buenas prácticas debe ser pedagógico. Pero una de las maneras de educar es no dejar que las conductas equivocadas queden impunes. Es necesario contar con un sistema riguroso y justo de recepción de denuncias y de investigación y transparencia en los resultados. Esto cuesta bastante trabajo. Cuando se recibe una denuncia, debe garantizarse un tiempo para la defensa. Son las propias instituciones las que están en condiciones de averiguar lo que sucede en sus dependencias. Ellas pueden hacerlo de manera imparcial y objetiva, pero existen situaciones en las que se dejan llevar por el corporativismo. En estos casos, debe rechazarse la averiguación de la institución y se genera una crisis política. Me ocupé de ello desde 2011 hasta 2023. En su mayoría los casos no dieron problemas, pero los pocos que sí lo hicieron fueron difíciles.

¿Actualmente se reparte entre São Paulo y Río de Janeiro?

Así es. Soy profesor sénior en la USP y dirijo trabajos de posgrado en filosofía. Además, soy docente colaborador en la UFRJ, donde participo en seminarios e imparto cursos libres. Como ya estoy jubilado, ahora tengo más tiempo para dedicarme a la escritura académica. En los últimos cinco años me he dedicado a estudiar el pensamiento de Aristóteles y he publicado algunos artículos sobre el tema. Pero no tengo prisa. En el campo de la filosofía, la producción teórica es una tarea que requiere paciencia. l

Las redes que vinculan a universidades y empresas

Un estudio mapea las actividades de 240 laboratorios académicos brasileños para comprender cómo interactúan con el sector industrial

FABRÍCIO MARQUES

Cómo se establecen las relaciones entre las universidades y las empresas de Brasil para generar conocimiento?

Una dupla de investigadores de la Facultad de Economía, Administración y Contabilidad de Ribeirão Preto de la Universidad de São Paulo (FEARP-USP) se propuso responder esta pregunta analizando qué factores estaban asociados a la interacción entre empresas y 240 laboratorios de universidades públicas del estado de São Paulo. Algunas de las conclusiones de ese estudio, publicado en diciembre de 2024 en la revista Science and Public Policy, confirmaron los resultados de trabajos similares realizados en otros países: en comparación con los laboratorios menos vinculados con empresas, los que están más comprometidos se destacan por su capacidad de prospección y atracción de colaboradores del sector privado, disponen de equipamientos avanzados y poseen más investigadores permanentes

Laboratorio de Nuevos Materiales y Dispositivos de la Unesp en Bauru, São Paulo: colaboración con una empresa extranjera

para dar soporte a proyectos conjuntos. También cuentan con un mayor respaldo de sus departamentos para hacer viables las cooperaciones. Pero hay peculiaridades brasileñas. Una de ellas consiste en que aquí, el nivel sénior en la carrera docente no está relacionado con una mayor interacción con la industria, un patrón que suele observarse en Estados Unidos y Europa, y que se explica por la formación paulatina de redes de colaboración a lo largo de la carrera docente. De los 240 laboratorios paulistas analizados, tan solo 55 estaban dirigidos por profesores titulares, el nivel más alto en la carrera académica pública, mientras que 114 estaban bajo el mando de profesores libre docentes o asociados y 71 bajo el liderazgo de profesores adjuntos. Según el coordinador del estudio, Alexandre Dias, investigador de la FEA-RP-USP, este resultado pone de relieve las marcadas diferencias entre el sistema brasileño de ciencia, tecnología e innovación y los de países más desarrollados.

“En las universidades públicas brasileñas, la enseñanza, la investigación y la extensión son indisociables y además, los académicos del nivel más alto de la carrera suelen estar profundamente implicados en las actividades de gestión de sus unidades. La predominancia de la financiación pública de la investigación, el sistema de recompensas y los criterios por los que se evalúa a los docentes para su progresión en la carrera no contribuyen a un desempeño individual alineado con la interacción con el sector industrial”, dice el investigador, quien llevó a cabo el estudio junto a Leticia Ayumi Kubo Dantas, a quien dirigió en su tesina de maestría, defendida en 2023. Ambos son miembros del Núcleo de Investigaciones en Innovación, Gestión Tecnológica y Competitividad de la FEA-RP-USP. El objetivo principal del estudio consistió en analizar el grado de “compromiso académico” de los laboratorios de investigación del país. Este concepto, difundido a partir de 2013 por Markus Perkmann, de la Escuela de Negocios del Imperial College de Londres, en el Reino Unido, aglutina a un conjunto de actividades formales e informales que modulan la interacción entre las universidades y el ambiente empresarial. “Durante mucho tiempo, los investigadores trataron de entender los determinantes de la comercialización de tecnologías y de los emprendimientos académicos como fenómenos para analizar la interacción universidad-empresa. Solo en la última década ha crecido el interés por investigar también otros canales a través de los cuales se establecen los vínculos entre universidad y empresa”, explica Dias.

Se analizaron datos de laboratorio de siete instituciones –la Universidade Estadual Paulista (Unesp), la Universidad de Campinas (Unicamp), la Universidad de São Paulo (USP), las universidades federales de São Paulo (Unifesp), de São Carlos (UFSCar) y del ABC (UFABC) y el Instituto Tecnológico de Aeronáutica (ITA)– cuyos directivos aceptaron responder un cuestionario en línea. En cuanto a las áreas del conocimiento, un 20 % de los laboratorios era de ingenierías, un 15,8 % de ciencias de la salud, un 14,5 % de ciencias biológicas, un 12,5 % de ciencias exactas y de la Tierra, un 9,6 % de ciencias agrarias y un 27,5 % operaba en múltiples disciplinas. El análisis permitió discriminar las instalaciones de investigación en tres categorías. El conglomerado más numeroso, con 112 laboratorios, registraba una implicación mínima y esporádica con empresas. El segundo agrupaba a 84 laboratorios y mostraba un compromiso parcial con la iniciativa privada. El tercer grupo, con 44 laboratorios, se destacaba por interactuar con las empresas a través de diversos canales: investigaciones conjuntas (un 52,3 %), contratos de investigación (un 40,9 %) y ampliación de las instalaciones con fondos procedentes inversores privados (un 34,1 %). También

participaban en actividades de interacción informales, tales como capacitación de estudiantes de posgrado en proyectos industriales (un 15,9 %) y servicios de consultoría (un 22,7 %).

El valor económico de los equipos de los laboratorios altamente comprometidos y su número de investigadores permanentes resultaron ser tres veces superiores que los de las instalaciones que interactuaban mínimamente con empresas. El respaldo de los departamentos a los que los laboratorios están vinculados fue mayor entre los de alta implicación: el 32 % declaró recibir apoyo suficiente, frente a un 13,4 % en los de compromiso mínimo y un 22,6 % en los da la categoría intermedia. Según Leticia Dantas, la autora principal del estudio, la investigación muestra la importancia de fortalecer los laboratorios universitarios, asegurando una estructura sólida y equipos más grandes. “Ello no solo aumenta el compromiso académico, sino que también vuelve a los laboratorios más atractivos para las colaboraciones con el sector industrial, ampliando el impacto de la investigación en el sector productivo”, dice. El economista Eduardo da Motta e Albuquerque, de la Universidad Federal de Minas Gerais (UFMG) e investigador del Centro de Desarrollo y Planificación Regional (Cedeplar), quien no participó en el estudio, coincide en que una de las contribuciones del artículo consiste en demostrar la importancia del fortalecimiento de los laboratorios de investigación del sistema universitario brasileño. “La interacción atrae inversiones a los laboratorios y esto repercute tanto en la calidad de la investigación, al llevar a la universidad nuevos temas de estudio, como en la enseñanza, al aproximar a docentes y alumnos a las demandas de la sociedad”, dice Da Motta e Albuquerque, estudioso de la formación de redes de innovación y de vínculos creados entre universidades y empresas.

“También sería interesante ahondar en las investigaciones para saber qué segmentos de la industria interactúan más con esos laboratorios”, dice. El investigador supone que hay grandes interacciones con el sector agrícola, por la importancia económica que tiene este segmento en Brasil, pero actividades mínimas con empresas farmacéuticas, que concentran sus investigaciones en sus matrices en el exterior. Da Motta e Albuquerque ve una señal de alarma en un resultado que aparece en el artículo, pues no se detectó correlación entre el compromiso de los laboratorios con las empresas y el apoyo de los Núcleos de Innovaciones Tecnológicas, oficinas creadas en virtud de la Ley de Innovación, de 2004, en las instituciones públicas de ciencia y tecnología para gestionar la propiedad

intelectual y apoyar la interacción entre universidades y empresas. “El país ha hecho una gran inversión para la creación de estos centros y tal vez sea el momento de revaluar su operación”, dice. Para crecer, la relación entre universidades y empresas debe superar una serie de obstáculos, a juicio del químico Elson Longo, profesor emérito de la Universidad Federal de São Carlos (UFSCar) y director del Centro para el Desarrollo de Materiales Funcionales, uno de los Centros de Investigación, Innovación y Difusión (Cepid) financiados por la FAPESP. “Parte de la interacción existente es fruto de los servicios de consultoría que los investigadores prestan a las empresas. La cooperación debe ser más ambiciosa para traducirse en nuevos conocimientos y productos innovadores”, dice, citando como ejemplo proyectos desarrollados por el Cepid durante las últimas décadas con la industria siderúrgica y de cerámica y revestimientos, que ha llevado a introducir cambios en los métodos de producción y a un aumento de la productividad. Actualmente, la institución mantiene colaboraciones para el desarrollo de insumos destinados a fábricas de cosméticos. También menciona el escaso interés de las multinacionales por colaborar con grupos brasileños, que prefieren, por regla general, utilizar la estructura de Investigación y Desarrollo (I&D) de sus casas matrices.

Emilio Carlos Nelli Silva, del Departamento de Mecatrónica y Sistemas Mecánicos de la Escuela Politécnica de la USP [Poli-USP], ve diferencias notorias entre la interacción de universidades y empresas en Brasil y en otros países. “En Estados Unidos, el vínculo es más fluido, porque las empresas contratan a muchos doctores para trabajar en sus centros de I&D y es con ellos que se concreta la interlocución con los grupos de las universidades. Aquí en Brasil, como hay pocos doctores trabajando en las empresas, son otros los actores que intervienen en el diálogo y a veces no se comprende que el trabajo de investigación puede enfrentar obstáculos”, afirma.

Otra diferencia tiene que ver con la financiación. “Aquí no tenemos una cultura de inversión de capi-

Laboratorio de inspección del Centro de Investigaciones de Petrobras: la legislación impulsa las colaboraciones

Los laboratorios comprometidos interactúan con las empresas a través de múltiples canales

tal de riesgo en investigaciones prometedoras. Pero en algunas áreas, tales como petróleo y gas, y electricidad, las empresas tienen la obligación legal de invertir en I&D y esto crea buenas oportunidades de investigación en colaboración”, sostiene. Actualmente, Nelli Silva es vicedirector del programa de ingeniería del Centro de Investigaciones para la Innovación en Gases de Efecto Invernadero (RCGI), uno de los Centros de Investigación Aplicada/ Centros de Investigaciones en Ingeniería financiados por la FAPESP en colaboración con empresas, en este caso, Shell. Este programa de la Fundación ofrece fondos no reembolsables para proyectos de empresas, y les exige que aporten una contrapartida igual o superior a la inversión pública; y cuenta con la participación de grupos de investigación de excelencia de las universidades. “Los centros crean un nuevo paradigma para la colaboración entre universidades y empresas y aportan beneficios a la sociedad que pueden percibirse fácilmente”.

Ajuicio del físico Carlos Frederico de Oliveira Graeff, de la Facultad de Ciencias de la Unesp, en su campus de la localidad de Bauru, la relación entre las universidades y la industria ha mejorado, pero siguen existiendo asimetrías. “La industria no siempre encuentra en el mundo académico las soluciones a sus problemas, ni tampoco los investigadores empeñados en establecer interacciones encuentran siempre empresas interesadas en su capacidad”, dice. De Oliveira Graeff coordina el Laboratorio de Nuevos Materiales y Dispositivos, una de las instalaciones de investigación participantes en el estudio de la FEA-RP-USP, que fue clasificada entre los laboratorios con alto nivel de vinculación. El laboratorio, que actualmente busca nuevos materiales para su aplicación en dispositivos electrónicos, tales como células solares y transistores, coopera con dos empresas. Una de ellas es una startup con sede en Singapur, que busca

darle un uso a los residuos de las industrias que utilizan moscas como materia prima para producir proteínas animales. El reto pasa por aprovechar el gran volumen de exoesqueletos de moscas desechados, que son ricos en un tipo de biomelécula denominada melanina, un compuesto para el que el grupo de D e Oliveira Graeff estudia posibles aplicaciones en baterías y capacitores, porque tiene potencial para almacenar energía. La otra es una empresa nacional, a la que el laboratorio le ha transferido tecnología útil para la producción de células solares de perovskita, desarrollada en un proyecto apoyado por Petrobras.

Según él, las interacciones podrían ser más productivas si en el país hubiera mayor disponibilidad de plataformas multiusuarios y centros analíticos a los que los investigadores de las empresas pudieran recurrir. “Las startups necesitan equipos avanzados para desarrollar productos y a menudo no cuentan con los recursos necesarios para adquirirlos”, afirma De Oliveira Graeff, quien fue coordinador de Programas Estratégicos e Infraestructura de la Dirección Científica de la FAPESP. El físico también considera importante ampliar las actividades de las instituciones de investigación que trabajan con aplicaciones con un nivel de madurez tecnológica intermedio, que todavía requieren esfuerzos e inversiones para obtener un producto comercial. “La estatal Embrapa [Empresa Brasileña de Investigación Agropecuaria] desempeña bien este papel en el agronegocio y el Senai [Servicio Nacional de Aprendizaje Industrial], con sus Institutos de Innovación, también lo ha hecho en distintos sectores de la industria”, dice. También destaca el modelo de los Centros de Ciencia para el Desarrollo (CCD) de la FAPESP, que aglutinan a investigadores de institutos estaduales, universidades, empresas y organismos de gobierno en busca de soluciones para problemas de la sociedad, de la productividad agrícola y de la movilidad urbana. “Estos centros están logrando movilizar el sistema en torno de investigaciones orientadas a misiones”, añade. l

Laboratorio de Células de Combustible y Conversión Reactiva, en la Poli-USP: innovación y gases de efecto invernadero

Buenos con la pelota y con razón

El remate de volea del atacante Richarlison que definió el marcador del partido contra Serbia en el Mundial 2022

Los jugadores de los principales equipos del fútbol brasileño tienen mejor memoria, capacidad de planificación y ductilidad mental que las personas de su misma edad que no son atletas

GISELLE SOARES

El jueves 24 de noviembre de 2022, los brasileños seguían con atención el debut de su selección de fútbol contra Serbia, en la Copa Mundial de Catar. Más de dos años después, quizá haya pocos que recuerden ese partido, que finalizó con el triunfo de Brasil por 2 a 0, pero el gol de volea del delantero Richarlison aún está presente en la memoria de los aficionados. Con su zurda, amortiguó la pelota tras un pase de tres dedos combado enviado por Vinicius Junior y, con un salto coreográfico, clavó un derechazo certero en el arco contrario. La instantánea de ese momento, elegido como el mejor gol de la competencia por votación popular de la Federación Internacional de F útbol Asociado (Fifa), ilustra el perfil del atleta en una red social.

Jugadas como ésa, que son un deleite incluso para quienes no siguen este deporte, no dependen solamente de la suerte o de una habilidad física extraordinaria. Además de un profundo conocimiento técnico del juego, los atletas que las ejecutan poseen una capacidad para procesar información y tomar decisiones bajo presión superior a la de otros individuos de su misma edad y nivel educativo, según lo sugiere un estudio publicado en enero en la revista científica Proceedings of the National Academy of Sciences (PNAS).

En dicho estudio, un grupo internacional de investigadores que contó con la participación del brasileño Alberto Filgueiras, de la Universidad Central de Queensland, en Australia, ahondó en los rasgos de la personalidad y las habilidades cognitivas de 153 jugadores de fútbol

de equipos de la serie A del Campeonato Brasileño y de 51 futbolistas del campeonato de la máxima categoría de Suecia: la edad de los deportistas oscilaba entre los 17 y los 35 años. Según los autores éste es, hasta la fecha, el estudio que ha realizado la más exhaustiva evaluación psicológica y cognitiva del mayor número de jugadores de élite. Los estudios anteriores incluían a pocos deportistas en la cumbre de sus carreras y tan solo una parte de las pruebas.

En el trabajo publicado en PNAS, cada futbolista fue sometido a tres baterías de pruebas neuropsicológicas. Una de ellas definió los rasgos de la personalidad del participante, mientras que las otras dos, una de las cuales desarrollada por Filgueiras y sus colaboradores y publicada en 2023 en la revista BMC Psychology, midieron sus habilidades cognitivas: características tales como la creatividad, la flexibilidad mental y la memoria de corto plazo, así como la capacidad de mantener la atención, planificar y resolver problemas e inhibir respuestas inadecuadas. En todos los test cognitivos, los jugadores obtuvieron un puntaje promedio superior al valor de referencia para la población del mismo rango de edades o a la de los miembros del grupo de control, integrado por 124 brasileños del mismo grupo etario y nivel educativo que no eran jugadores de fútbol.

A la superioridad de los futbolistas en cuanto a estas características cognitivas, importantes para reaccionar rápidamente, cambiar de estrategia o crear jugadas en el fragor del partido, se le añadieron rasgos de la personalidad que también favorecen la confianza en sí mismos y el trabajo