LA BIOLOGIA SCIENZA DEL FUTURO

L’epigenetica e la genomica consentono di prevedere e curare le malattie, aiutandoci a vivere meglio e di più

UN SOGNO CHE È REALTÀ

Tutta la biologia al servizio della comunità

19 - 21 GIUGNO 2026

Centro Congressi G. Colosimo

Catanzaro

Anno IX - N. 1 Gennaio 2026

Edizione mensile di Bio’s

Testata registrata al n. 113/2021 del Tribunale di Roma

Diffusione: www.fnob.it

LA BIOLOGIA SCIENZA DEL FUTURO

L’epigenetica e la genomica consentono di prevedere e curare le malattie, aiutandoci a vivere meglio e di più

Direttore responsabile: Vincenzo D’Anna

Questo magazine digitale è scaricabile on-line dal sito internet www.fnob.it

Questo numero del “Giornale dei Biologi” è stato chiuso in redazione il 29 gennaio 2026.

Gli articoli e le note firmate esprimono solo l’opinione dell’autore e non impegnano la Federazione Nazionale degli Ordini dei Biologi.

Immagine di copertina: @ Shutterstock AI/shutterstock.com

Si informano gli iscritti che gli uffici della Federazione forniranno informazioni telefoniche di carattere generale dal lunedì al giovedì dalle 9:00 alle ore 13:30 e dalle ore 15:00 alle ore 17:00. Il venerdì dalle ore 9:00 alle ore 13:00

Tutte le comunicazioni dovranno pervenire tramite posta (presso Federazione Nazionale degli Ordini dei Biologi, via Icilio 7, 00153 Roma) o all’indirizzo protocollo@cert.fnob.it, indicando nell’oggetto l’ufficio a cui la comunicazione è destinata.

È possibile recarsi presso le sedi della Federazione Nazionale degli Ordini dei Biologi previo appuntamento e soltanto qualora non sia possibile ricevere assistenza telematica. L’appuntamento va concordato con l’ufficio interessato tramite mail o telefono.

Centralino 06 57090 200

Ufficio protocollo protocollo@cert.fnob.it

I Biologi nel terzo millennio

di Vincenzo D’Anna

Presidente della Federazione Nazionale degli Ordini dei Biologi

Abbiamo più volte scritto e ribadito, sulle colonne di questo giornale dedicato ai biologi italiani, che la difficoltà più grande da affrontare per coloro che, attraverso libere elezioni, sono stati legittimati ad amministrare e dirigere la categoria è rappresentata dal distacco e dall’indifferenza mostrati da gran parte degli iscritti. Sono infatti ancora molti - troppi! - i colleghi ai quali risulta estranea la vita dell'Ordine professionale al quale appartengono e che, pertanto, ignorano buona parte dei risultati positivi raggiunti. Una condizione di sciatteria e di trascuratezza, uno stato di cose che crea diffidenza tra coloro che sono amministrati e scoramento tra gli amministratori limitandone, giocoforza,

Sono ancora molti - troppi! - i colleghi ai quali risulta estranea la vita dell'Ordine professionale al quale appartengono

La disaffezione verso il proprio Ordine deforma la percezione del medesimo, che spesso viene ritenuto inoperoso e ininfluente

anche l’interlocuzione. Se quanto si ottiene in termini di riconoscimento delle competenze e delle tutele professionali, di rivalutazione della figura del biologo nei molteplici e vasti ambiti scientifici nei quali questo opera, non è conosciuto e quindi non apprezzato, il lavoro svolto perde di efficacia e l'intera categoria si attarda nella lamentazione e nella commiserazione per una condizione che si pensa essere rimasta immutata. Qualunque siano i benefici, le opportunità

e le tutele che ne derivano, essi saranno utilizzati solo da una parte degli iscritti. La disaffezione verso il proprio Ordine deforma la percezione del medesimo, che spesso viene ritenuto inoperoso e ininfluente, ridotto al rango di una tassa da pagare senza alcun corrispettivo. L’uso dei social, già di per sé alienante e isolante dal contesto reale, crea sacche autoreferenziali di soggetti che si avvitano su sé stessi e che addebitano con grande faciloneria i propri problemi esistenziali e professionali a una presunta inerzia dell’Ordine: un perpetuo commiserarsi onde evitare l’analisi delle criticità e delle difficoltà incontrate. Una specie di comoda, quanto

mendace, autoassoluzione dei propri ritardi culturali e cognitivi. Tuttavia, non possiamo e non dobbiamo lasciarci condizionare da uno stato di cose che per diversi colleghi tarda a trovare una sua felice soluzione. I biologi non possono attendere che tutti comprendano l’importanza del ruolo svolto dagli Ordini territoriali e dalla Federazione degli stessi. Bisogna “cantare” e, al contempo, portare la croce, per la semplice ragione che il futuro non si aspetta, ma si prepara. Se è vero che la biologia è la scienza che gode di maggiore credito per il futuro prossimo, la scienza che apre nuove strade di conoscenza e di inserimento professionale nel terzo

millennio, e che meglio di qualunque altra disciplina sfrutta il supporto della tecnologia e dell’intelligenza artificiale, allora si deve andare avanti. La prossima apertura della Scuola di Bioinformatica; gli eventi già definiti sulle nuove frontiere della biologia nello spazio, a Napoli, nella prestigiosa Reggia dei Borbone; lo studio della vita che si sviluppa in microgravità in modi diversi, imprevisti e sorprendenti, accompagnato da un dottorato in Scienze Biospaziali; la Bisogna “cantare” e, al contempo, portare la croce, per la semplice ragione che il futuro non si aspetta, ma si prepara

La Federazione esplora nuovi campi di pratica professionale perché intende istruire attraverso la pratica, oltre che la teoria, i giovani biologi

Scuola di Biorestauro dei monumenti e delle opere d’arte: sono solo alcuni dei prossimi appuntamenti di assoluta novità e di grande interesse professionale attualmente in cantiere. La Federazione esplora nuovi campi di pratica professionale perché intende istruire attraverso la pratica, oltre che la teoria, i giovani biologi, instradandoli su nuovi percorsi di conoscenza e di lavoro. Così sarà per la nanotossicologia, l’ecotossicologia e l’igiene pubblica ambientale, alle

cui specializzazioni potranno accedere anche i biologi. Con esse inizieranno i corsi di pratica professionale nei campi dell’embriologia clinica e del biorestauro, con altre due scuole permanenti sul campo. Noi non dobbiamo fermarci a ciò che di significativo si è ottenuto in questi anni e, apprezzato e conosciuto, dobbiamo ulteriormente innovare le pratiche professionali dei biologi. Insomma, nessuno può cullarsi sugli allori né contemplare quanto è stato fatto, ancorché atteso e realizzato dopo mezzo secolo dalla legge istitutiva dei Biologi. Non sarebbe giusto darla vinta alla parte meno attenta e partecipe della Categoria. Bisogna guardare a coloro

che ci seguono con assidua lealtà e non più a quelli che intendono vivacchiare sull’esistente. Alcune polemiche sorte sulla presunta mancanza di autonomia che FNOB riconosce agli Ordini Territoriali, sono farlocche e strumentali. Agli Ordini territoriali spetta tutta l’autonomia che loro compete per le materie che la legge ha trasferito agli stessi, così come irrinunciabili sono le competenze di coordinamento e di indirizzo che spettano alla Federazione. Il campanilismo è il rifugio di chi coltiva disegni ed ambizioni personali, segno della incapacità di fare cose egregie che vadano oltre la routine dei corsi ECM e dei corsi prelievi, di una politica ter -

ritoriale e clientelare di cui ci si debba servire per mantenere cristallizzato l’esistente. FNOB ha operato in favore degli Ordini Territoriali e mai in contrasto e così dovrà essere in futuro. Sono di questo segni sia i risultati del passato sia i propositi per il futuro, per favorire chi è capace di sentirsi interprete del buono che avanza, e non dei difetti e dell’incuria che appartengono al passato. Ho sentimento che il bene e il vero vinceranno e lavoreremo perché questo avvenga.

La Federazione ha operato in favore degli Ordini Territoriali e mai in contrasto e così dovrà essere in futuro

BIOLOGIA, LA SCIENZA CHE ALLUNGA LA VITA E LA RENDE MIGLIORE

Grazie alla genomica e all'epigenetica

è possibile prevenire malattie e agire subito

L'importanza del riconoscimento della figura del biologo tra le professioni sanitarie

di Rino Dazzo

UN ANNO RICCO DI OCCASIONI

DA COGLIERE AL VOLO, PROSEGUENDO

NEL PERCORSO CHE DA DIVERSI ANNI

LA FNOB HA INTRAPRESO E CHE STA

PORTANDO A RISULTATI ECCEZIONALI

Non solo o non più semplicemente la «scienza della vita». La biologia si sta rivelando sempre di più la disciplina che la vita l'allunga, la rende migliore, ancor più godibile rispetto al passato. La «scienza che ci fa vivere bene», insomma, grazie soprattutto ai progressi impressionanti di branche come la genomica o l'epigenetica e alla loro capacità di dialogare con efficacia con la medicina, in particolare con quella predittiva e di precisione.

Saranno sempre di più i biologi a dire a noi e ai medici di cosa ci ammaleremo, come curarci, ma anche quali accorgimenti mettere in campo per metterci al riparo da brutte sorprese, oppure come intervenire in modi rapidi, tempestivi e risolutivi. Lo ha spiegato, in un'interessante intervista pubblicata su PuntoEffe, il professor Giuseppe Novelli, ordinario di Genetica medica all'Università di Roma Tor Vergata, già rettore dello stesso ateneo nonché direttore della Scuola di specializzazione in Genetica medica e dell'Uoc di Genetica medica al Policlinico di Tor Vergata.

«La genetica sta smantellando il paradigma one-size-fits-all, quello di 'una sola taglia per tutti', quindi, ugualmente valida per tutti», è un passaggio dell'intervista al genetista. «Storicamente, le terapie si basavano su medie di popolazione e questo con un'efficacia variabile. Oggi, comprendiamo che malattie con sintomi simili - per esempio certi tumori o malattie cardiovascolari - possono avere basi genetiche radicalmente diverse. I progressi ci permettono di classificare le malattie in base al loro motore molecolare, come le mutazioni in geni specifici anziché solo all'organo colpito. E di identificare

LA BIOLOGIA SEMPRE PIÙ AL SERVIZIO DI UNA SOCIETÀ

CHE, GRAZIE ALLA FNOB, NE RICONOSCE LA SUA IMPORTANZA E LA SUA SPECIFICITÀ

sottogruppi di pazienti che, grazie al loro profilo genetico, risponderanno a un farmaco mirato oppure corrono il rischio di gravi effetti avversi. Nonché di spostare l'attenzione dalla cura in fase avanzata alla prevenzione predittiva per individui ad alto rischio genetico. In sostanza, stiamo passando da un modello reattivo a uno proattivo e predittivo che parte dal profilo genetico, passa per la prevenzione, e arriva a una terapia mirata».

Un'attenzione che, grazie ai biologi, dalla malattia si sposta sempre di più verso la persona, guardando alle sue specificità, alle sue caratteristiche peculiari, ma anche alle sue risposte alle cure.

Non solo terapie mirate, non solo trattamenti il più possibile personalizzati, che pure sono cruciali: è la prevenzione, la possibilità di effettuare test accurati e specifici, di tenere sotto controllo l'insorgenza di malattie e disturbi individuandoli in anticipo, di contrastarne l'insorgenza ai primi segnali che già oggi fa la differenza, ma che in un futuro pros -

simo sarà ancora più impattante. Il 2026, dunque, si annuncia come l'anno della definitiva svolta per i biologi. Un anno ricco di occasioni da cogliere al volo, proseguendo nel percorso che da diversi anni la FNOB ha intrapreso e che sta portando a risultati eccezionali. Primo fra tutti, il riconoscimento a pieno titolo della figura del biologo tra le professioni sanitarie.

Già la legge 3/2018 e i successivi decreti avevano definito l'inquadramento giuridico della professione del biologo, ampliandone le competenze in ambito sanitario e riconoscendone a tutti gli effetti l'utilizzo nel Servizio Sanitario Nazionale per ruoli di ricerca, diagnostica e direzione presso strutture ospedaliere e di sanità pubblica, grazie anche alle lauree abilitanti e alle scuole di specializzazione. Lo scorso novembre, come reso noto dal ministro della Salute Orazio Schillaci, il decreto sul riordino delle professioni sanitarie è stato bollinato dal MEF e un comma dello stesso decreto prevede l'ingresso dei biologi

nelle scuole di specializzazione in igiene pubblica a indirizzo ambientale. La categoria, dunque, è entrata ufficialmente nel SSN, con la possibilità di approdare alla direzione dei presidi sanitari. Ma molto importanti sono anche i nuovi decreti in arrivo per i biologi, resi possibili dalla compiuta attuazione della legge 163/2021 sulle lauree abilitanti.

Tra questi, spicca il riconoscimento della denominazione di «biologo nutrizionista» e delle sue competenze professionali nel campo della nutrizione generale e specifica in settori come quello sportivo, bariatrico, pediatrico e oncologico, col potenziale ingresso negli organici del SSN (quindi nelle strutture pubbliche), ma anche con la possibilità di utilizzare apparecchiature biomedicali e di effettuare alcune tipologie di rilevazione di parametri analitici di base col metodo POCT, lo stesso utilizzato in farmacia.

Non va dimenticata la recente firma del protocollo d'intesa tra la FNOB e la Figc, Federazione Italiana Giuoco Calcio, che prevede l'organizzazione di corsi di aggiornamento e formazione dedicati a medici e biologi nutrizionisti per garantire a calciatrici e calciatori una corretta alimentazione e migliorare le loro prestazioni sportive.

La biologia, quindi, sempre più al servizio di una società che, grazie alla FNOB, ne riconosce la sua importanza e la sua specificità.

© PeopleImages/shutterstock.com

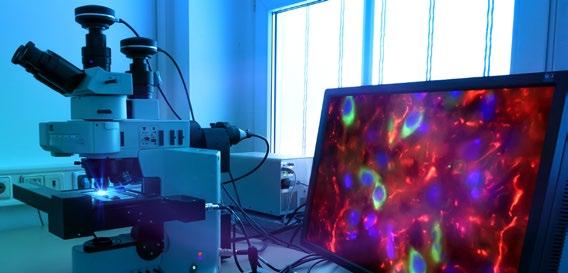

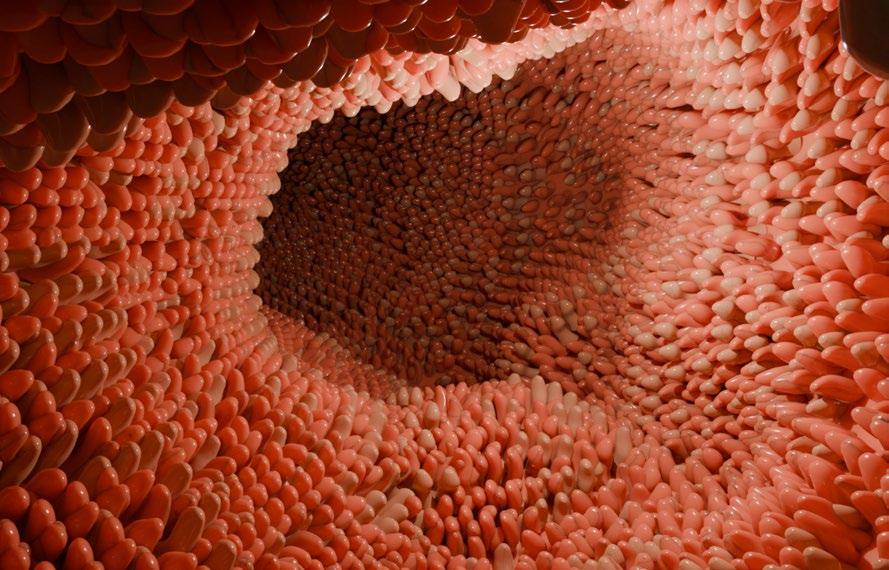

GENOMICA ED EPIGENETICA

NEL SSN: I BENEFICI

Quanto migliorerebbe la sanità italiana con l'introduzione massiva dei servizi innovativi legati alla genomica, all'epige netica e alla medicina predittiva e di precisione? I costi legati alla loro introduzione sarebbero compensati dai benefici derivanti dall'auspicabile riduzione delle spese per degenze e terapie a carico del Servizio Sanitario Nazionale?

La questione non è di poco conto e non è neanche tanto recente. Già nel 2017, infatti, attraverso un accordo Stato-Regioni, l'Italia ha avviato il suo Piano Nazionale per la Genomica, finalizzato al miglioramento dei sistemi di prevenzione, diagnosi e di cura personalizzati, a una maggiore effica -

cia delle terapie in ambito oncologico e delle malattie rare, oltre che alla riduzione dei tempi di diagnosi.

Tre anni dopo, nel 2020, il Consiglio Superiore di Sanità ha redatto il documento denominato «Trasferimento delle tecniche omiche nella pratica clinica», contenente una serie di soluzioni per migliorare il SSN quali l'inserimento nei Lea del sequenziamento dell'esoma come indagine di prima scelta nei pazienti senza diagnosi, lo sviluppo di una rete nazionale di centri clinici dotati di personale medico formato sulla gestione delle analisi genomiche, l'esecuzione delle stesse analisi genomiche presso strutture specializzate e certificate,

L'Italia e l'Europa hanno aperto sempre di più all'utilizzo delle tecnologie «omiche» nelle strutture pubbliche

la creazione di sinergie tra laboratori e centri di ricerca e la promozione di un Piano Nazionale per la Medicina di Precisione.

Le malattie rare, l'oncologia e le malattie complesse sono i tre gruppi di patologie per i quali sono previsti i maggiori benefici. Ma tutto il sistema sanitario, con la compiuta realizzazione del piano, sarebbe definitivamente stravolto, passando da una medicina delle quattro P - preventiva, predittiva, precisa e personalizzata - a quella delle cinque P, dove la quinta sta per «partecipativa», visto che il paziente sarebbe sempre più in grado di svolgere un ruolo proattivo.

Ma quali sono queste tecnologie «omiche», sempre più destinate a entrare tra gli strumenti offerti dalla sanità pubblica a supporto dei cittadini? Il sequenziamento della porzione codificante del genoma e dell'intero genoma, il sequenziamento dell'RNA codificante e non codificante di cellule e tessuti, lo studio e la caratterizzazione delle modifiche epigenetiche del genoma sono i test e le indagini ad alta risoluzione in grado di fornire una notevole quantità di dati preziosissimi, utili a mappare con precisione assoluta le caratteristiche di ogni paziente, la possibilità di sviluppare malattie o di andare incontro a determinate patologie, ma anche di prevenirle.

Anche l'Unione Europea, in particolare negli ultimi anni, si è resa conto dell'importanza di implementare la genomica sanitaria e di favorire la collaborazione tra stati membri, prima attraverso la dichiarazione «Towards access to at least 1 million sequenced genomes in the EU by 2022 (1+MG)», sottoscritta nel 2018 da 13 paesi tra cui l'Italia, poi col finanziamento del progetto «Beyond 1 Million Genomes (B1MG)». La strada, insomma, è tracciata. (R. D.).

Le analisi predittive e di precisione sono essenziali per mettere a punto opere di prevenzione e terapie mirate

Uno strumento utilissimo per accertare quanto sia alto il rischio di svilup pare malattie ereditarie, per focalizzare l'attenzione su pato logie di natura familiare, ma anche per impostare adeguate contromisu re preventive o per iniziare da subito eventuali cure.

La medicina predittiva e di preci sione sta diventando cruciale per il paziente e per gli stessi medici. Ma quali sono le operazioni da compiere per completare un check-up genetico? E quanto costano?

Il primo passo è la consulenza che precede il test vero e proprio, durante la quale il genetista raccoglie la storia clinica del paziente e dei suoi familia ri, focalizzando l'attenzione su speci fici rischi: un passaggio fondamentale per orientarsi e decidere insieme quali e quante analisi effettuare.

Il secondo passaggio è rappresen tato dal prelievo di campione biologi co (che può essere sangue o saliva) da cui sarà estratto il DNA. Quindi il test genetico vero e proprio, che può essere di varia natura.

Il pannello genetico, ad esempio, è utile per configurare il rischio specifico per un gruppo di condizioni monogeniche come predisposizioni a tumori o cardiomiopatie, o per coppie in previsione di una gravidanza, come nel caso dell'Extended Carrier Test, in cui si analizzano soprattutto geni associati a condizioni recessive per cui i genitori potrebbero essere portatori.

C'è poi il Polygenic Risk Score, punteggio che, analizzando diversi geni, assegna un livello di rischio per diverse patologie multifattoriali come le cardiovascolari.

Il WES (Whole Exome Sequencing) consiste invece nel sequenziamento delle regioni codificanti di tutti i geni conosciuti al momento del test (il 2%

TEST GENETICI: QUALI SONO E QUANTO COSTANO

del patrimonio genetico di ogni singolo individuo) e consente l'individuazione di eventuali varianti o mutazioni in geni associati a un gran numero di patologie; spesso è effettuato insieme a test di farmacogenetica, per un livello di analisi più completo e accurato.

Infine il WGS (Whole Genome Sequencing), cioè il sequenziamento di tutto il genoma, quindi anche delle le parti che non codificano proteine, che copre il restante 98% del patrimonio genetico personale e che permette di rilevare eventuali varianti «introniche profonde», che si verificano nelle regioni interne dei geni e che possono influenzare la produzione di proteine errate o non funzionanti alla base di

varie malattie. Al termine delle analisi la consulenza post test è essenziale per valutare e spiegare i risultati ottenuti e le loro eventuali precauzioni, in modo da indirizzare il paziente verso altre analisi specialistiche mirate, che possono essere preventive o terapeutiche. I costi? Non certamente contenuti. Se le consulenze pre e post test costano generalmente un centinaio di euro, gli specifici test genetici hanno un peso diverso. Il pannello genetico costa tra 300 e 500 euro, la valutazione del rischio poligenico intorno alle 500, il WES 7-800 euro, il WGS intorno ai 1000 euro. E l'attesa per i risultati può variare dai 40 giorni lavorativi del pannello ai 60 per il rischio poligenico. (R. D.).

BLUE MONDAY LA DEPRESSIONE COLPISCE SEMPRE PIÙ GIOVANI

Gennaio t’odio e t’amo: tra pressione di performance, confronto social e ritiro, il disagio non è “solo tristezza” e non dura un giorno

© SB Arts Media/shutterstock.com

OGNI ANNO IN EUROPA SI CONTANO

OLTRE 150MILA SUICIDI, E TRA

I 15 E I 29 ANNI IL SUICIDIO È

LA PRIMA CAUSA DI MORTE. IN ITALIA, NEL 2022, CE NE SONO STATI 3.934: IL VALORE PIÙ ALTO DAL 2015

Gennaio, puntuale, riporta in scena il Blue Monday: il terzo lunedì del mese definito “il più triste” per un mix di freddo, giornate corte, fine delle feste, conti da sistemare e buoni propositi già in crisi.

Passata l’euforia natalizia, per molti ragazzi la routine torna a pesare: poca energia, irritabilità, calo di entusiasmo, fatica a concentrarsi. È chiaro: non si può comprimere una sofferenza in un solo giorno.

Il Blue Monday è una “convenzione” nata da una fortunata campagna del 2005 eppure, come tutte le cose semplici, ha un grande potere: quello di rassicurare e di rendere il disagio più comprensibile, quasi condiviso.

Ma al di là del mito, l’inverno può davvero amplificare un umore già fragile: meno luce significa ritmi sfasati, più melatonina (sonnolenza) e meno serotonina (tono dell’umore). E il quadro generale non conforta: l’OMS prevede che la depressione diventi tra i principali pesi sanitari entro il 2030, con un impatto enorme anche economico.

Il nodo, però, sono i giovani. Secondo l’OCSE, oltre 700mila ragazzi in Italia convivono con problemi di salute mentale; ansia e depressione sono tra i più frequenti. E un dato pesa più degli altri: molti disturbi esordiscono presto, entro i 24 anni, su un terreno fatto di fattori biologici, esperienze traumatiche, nuove sostanze e stigma.

La pandemia ha aggravato ansia, depressione e solitudine (+25%), mentre la carenza di professionisti della salute mentale rende più difficile “agganciare” il disagio quando è ancora reversibile, soprattutto tra adolescenti e anziani. In Europa una persona su sei convive

con un problema di salute mentale, ma una su tre non riceve cure adeguate.

Ogni anno nella Regione europea OMS si contano oltre 150mila suicidi, e tra i 15 e i 29 anni il suicidio è la prima causa di morte. In Italia, nel 2022, i suicidi sono stati 3.934: il valore più alto dal 2015.

Ma come si scivola dentro la depressione?

Alex Korb, in “The Upward Spiral”, parla di una spirale verso il basso: niente interessa davvero, ci si isola, ogni scelta sembra sbagliata. E non è “solo tristezza”: può essere anestesia emotiva, insonnia, dolori più intensi, concentrazione che si sfalda, ansia e senso di vuoto.

Sul piano neurobiologico entrano in gioco soprattutto due poli: corteccia prefrontale (regolazione, decisioni, controllo degli impulsi) e sistema limbico (emozioni).

Quando la comunicazione tra questi sistemi si inceppa, lo stress cronico può alzare cortisolo e adrenalina e i segnali di allarme diventano costanti; inoltre, alterazioni in più neurotrasmettitori contribuiscono al mosaico dei sintomi.

Torniamo ai giovani: perché proprio loro? Berry Schwartz, nel “Paradox of Choice”, descrive la trappola delle infinite possibilità: più opzioni significa più confronto, più paura di sbagliare, più rimpianto per ciò che si è escluso.

La libertà totale sembra un privilegio, ma può diventare una pressione: se “sei il risultato delle tue scelte”, allora ogni passo pesa come un verdetto. Quando la vita reale non assomiglia a quella desiderata, delusione e colpa prendono il comando, con la sensazione di “guardare dalla finestra” la propria esistenza.

In alcuni casi lo smarrimento diventa ritiro radicale: nel fenomeno degli hikikomori l’isolamento in casa si prolunga per mesi o anni, con scuola e relazioni che si spengono. E spesso, per reagire al caos, arriva una risposta che promette controllo.

Ma è possibile un cambio di rotta? Per andare a fondo nella questione, abbiamo consultato una psicologa specializzata in terapia breve strategica.

“

Dottoressa, facciamo chiarezza. Quali sono le differenze chiave tra depressione e ansia sociale? E quali sono invece le aree in cui possono sovrapporsi o alimentarsi a vicenda?

Depressione e ansia sociale sono diverse, ma spesso si incastrano. La depressione è un abbassamento “a tutto campo”: umore deflesso, vuoto, poca energia, perdita di interesse, autostima che crolla (nei casi gravi anche pensieri di morte). Il ritiro sociale qui è spesso una conseguenza. L’ansia sociale, invece, è mirata: la paura intensa del giudizio, di esporsi e “fare errori visibili”. Se resto nella mia stanza posso stare meglio; fuori, sale l’ansia e l’evitamento diventa la strategia. E possono alimentarsi: l’ansia e il fallimento spingono verso il depresso, e la depressione aumenta insicurezza e paura sociale, soprattutto nei giovani.

Quali fattori stanno contribuendo, secondo lei, all’aumento del disagio depressivo e dell’ansia sociale nei più giovani?

L’aumento del disagio nei giovani è multifattoriale: non c’è un solo fattore, c’è un sistema che spinge. La pressione prestazionale arriva presto e su più fronti - scuola, sport, immagine - con un messaggio implicito: devi eccellere, devi “stare al passo”. A questo si sommano instabilità e incertezza sul futuro, insieme a una quantità di scelte che può remindere più difficile decidere: più opzioni, più paura di sbagliare, più paralisi.

In clinica emerge spesso anche una fragilità nelle competenze emotive e di problem solving: quando la gestione delle difficoltà è stata a lungo “anticipata” dall’ambiente, tollerare frustrazione, fallimento e attesa diventa più arduo. Infine, ritmi iperproduttivi e vita digitale - accelerati nel post-Covid - hanno ridotto tempi di relazione e di elaborazione: molte interazioni si spostano online, dove ci si espone meno e si evita più facilmente. In questo contesto, il disagio non solo aumenta: tende a cronicizzarsi se non viene intercettato.

Social, perfezionismo, paura di fallire: quali sono i meccani smi psicologici più comuni che vede in studio?

In studio vedo spesso gli stessi ingranaggi: confronto sociale continuo che produce svalutazione, perfezionismo disfunzionale (valgo solo se performo) e paura dell’erro -

INTERVISTA ALLA PSICOLOGA FEDERICA RECUPITO

SPECIALIZZATA IN TERAPIA BREVE STRATEGICA

re/giudizio. Da lì nasce la “soluzione” che peggiora tutto: evitare, rimandare, bloccarsi, chiedere conferme continue. Così però non si costruiscono né autostima né capacità di reggere l’ostacolo.

Il quadro che arriva è un’identità fragile: facce smarrite, zero desiderio, e la frase che sento più spesso è “non so cosa provo, non so cosa sento”. Per questo dico che spesso lavoro su un terreno arido: prima va reso fertile, poi si può seminare. E in questa fase non serve aggiungere stimoli e opzioni: spesso serve togliere rumore, ridurre il confronto e rimettere il ragazzo in contatto con scelte piccole, reali, sostenibili.

Quali sono i segnali che indicano: qui basta un lavoro psi cologico, qui serve una valutazione psichiatrica, qui meglio un trattamento integrato?

Non decide l’etichetta, ma tre fattori: gravità, durata e quanto il disagio compromette la vita quotidiana. Un lavoro psicologico può bastare quando i sintomi sono circoscritti o legati a stress e la persona mantiene un funzionamento discreto, senza segnali di rischio. Serve una valutazione psichiatrica se compaiono intensità e pervasività elevate, marcata compromissione, ideazione suicidaria/autolesiva o sospetti sintomi psicotici/maniacali.

Nei quadri moderati-gravi, il trattamento integrato è spesso la scelta più efficace: il supporto farmacologico riduce il carico sintomatologico e facilita la psicoterapia, che lavora sui meccanismi di mantenimento e sulla prevenzione delle ricadute

Secondo lei il SSN oggi riesce a offrire un supporto comple to per depressione e ansia sociale? Qual è il percorso più immediato per chiedere aiuto?

Il SSN c’è, ma oggi il problema è l’accesso reale: tempi, disomogeneità territoriale e risorse non sufficienti fanno sì che, quando una persona sta male, spesso non può permettersi di aspettare. Per questo, nella pratica, la via privata resta la strada più immediata.

Il Piano 2025–2030 può portare un cambiamento importante, ma non basta scriverlo: deve tradursi in équipe, continuità e presa in carico concreta sul territorio, altrimenti resta una promessa sulla carta. (E. B.).

CRANS MONTANA, OLTRE IL FUOCO: LA SCIENZA DELLA RIGENERAZIONE

SFIDA LE USTIONI PIÙ GRAVI

Il professor Lucio Tirone illustra il complesso percorso clinico che attende i pazienti. Dalle nuove frontiere della bio-ingegneria, con l’uso di cellule staminali e la coltivazione di pelle in laboratorio, fino alla microchirurgia estrema del trapianto di faccia: ecco come le sfide più difficili si trasformano in speranze di guarigione

“

La strage di Capodanno a Crans-Montana, il rogo che ha devastato il locale “Le Constellation” causando 40 morti e 116 feriti, ha riportato prepotentemente alla ribalta il tema della medicina rigenerativa. Il dibattito scientifico si concentra oggi sulla ricerca legata alle cellule staminali e alla rigenerazione dei tessuti, spinto dall'urgenza della cronaca: i media hanno acceso i riflettori sulla situazione drammatica dei sopravvissuti - per la maggior parte giovani e giovanissimi - ritrovatisi con il corpo martoriato da ustioni che, in molti casi, superano il 60% della superficie cutanea.

Si tratta di una lotta serrata contro il tempo e contro le infezioni, pericoli costanti in presenza di tessuto necrotico. La tragedia di Crans-Montana ha inevitabilmente aperto una finestra fondamentale sulla ricerca medica, toccando temi cruciali come la stabilizzazione del paziente, la gestione delle infiammazioni e la complessa organizzazione ospedaliera. In questo scenario, la rigenerazione cellulare della cute assume un rilievo vitale. In queste settimane si è discusso a lungo dell’importanza delle banche della cute e di strutture d’eccellenza per i grandi ustionati: argomenti a tratti pionieristici che abbracciano più discipline, a partire dalla chirurgia plastica e ricostruttiva.

Ne parliamo con uno dei massimi esperti del settore, il Professor Lucio Tirone, chirurgo plastico di fama internazionale con una solida esperienza maturata presso la Harvard Medical School e il Massachusetts General Hospital di Boston centro di eccellenza globale per la chirurgia plastica e ricostruttiva.

Quando un’ustione è definita grave?

«La pelle svolge funzioni protettive fondamentali. Quando viene distrutta dall'ustione, queste funzioni vengono a mancare e, a seconda dell’entità del danno, la situazione è più o meno critica. L’equilibrio idrico dell’organismo si altera completamente, con gravi ripercussioni sistemiche su reni, polmoni e cuore. L’insieme di queste alterazioni, che non sono limitate alle sole aree colpite, viene definita malattia da ustione».

Anche le ustioni superficiali possono essere pericolose?

«La cute ha due componenti: uno strato superficiale chiamato epitelio e uno più profondo chiamato derma. Le ustioni superficiali distruggono l’epitelio, che è sottilissimo e si ricambia continuamente; guariscono in pochi giorni senza cicatrici. Le ustioni profonde distruggono invece il derma, causando danni permanenti e l'abolizione delle funzioni cutanee in quell'area. Se parliamo di immediato pericolo di vita, la gravità è legata soprattutto all'estensione: nei soggetti fragili, come i bambini, anche ustioni superficiali ma molto estese possono risultare letali».

Perché un’ustione sul 60% del corpo è definita "molto grave"?

«Indipendentemente dalla profondità, un’ustione che superi il 60% della superficie corporea è considerata pericolosa perché causa uno shock nell'equilibrio dei liquidi interni. Questo provoca ripercussioni su reni, polmoni e cuore che pazienti delicati, come anziani o bambini, non riescono a compensare senza adeguate terapie intensive».

Qual è la procedura di pronto soccorso e perché l’idratazio ne è vitale? Unguenti e pomate sono utili?

«Nell’immediato, le piccole ustioni superficiali vanno pulite e protette con garze sterili; pomate anestetiche o antibiotiche possono alleviare il dolore e prevenire infezioni. Nelle grandi ustioni, invece, la distruzione della pelle causa una massiva perdita di liquidi che trasudano dai vasi sanguigni. Questo squilibrio è pericolosissimo per gli organi vitali. La terapia immediata deve quindi consistere nell'infusione di liquidi e sostanze specifiche per compensare le perdite e mantenere il sistema in equilibrio».

Professor Tirone, si dice spesso che le ustioni più profonde siano le meno dolorose. È un paradosso o una realtà clinica?

«È una tragica realtà. Mentre le ustioni superficiali sono estremamente dolorose perché irritano le terminazioni nervose rimaste intatte, nelle ustioni profonde (di terzo grado) il calore distrugge completamente i recettori del dolore e le fibre nervose situate nel derma. Paradossalmente, il paziente può non avvertire dolore nelle aree più colpite proprio perché i "sensori" che dovrebbero trasmettere lo stimolo al cervello sono stati annientati.

Perché la pelle è indispensabile alla vita?

Per comprendere perché un’ustione rappresenti un evento critico per la salute, è necessario sapere che la pelle non è un semplice rivestimento, ma un organo vitale che svolge funzioni insostituibili:

• Barriera Biologica: Impedisce a microbi e sostanze pericolose di penetrare nell'organismo.

• Termoregolazione: Regola la temperatura corporea tramite le ghiandole sudoripare e la circolazione superficiale.

• Protezione e Idratazione: Le ghiandole sebacee producono il sebo, che evita che la pelle si secchi a contatto con l’ambiente esterno.

• Centrale Informativa: Tramite decine di milioni di fibre nervose, invia al cervello dati precisi su temperatura, pressione e contatto.

• Il Paradosso del Dolore: Nelle ustioni superficiali il dolore è fortissimo. Nelle ustioni profonde, invece, il dolore scompare perché il calore ha distrutto le fibre nervose: l'assenza di sensibilità è dunque un segnale di estrema gravità tissutale.

Questo è un segno clinico di estrema gravità: l'assenza di dolore, in questi casi, è l'indicatore di una distruzione tissutale totale».

Perché il rischio di infezioni è così elevato?

«Le aree ustionate, non essendo più vitali, diventano un terreno di coltura per i batteri presenti sulla pelle o nell’ambiente. Alcuni microbi, particolarmente resistenti agli antibiotici, proliferano sui tessuti necrotici e possono passare nel sangue, causando un’infezione generalizzata (sepsi) che interessa l’intero organismo. È la complicazione più temuta».

Perché sono necessarie strutture specializza te come i Centri Ustioni?

«Quando l’ustione è estesa, il paziente richiede trattamenti basati su criteri precisi che variano a seconda dell'età e dello stato generale. Nei centri specializzati lavorano medici che hanno grande dimestichezza con la fase acuta e possiedono le competenze multidisciplinari necessarie per tutto il percorso di cura».

Come viene trattata la pelle dopo la fase di emergenza?

«Superata la fase critica, la priorità è chiudere le ferite, che restano una porta aperta per le infezioni. Bisogna eliminare la cute non più vitale. Se le ustioni non sono estesissime, si interviene con un unico intervento: si asportano le parti morte e si copre l'area con uno strato sottilissimo di pelle prelevato da zone sane del paziente.

Questi innesti attecchiscono stabilendo connessioni con i vasi sanguigni della ferita, mentre la zona del prelievo guarisce spontaneamente in pochi giorni».

Cosa si intende per "Banca della Cute"?

«Quando un paziente subisce ustioni così estese da non avere quasi più pelle sana, sorge la necessità vitale di chiudere le ferite per proteggere l'organismo. In questi casi ricorriamo alla Banca della Cute, una struttura che fornisce tessuto cutaneo prelevato da donatori.

Si tratta di una copertura temporanea: poiché la pelle non appartiene al ricevente, dopo un certo periodo viene rigettata e distrutta dal sistema immunitario.

Tuttavia, nel lasso di tempo in cui rimane in sede, svolge una funzione cruciale nel mantenere l’equilibrio vitale del paziente e nel proteggerlo dalle infezioni».

Dalla sua esperienza a Boston, presso il Massachusetts General Hospital e la Harvard Medical School, cosa è cam biato nella Chirurgia Plastica Ricostruttiva? È possibile oggi rigenerare la pelle?

«Durante il mio periodo negli Stati Uniti, i laboratori di ricerca di Harvard stavano muovendo i primi passi nelle tecniche di coltivazione della pelle umana. All'epoca era pura sperimentazione; oggi è una realtà clinica consolidata.

Nei casi più gravi, dove la superficie corporea è quasi totalmente distrutta, possiamo prelevare minuscoli frammenti di pelle residua e farli crescere in laboratorio. Si ottengono così sottili "fogli" di epitelio pronti per essere innestati.

Il grande vantaggio è che questo tessuto, essendo autologo (ovvero del paziente stesso), attecchisce definitivamente senza alcun rischio di rigetto. Tuttavia, è una procedura che richiede tempi lunghi di crescita, quindi il suo utilizzo va pianificato con estrema attenzione in base all'urgenza del quadro clinico».

Come si conciliano funzionalità ed estetica in un intervento di ricostruzione post-ustione?

«È bene chiarire che le procedure di emergenza servono a salvare la vita e ripristinare la funzionalità, non a ricostruire la pelle nella sua forma originale.

Gli innesti di cui abbiamo parlato sono privi del derma profondo, che conferisce elasticità, spessore e colore naturale. Di conseguenza, la pelle ricostruita può apparire diversa e tendere a retrarsi, causando limitazioni nei movimenti.

Per ovviare a questo problema, specialmente in zone critiche come il volto, le palpebre o le articolazioni, utilizziamo la tecnica dell'espansione cutanea.

Se vicino all'ustione c'è pelle sana, inseriamo sotto di essa dei dispositivi chiamati "espansori" che, gonfiati gradualmente, dilatano la cute normale fino a renderla sufficiente per coprire l'area lesa.

In questo modo, trasportiamo sulla ferita un tessuto identico per caratteristiche e colore a quello originale».

Si utilizzano tecniche di microchirurgia nel trattamento dei grandi ustionati?

«Certamente, sono fondamentali quando l'ustione è così profonda da esporre tendini, ossa o articolazioni. In questi casi un semplice innesto non sopravvivrebbe per mancanza di nutrimento. Dobbiamo quindi ricorrere ai lembi microchirurgici: preleviamo porzioni di tessuto da aree distanti del corpo insieme ai loro vasi sanguigni (arterie e vene).

Con l'ausilio del microscopio, colleghiamo questi vasi a quelli della zona ricevente, ripristinando immediatamente il flusso sanguigno. Questo garantisce la sopravvivenza del tessuto trasferito anche su superfici "difficili"».

Qual è la parte del corpo più complessa da trattare?

«Sebbene le tecniche siano ormai standardizzate in tutti i Centri Ustioni, il volto resta la sfida più ardua. È il nostro tratto distintivo e anche la minima deformazione incide pesantemente sulla percezione di sé e sulla vita sociale.

Sebbene oggi siamo in grado di ottenere ottimi risultati funzionali (permettere di chiudere gli occhi o muovere la bocca), il ripristino estetico totale è un traguardo per il quale la strada è ancora lunga».

Lo Xacduro (sulbactam-durlobactam) rappresenta l'ultima frontiera farmacologica nella lotta contro l'Acinetobacter baumannii, uno dei batteri più resistenti e letali identificati dall'OMS. La sua introduzione nel protocollo di cura per i pazienti di Crans-Montana è stata determinante: negli Stati Uniti, la Food and Drug Administration (FDA) ne ha già autorizzato l'uso per trattare polmoniti batteriche acquisite in ospedale (HABP) e associate a ventilazione (VABP).

Il farmaco combina il sulbactam (un antibiotico simile alla penicillina) con il durlobactam (un inibitore delle beta-lattamasi), che impedisce ai batteri di distruggere l'antibiotico stesso. Non essendo ancora approvato ufficialmente dall'AIFA, il farmaco è stato reperito tramite una collaborazione d'urgenza tra il Niguarda di Milano e l'Ospedale San Martino di Genova, sfruttando le scorte dedicate a protocolli speciali.

A differenza degli antibiotici a largo spettro, lo Xacduro è stato "progettato" specificamente per superare le difese dei ceppi multi-resistenti di Acinetobacter, offrendo una speranza concreta laddove le terapie tradizionali falliscono.

Le cellule staminali possono rappresentare una svolta?

«Le staminali, presenti in abbondanza nel grasso sottocutaneo, hanno la capacità teorica di trasformarsi in qualsiasi tipo di tessuto. Sebbene la prospettiva di "costruire" un organo nuovo partendo da zero sia affascinante, siamo ancora in una fase iniziale. Attualmente, queste procedure non sono ancora entrate nell'armamentario chirurgico quotidiano, ma rappresentano il futuro della ricerca».

Quali sono le frontiere più avanzate per resti tuire un aspetto normale a un paziente ustio nato?

«I principi base sono gli stessi, ma le tecniche si sono affinate incredibilmente. La novità più eclatante degli ultimi dieci anni è il trapianto di faccia da donatore cadavere. È una procedura estrema, eseguita solo in pochi centri al mondo, che richiede l'unione microchirurgica di vasi e nervi per restituire non solo l'aspetto, ma anche la mimica facciale. È una strada complessa, poiché il paziente deve assumere farmaci immunosoppressori per tutta la vita, con pesanti effetti collaterali.

In conclusione, il desiderio di un paziente di tornare ad avere l'aspetto di prima non è più una chimera. La scienza procede a passi che, visti nel tempo, sono straordinari: nel 1982, quando mi specializzai, il trapianto di faccia era pura fantascienza. Oggi è realtà». (M. A.).

In seguito al tragico incendio di Capodanno a Crans-Montana, è nata un'importante iniziativa di solidarietà che coinvolge la donazione di capelli per realizzare parrucche destinate ai pazienti giovani e adulti rimasti ustionati.

Numerosi parrucchieri in Canton Vallese, in Ticino e persino in Italia offrono il taglio e la piega gratuiti a chi decide di donare i propri capelli per questa causa.

La ciocca deve essere lunga almeno 20-25 cm (l'ideale sono 30-35 cm per parrucche più lunghe). L'iniziativa mira a restituire un senso di normalità e fiducia alle vittime dell'incendio, i cui bulbi piliferi sono stati danneggiati dal calore estremo, rendendo difficile o impossibile la ricrescita naturale.

Chirurgo di fama internazionale, il Professor Lucio Tirone è specialista in Chirurgia Plastica, Ricostruttiva ed Estetica, oltre che in Chirurgia della Mano.

Dopo la laurea presso l’Università Federico II di Napoli, ha conseguito la specializzazione in Chirurgia Plastica a Parma e quella in Microchirurgia presso la prestigiosa Harvard Medical School di Boston e presso il Massachusetts General Hospital.

Già docente presso la Scuola di Specializzazione in Chirurgia Plastica del Policlinico Universitario di Napoli, ha diretto per anni l'Unità Operativa di Chirurgia Plastica dell'Ospedale Villa dei Fiori di Acerra. Autore di circa cento pubblicazioni scientifiche e coautore di uno dei testi di riferimento per le scuole di specializzazione in Chirurgia Plastica, è celebre per la sua maestria negli interventi ricostruttivi complessi - in particolare su palpebre e naso - che esegue attualmente tra Napoli e Avellino.

L’ARTE DI GUARIRE: COME TRATTARE LE CICATRICI TRA SCIENZA E COSMESI

Non sono semplici segni sulla pelle, ma il racconto di una guarigione. Eppure, la visibilità di una cicatrice può condizionare il nostro rapporto con lo specchio. Capire come nascono è il primo passo per imparare a minimizzarle.

Biologicamente, una cicatrice è il risultato di un delicato equilibrio interrotto. La sua visibilità dipende da una sorta di "tempesta perfetta": come si distribuisce il collagene, quanto è stata intensa l’infiammazione, quanto sangue irrora la zona e quanta melanina vi si deposita.

Se questo equilibrio non è armonioso, il segno rimane evidente. Fortunatamente, la dermocosmetica moderna ci offre alleati preziosi per intervenire sui fattori chiave e migliorare drasticamente l'estetica della pelle.

1. Questione di spessore: la sfida del collagene

Per appiattire e uniformare una cicatrice, il segreto risiede nella modulazione del collagene. I gel e i fogli di silicone sono oggi i trattamenti più apprezzati dalla comunità scientifica, specialmente per cicatrici recenti o cheloidi. Creando una barriera che riduce la perdita d'acqua, "calmano" i fibroblasti ed evitano che producano collagene in eccesso: il risultato è una pelle più morbida e sottile. Per chi combatte con i segni dell'acne, invece, i retinoidi (come la tretinoina) sono i veri protagonisti, capaci di stimolare il turnover cellulare e riorganizzare la trama cutanea.

2. Spegnere il rosso: addio all'infiammazione

Una cicatrice arrossata è una cicatrice ancora "attiva". In ambito clinico, i corticosteroidi rappresentano l'intervento d'urto per inibire l'infiammazione e ridurne il rilie -

vo. Ma la natura non resta a guardare: estratti di centella asiatica, rosa mosqueta e germe di grano sono straordinari nel modulare la riparazione dei tessuti, accompagnando la ferita verso una guarigione più discreta e naturale.

3. Luce e uniformità: correggere il colore Spesso il problema non è la forma, ma il colore. Quando la cicatrice si presenta scura o discromica, entrano in gioco gli attivi schiarenti:

• Vitamina C: un potente antiossidante che inibisce la produzione eccessiva di pigmento e illumina la zona.

• Niacinamide: perfetta per ridurre la concentrazione di melanina e, contemporaneamente, lenire il rossore.

• Acido Azelaico: il miglior alleato contro le macchie post-acne, capace di uniformare l'incarnato con precisione chirurgica.

4. Il tocco finale: idratazione e protezione

Una pelle secca è una pelle che segna. Sostanze come l’acido ialuronico, la glicerina e il pantenolo (Vit. B5) non cancellano il segno, ma ne migliorano l'elasticità, rendendolo visivamente meno netto.

Tuttavia, ogni sforzo è vano senza la protezione solare. Un SPF 50 applicato rigorosamente per almeno 12 mesi è l'unica vera garanzia per evitare che i raggi UV "fissino" il colore della cicatrice, scurendola in modo permanente. Trattare una cicatrice richiede pazienza e costanza, ma con gli attivi giusti, quel segno può trasformarsi da inestetismo a un ricordo quasi invisibile. (C. C.).

BIOLOGI: NON PIÙ "FIGLI DI UN DIO MINORE".

COMPETENZE AMBIENTALI E DI

COMUNITÀ APRONO UNA NUOVA

ERA DI DIGNITÀ PROFESSIONALE

Il presidente della FNOB, Vincenzo D’Anna, ha illustrato le significative novità che stanno rivoluzionando la professione nel corso del meeting “Le frontiere dell’ecotossicologia 2026” tenutosi presso l’Università “Federico II” di Napoli

La figura del biologo diverrà sempre più centrale. Lo ha detto il Presidente della Federazione Nazionale degli Ordini dei Biologi (FNOB), Vincenzo D’Anna, che, in occasione del meeting “Le frontiere dell’ecotossicologia 2026” tenutosi il 23 gennaio scorso presso l’aula magna “L. Sorrentino” del dipartimento di Farmacia dell’Università “Federico II” di Napoli, ha illustrato le significative novità che stanno rivoluzionando la professione del biologo in Italia.

D’Anna ha sottolineato la necessità di una radicale ristrutturazione legislativa, data l'obsolescenza della precedente legge del 1967. Un focus particolare è stato posto sul ruolo strategico del biologo ambientale, che ottiene un riconoscimento senza precedenti. Per la prima volta, i biologi ambientali avranno la possibilità di accedere alla scuola di igiene pubblica ad indirizzo ambientale, «ed è la prima volta che i biologi ambientali possono accedere a questa tipologia di scuole - ha dichiarato D'Anna -, aprendo le porte a ruoli nelle direzioni sanitarie e nei dipartimenti di prevenzione».

Le competenze riconosciute spaziano dall'analisi degli

ecosistemi acquatici e territoriali, alla salvaguardia della biodiversità, alla valutazione di impatto ambientale fino alla gestione di laboratori ambientali e alla certificazione. Guardando al futuro, è stato annunciato un "albero delle opportunità" dotato di intelligenza artificiale, che guiderà i biologi attraverso le circa 80 diverse attività professionali disponibili.

Un progetto ambizioso, il "biologo di comunità", mira a inserire i biologi negli enti locali (Comuni, Province, Regioni) per svolgere una molteplicità di funzioni, dalla gestione di parchi e giardini, alla depurazione delle acque, allo smaltimento dei rifiuti, all'igiene alimentare e alle diete nelle mense scolastiche. Il presidente D'Anna ha concluso sottolineando l'importanza di formare i giovani biologi non solo con un solido bagaglio teorico, ma soprattutto con i rudimenti pratici della professione, affinché possano rispondere efficacemente alla domanda cruciale del mercato del lavoro: «tu che sai fare?».

Tra i promotori del convegno Anna De Marco, docente di ecologia ed ecotossicologia presso il Dipartimento di Farmacia dell'Università Federico II di Napoli: «la biologia

studia la vita e lo studio della vita non può prescindere dalla valutazione della qualità ambientale - ha dichiarato De Marco -. L'ambiente è tutto ciò che contiene la vita, quindi il biologo ha un ruolo essenziale nella valutazione della qualità dell'ambiente e di conseguenza della nostra salute».

La docente sottolinea l'importanza dell'approccio "One Health", affermando che «Oggi si parla tanto di approccio “One Health” ed è proprio questo il senso del biologo e del biologo ambientale, cioè assicurare la salvaguardia e la qualità dell'ambiente per essere certi della qualità della nostra vita e della nostra salute». In questo contesto, l'e -

cotossicologia si rivela una disciplina cruciale. Tra i relatori anche Giorgio Gilli professore emerito di Igiene presso l'Università di Torino che ha sottolineato: «La chimica analitica consente l’identificazione di un gran numero di molecole in matrici ambientali (acque e aria), ma opera prevalentemente in modo monoparametrico.

La biologia, grazie ai suoi progressi, offre strumenti per valutare gli effetti biologici complessivi delle miscele, fornendo una prospettiva integrata cruciale per comprendere l’impatto sulla salute umana e orientare la costruzione di norme a livello nazionale e internazionale». «L’analisi chimica è straordinaria ma monoparametrica. La biologia valuta gli effetti di miscele e gli esiti biologici sull’organismo. Pertanto, è necessario integrare i risultati chimici con strumenti biologici di laboratorio, aggiornando le normative nazionali e internazionali per riflettere questi avanzamenti, come richiamato anche nella prolusione del Presidente D'Anna».

L’obiettivo è passare dalla mera identificazione alla valutazione dell’impatto sull’organismo. (M. A.).

Il Corso di Laurea Magistrale in Tossicologia Chimica e Ambientale (TCA) del Dipartimento di Farmacia dell’Università degli Studi di Napoli Federico II - Unina – offre una formazione unica e innovativa per affrontare le sfide ambientali del nostro tempo. Con un approccio interdisciplinare, il corso, diretto dalla professoressa Anna De Marco, combina le conoscenze di chimica, biologia, ecologia e diritto per formare specialisti in grado di gestire e risolvere i problemi ambientali.

La sostenibilità ambientale al centro del percorso formativo. Il Corso di Laurea Magistrale in TCA risponde alla crescente richiesta della società e del mercato di figure professionali con competenze analitiche, valutative e gestionali in ambito Ambientale, Biotossicologico ed Ecotossicologico. Il corso si concentra sulle tematiche più attuali, come l’inquinamento ambientale, la contaminazione da microplastiche, il trattamento dei rifiuti e la dispersione di prodotti chimici ed i loro effetti sull’ecosistema e nell’uomo.

Le materie di studio:

• Chimica delle matrici ambientali e loro analisi

• Biochimismo

• Biotossicologia

• Ecotossicologia

• Fisiopatologia

• Legislazione ambientale

• Geochimica ambientale

Profilo: I laureati in TCA saranno in grado di ricoprire ruoli di:

• Direzione, gestione e coordinazione dei processi volti alla salvaguardia della biosfera e al monitoraggio dei rischi chimici, biologici e tossicologici in enti pubblici o privati predisposti

• Specialista nelle strutture pubbliche o private destinate al recupero, al risanamento e alla bonifica chimico-fisica nonché microbiologica di aree particolarmente rischiose per la salute dei cittadini

• Ricercatore in Istituti pubblici o privati nazionali ed internazionali focalizzati sullo studio dell’ambiente e delle possibili fonti di rischio per la salute dei cittadini

La missione della giovane ricercatrice è ambiziosa: trasformare il sistema immunitario in una "squadra intelligente" capace di comunicare, cooperare e sconfiggere malattie finora considerate inattaccabili

VELIA SICILIANO: LA BIOLOGIA SINTETICA E LA SFIDA AI TUMORI SOLIDI. «NON ARRENDERSI

MAI, IL FALLIMENTO FORGIA IL CARATTERE»

V“elia Siciliano è una ricercatrice italiana che lavora presso l’Istituto Italiano di Tecnologia (IIT) di Napoli, dove dirige il laboratorio di Biologia Sintetica e di Sistemi per la Biomedicina. È una scienziata a tutto tondo. Solerzia, passione e resilienza sono i tratti distintivi della sua personalità, che non si abbatte dinanzi ad alcun ostacolo. Una donna che ama il lavoro di squadra e la sana competitività, che non è mai arrivismo o arroganza. Il suo motto è: mai arrendersi. Un fallimento o una porta chiusa in faccia sono esperienze che forgiano il carattere e incitano a fare di più, percorrendo nuove strade.

In questa intervista a cuore aperto, Velia Siciliano ci svela il fulcro della sua ricerca “TeaM”, che ha ottenuto un finanziamento di oltre 2 milioni di euro dall’European Research Council (ERC) e che si concentra sull'applicazione della biologia sintetica per sviluppare nuove terapie contro i tumori, utilizzando cellule immunitarie come i linfociti T e i macrofagi. Un lavoro intenso, fatto di ore in laboratorio, ma anche di gioco di squadra e multidisciplinarietà.

Dottoressa Siciliano, partiamo da una domanda che può apparire retorica: da tempo la Federazione Nazionale degli Ordini dei Biologi - e in particolare il suo presidente, Vin cenzo D'Anna - sostiene che la biologia sia la scienza del terzo millennio. È d’accordo?

«Assolutamente sì. La biologia è il cardine centrale intorno a cui si muovono, come satelliti, le altre discipline. Immagino la biologia come un grande ombrello sotto cui tante altre scienze si integrano e cooperano per migliorare la qualità della vita degli esseri umani».

Come ha deciso di intraprendere la carriera nella ricerca e cosa l’ha ispirata?

«Quando ho iniziato, da neolaureata nel 2006, mi sono trovata dinanzi a una disciplina nuova, nata intorno agli anni 2000 per progettare e costruire sistemi biologici inediti, come circuiti genetici, cellule e organismi. Ho incontrato ingegneri che definisco “visionari”, capaci di vedere oltre il possibile. Oggi la biologia sintetica crea soluzioni innovative non solo in campo medico e farmaceutico, ma anche industriale e ambientale: si va dall'uso di microrganismi per produrre energia rinnovabile o ripulire l’inquinamento, fino all'agricoltura, con la creazione di piante più resistenti. Il mio settore specifico riguarda lo sviluppo di nuove terapie attraverso l'ingegnerizzazione di cellule immunitarie per combattere i tumori».

In che modo la biologia sintetica cambierà il nostro ap proccio alle malattie?

«Perché aiuta a leggere la complessità. Nella ricerca siamo sempre stati settoriali, ma oggi la chiave è la multidisciplinarietà. Il nostro progetto integra la biologia sintetica

con altre materie: la fisica e la chimica restano le fondamenta; l’ingegneria fornisce gli strumenti per costruire i “recettori sintetici”; l’informatica e l’Intelligenza Artificiale vengono utilizzate per realizzare un “codice”, un linguaggio che permetta a macrofagi e cellule T di comunicare».

Veniamo alla sua ricerca sulla "sinapsi arti ficiale" per contrastare i tumori solidi. Può spiegarci come funziona questa tecnologia?

«L’idea è agire su due classi di cellule, coordinandole. Il lavoro punta a unire i linfociti T, che devono uccidere le cellule malate, e i macrofagi, che nei tumori solidi possono “tradire" l’organismo favorendo la crescita della massa. La svolta è data dai “recettori sintetici” (a base di DNA e proteine) disegnati nei nostri laboratori all'IIT. Questi funzionano come un “ponte molecolare” che permette ai linfociti T di agganciarsi ai macrofagi e inviare loro segnali biochimici specifici. La nostra sfida è far sì che questo ponte si attivi esclusivamente nell’ambiente tumorale».

Come viene garantita questa precisione?

«Grazie a circuiti genetici intelligenti (logic gates), le cellule vengono programmate per attivare la funzione distruttiva solo quando rilevano contemporaneamente più segnali tipici del tumore, evitando di colpire i tessuti sani. Una volta stabilito il contatto tramite il ponte sintetico, i linfociti T “istruiscono” i macrofagi a cambiare natura: da alleati del tumore di -

ventano suoi nemici. L’organismo scatena così un attacco coordinato, potente e mirato».

È questa la strada per superare i limiti delle attuali immunoterapie?

«Lo credo fortemente. Questa architettura rappresenta una delle applicazioni più avanzate della biologia sintetica per superare l’ostilità dei tumori solidi. Lavoriamo su modelli pre-clinici avanzati per superare i limiti delle attuali CAR-T, efficaci nei tumori del sangue ma in difficoltà contro quelli solidi a causa della scarsa infiltrazione e della tossicità "off-target". Ci stiamo concentrando sul tumore ovarico, con i primi test anche sul melanoma».

Nella pratica, come si attua questa terapia?

«L’obiettivo è estrarre dal sangue del paziente entrambi i “guerrieri”: cellule T e macrofagi. All'IIT di Napoli modifichiamo geneticamente entrambe le classi inserendo i recettori sintetici, che fungono da software di comunicazione. Una volta re-infuse, le cellule non agiscono più isolate: quando una cellula T incontra un macrofago nei pressi del tumore, il "ponte" permette loro di dialogare.

La cellula T istruisce il macrofago a distruggere la barriera protettiva del tumore, permettendo alla cellula T di penetrare e uccidere le cellule cancerose. Il tumore perde così i suoi alleati e non può più ingannare il sistema immunitario».

Quali sono i prossimi passi e quando arrive ranno i trial clinici?

«Il finanziamento dell’ERC copre 5 anni, durante i quali consolideremo i modelli pre-clinici in vivo per dimostrare sicurezza ed efficacia. L’obiettivo è arrivare ai trial clinici sull'uomo allo scadere di questo periodo. Sarà necessario trovare investitori che scommettano sul prodotto per l'immissione sul mercato; come IIT, siamo molto orientati verso la creazione di start-up».

Come pensa che il Suo progetto possa essere applicato ad altre aree della medicina o della ricerca?

«Scommetto sulla terapia multi-cellulare come il prossimo grande salto tecnologico dopo il successo delle CAR-T. La biologia sintetica è una tecnologia estremamente versatile

© Blackboard/shutterstock.com

e applicabile a diversi ambiti della medicina. Il nostro lavoro si basa sulla creazione di un vero e proprio linguaggio di programmazione che possiamo ridisegnare per altri contesti, come le neuroscienze, le malattie neurodegenerative - ad esempio la sclerosi multipla - o le patologie autoimmuni e metaboliche, come il diabete di tipo 1».

Quali sono stati i momenti più importanti del la Sua carriera e come hanno influenzato il Suo lavoro attuale?

«In primis, la scelta del dottorato di ricerca in Biologia Sintetica. Fondamentale per la mia formazione è stata la figura di Diego Di Bernardo, mio mentore durante il percorso al Telethon Institute of Genetics and Medicine (TIGEM). Sotto la sua guida ho svolto le prime ricerche nel campo della biologia sintetica e dei sistemi, focalizzandomi sulla bioingegneria dei sistemi biologici. Insieme abbiamo collaborato a pubblicazioni scientifiche sulla progettazione e il controllo di circuiti genetici in cellule di mammifero.

Dopo l'esperienza al TIGEM, ho proseguito all'MIT di Boston, che per me è stata una vera palestra di vita: lì nulla viene tralasciato e ogni idea, anche la più apparentemente strampalata, viene presa seriamente in considerazione. Successivamente ho deciso di tornare in Europa, prima all'Imperial College di Londra e infine in Italia, come Principal Investigator presso l'Istituto Italiano di Tecnologia. Ho ricevuto un'ottima proposta con un budget che consente a me e al mio team di fare ricerca ad alti livelli».

VQuali consigli darebbe ai giovani ricercatori che vogliono intraprendere questo percorso?

«Consiglierei di allenarsi al fallimento: bisogna imparare a cadere e a non abbattersi al primo ostacolo. Poi, farsi guidare da una sana ambizione, dote fondamentale per raggiungere i propri obiettivi. Non si deve diventare scienziati "per forza"; la passione è la qualità che cerco in un giovane, perché la passione cancella parole come "sacrificio" o "rinuncia".

Io, ad esempio, pur lavorando moltissimo, sento di non aver rinunciato a nulla: ho frequentato i miei amici, uscivo la sera. Anche l'ambiente lavorativo è stato un'occasione di arricchimento umano.

Penso alle notti trascorse in laboratorio a Boston aspettando i risultati di un esperimento: se hai quella voglia febbrile di vedere il frutto del tuo lavoro, non senti il peso delle ore. Infine, credo che aiuti molto la mentalità che deriva dallo sport anche agonistico. A me la pallavolo ha insegnato il valore del gioco di squadra e la capacità di metabolizzare le sconfitte. Per questo consiglio sempre ai giovani di praticare una disciplina sportiva».

Qual è il Suo punto di vista sul futuro della ricerca in biologia sintetica e immunologia?

«Sono convinta che la biologia sintetica rappresenti il futuro e che l'Italia debba investire con decisione in questo campo. Attualmente siamo ancora poche realtà; il mio augurio è che, tra qualche anno, saremo in molti di più a occuparcene, creando un ecosistema sempre più forte». (M. A.).

elia Siciliano è una delle voci più autorevoli e innovative nel panorama della Biologia Sintetica internazionale. Napoletana di origine e cittadina del mondo per formazione, dal 2017 guida il Synthetic and Systems Biology for Biomedicine Lab presso il centro dell'Istituto Italiano di Tecnologia (IIT) di Napoli. Il suo percorso accademico è segnato dall'eccellenza e dal desiderio di superare i confini della biologia tradizionale. Le radici al TIGEM: Sotto la guida del suo mentore Diego Di Bernardo, muove i primi passi nella bioingegneria dei sistemi, imparando a "programmare" le cellule come se fossero circuiti elettronici. L’esperienza internazionale: Si trasferisce negli Stati Uniti per un post-dottorato al MIT (Massachusetts Institute of Technology), all'interno del prestigioso Synthetic Biology Center, dove affina l'approccio visionario e la resilienza necessari per la ricerca di frontiera. Prosegue poi la sua carriera nel Regno Unito, presso l'Imperial College di Londra, prima di rispondere alla chiamata del "rientro dei cervelli" in Italia. I successi e i finanziamenti: La sua ricerca ha ottenuto i più alti riconoscimenti europei, tra cui ben tre grant dell’European Research Council (ERC). L’ultimo, il progetto TeaM, ha ricevuto oltre 2 milioni di euro per sviluppare una nuova generazione di terapie immunologiche contro i tumori solidi. Scienziata, ex pallavolista e convinta sostenitrice del lavoro di squadra, Velia Siciliano incarna un modello di ricerca che non teme il fallimento, ma lo usa come trampolino di lancio per l'innovazione.

Un settore emergente che aprirà nuove strade per la categoria Lo studio del comportamento di virus e batteri in assenza di gravità aiuterà la qualità della vita sulla Terra

Il presidente della Fnob, Vincenzo D'Anna, al convegno "La Biomedicina e la biotecnologia nello spazio” convegno organizzato il 14 gennaio 2026 dal dipartimento di Benessere, salute e sostenibilità ambientale dell’Università di Roma “Sapienza”.

E L’UMANITÀ

a migliorare

“La Biomedicina e la biotecnologia nello spazio” è il titolo del convegno organizzato lo scorso 14 gennaio 2026 dal dipartimento di Benessere, salute e sostenibilità ambientale dell’Università di Roma “Sapienza”, negli spazi della Casa dell’Aviatore. Per la Fnob erano presenti il presidente Vincenzo D’Anna, il vicepresidente Alberto Spanò e il direttore Pasquale Piscopo.

«Il tema di oggi – ha detto Vincenzo D’Anna – è particolarmente caro ai biologi. La Fnob nell’ultimo periodo ha investito risorse affinché i biologi possano impegnarsi attivamente nel campo della biomedicina e della biotecnologia spaziale, una nuova e promettente frontiera professionale».

La Federazione ha infatti recentemente finanziato delle borse di studio per favorire la formazione di biologi che opereranno all’interno di due mini-laboratori nei quali verranno condotti studi in condizioni di microgravità. Un laboratorio sarà dedicato a verificare la possibilità di coltivare grano sul suolo lunare, utile a sostenere la vita umana nello spazio. L’altro si occuperà della crescita e dello sviluppo di batteri, virus e funghi che crescono nel nostro intestino, per comprendere il funzionamento del corpo umano durante le missioni. Il progetto è figlio della collaborazione che l’Ente ha sottoscritto con l’Asi (Agenzia spaziale italiana) e con il gruppo Space Factory (leader per la progettazione e sviluppo di tecnologie innovative che sfrutta le potenzialità del settore spaziale per promuovere innovazione sulla Terra).

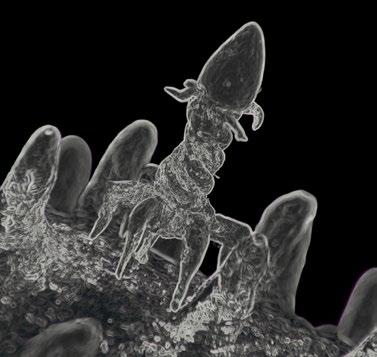

La ricerca scientifica in condizioni di microgravità sta da tempo ampliando gli orizzonti delle scienze biologiche e della ricerca. Un recente esperimento condotto a bordo della Stazione Spaziale Internazionale (ISS), pubblicato sulla rivista internazionale Plos Biology, ha infatti dimostrato che in assenza di gravità i microrganismi sono soggetti a regole evolutive diverse rispetto a quelle terrestri. I ricercatori si sono accorti che un’infezione virale semplice, nello spazio assume caratteristiche completamente nuove, poiché i virus e batteri sono in grado di modificare le loro strategie di sopravvivenza e adattarsi al nuovo contesto. Le infezioni così diventano più lente, ma continue, e il patrimonio genetico del patogeno si modifica presentando mutazione nuove e totalmente diverse da quelle terrestri.

«Quella che si presenta davanti a noi è un’esperienza unica - prosegue D’Anna – che dimostra come l’Italia sia, ancora una volta, all’avanguardia nella sperimentazione delle life-sciences e dei farmaci del futuro. L’auspicio è che possano presto costituirsi percorsi di studio finalizzati ad avvicinare i biologi al settore delle bioscienze spaziali».

In quest’ottica, la Fnob è in procinto di organizzare un evento scientifico che tratti proprio questi argomenti, affinché gli iscritti attenzionino questa nuova branca occupazionale.

ATTIVA LA NUOVA AREA RISERVATA “MYBIO”

Tra le novità c’è la premialità basata sull’utilizzo e sul punteggio rating

di Vincenzo D’Anna Presidente della Fnob

Cari Colleghi, è attiva la nuova area riservata “MyBio” dedicata esclusivamente ai biologi iscritti all’Albo.

Tra le novità, quella che riguarda l’assegnazione di un punteggio, detto Rating, che verrà assegnato a coloro che, a partire da febbraio prossimo, utilizzeranno maggiormente le funzionalità di questo spazio web dedicato. Si tratta di premiare chi segue e si informa sulle attività e la vita stessa della Federazione Nazionale degli Ordini Regionali, favorire coloro che vogliono essere parte attiva ed avveduta della Categoria che continua ad essere estranea per molti iscritti. Un incentivo per fidelizzare e responsabilizzare i Biologi Italiani.

Qui di seguito il dettaglio, sui criteri che determinano l’assegnazione del Rating per ciascun iscritto:

• 1 punto per l’accesso all’area riservata;

• 5 punto per la lettura del Giornale dei Biologi,

• 2 punti per la lettura di mail, pec e news,

• 10 punti per l’avvenuta iscrizione e partecipazione agli eventi Fnob.

Il biologo che raggiungerà la soglia rating di 70 punti, riceverà delle premialità, come il diritto di precedenza nell’iscrizione e nella partecipazione a eventi, corsi e convegni Ecm o Fad organizzati dalla Fnob, la possibilità di accedere alle scuole di formazione sul campo organizzate dalla Fondazione Italiana Biologi (Fib), la pubblicazione di un proprio articolo scientifico (preventivamente concordato e valutato dal comitato di redazione e dal Comitato centrale della Federazione) sul webmagazine “Giornale dei Biologi”, l’assegnazione di contributi e borse di studio per master e summer school.

© maybeiii/shutterstock.com

La legge di Bilancio 2026 (legge n. 199 del 30 dicembre 2025) porta il finanziamento della sanità a 142,9 miliardi di euro, con un incremento di 6,3 miliardi rispetto al 2025. Le nuove risorse sono destinate in via prioritaria al recupero delle liste d’attesa, al rafforzamento del personale, alla prevenzione e al consolidamento del Servizio sanitario nazionale nella fase post-PNRR.

Nel periodo 2022-2026 i fondi per la sanità sono cresciuti complessivamente di 17,7 miliardi (+14,1%). L’andamento

resterà positivo anche nel biennio successivo: il Fondo sanitario nazionale aumenterà di 2,631 miliardi nel 2027 e di 2,633 miliardi nel 2028, livelli che saranno confermati negli anni successivi. Tra le principali novità, la possibilità per gli enti dei servizi sanitari regionali di assumere personale a tempo indeterminato in deroga agli attuali vincoli. Le Regioni potranno inoltre rafforzare le risorse destinate a premi e indennità per il personale dei pronto soccorso. Sono introdotte indennità di specificità per medici, veterinari, infermieri e operatori socio-sanitari, mentre viene estesa

Primo Piano

SANITÀ: MANOVRA DA 143 MILIARDI

La legge di Bilancio 2026 porta un incremento di 6,3 miliardi rispetto allo scorso anno. Le nuove risorse saranno destinate al recupero delle liste d’attesa, al rafforzamento del personale e alla prevenzione

anche agli infermieri delle strutture private accreditate la tassazione agevolata al 5% sugli straordinari. Sul fronte della spesa sanitaria, cambiano i tetti per la farmaceutica, sia per gli acquisti diretti sia per la convenzionata. Viene inoltre introdotto un nuovo limite di spesa per i dispositivi medici, in risposta alla crescente innovazione tecnologica e alla necessità di rinnovare il parco apparecchiature.

La manovra stanzia 100 milioni per l’adeguamento delle tariffe ambulatoriali e 1 miliardo per la revisione delle tariffe di ricovero e riabilitazione. Ampio spazio alla prevenzione: sono previsti interventi su screening mammografici e colon-rettali, estensione dei test genomici, rafforzamento degli screening neonatali e di quelli legati all’inquinamento ambientale, oltre a misure per la medicina di precisione, la salute mentale e le cure palliative.

Per rendere più efficiente l’uso delle risorse, entro il 31 marzo 2026 un decreto del Ministero della Salute, di concerto con il MEF, definirà nuove regole di riparto del Fondo sanitario nazionale, con verifiche sull’effettivo utilizzo dei fondi per le finalità assistenziali previste. Le farmacie

pubbliche e private convenzionate vengono riconosciute a pieno titolo come strutture del SSN e potranno erogare prestazioni sanitarie secondo criteri definiti dal Ministero, con particolare attenzione alle aree rurali e disagiate.

L’AIFA dovrà aggiornare annualmente il Prontuario terapeutico nazionale. Cresce inoltre il tetto di spesa per l’acquisto di prestazioni dai privati accreditati, che dal 2026 aumenta dell’1% rispetto ai limiti fissati dalla Spending Review. Spinta anche alla sanità digitale: saranno realizzate infrastrutture per lo scambio transfrontaliero dei dati sanitari in ambito UE, interconnesse con il Sistema Tessera Sanitaria. AGENAS rafforzerà la telemedicina, dotando i professionisti di strumenti idonei al monitoraggio dei pazienti. Aumentano infine i fondi per i bambini affetti da patologie oncologiche ed epilessia e viene potenziata l’assistenza domiciliare integrata per i pazienti cronici complessi, con linee guida nazionali sulle dimissioni protette. Sul fronte delle proroghe, il Milleproroghe estende al 31 dicembre 2026 lo scudo penale per i professionisti sanitari, limitando la responsabilità ai casi di colpa grave. Confermato il limite di 68 anni per la nomina dei direttori generali di ASL ed enti del SSN e prorogate alcune deroghe alle incompatibilità per diverse professioni sanitarie. Per il recupero delle liste d’attesa, nel 2026 restano possibili incarichi a termine e collaborazioni con medici specializzandi. Infine, diventa strutturale l’esonero dalla fatturazione elettronica per le prestazioni sanitarie rese a persone fisiche: una misura che, a differenza degli anni precedenti, non richiede più proroghe annuali. Il provvedimento non interviene invece sul riordino della rete dei laboratori, mentre risultano rinnovate tutte le tutele previdenziali per biologi, medici, infermieri, tecnici e veterinari.

Primo Piano

© VGstockstudio/shutterstock.com

LA CORTE COSTITUZIONALE

LEGITTIMA LA PRESENZA DEL BIOLOGO NUTRIZIONISTA

NEI CENTRI PER LA CURA DEI DCA

Con la sentenza 4/2026, la Corte Costituzionale ha legittimato la presenza del Biologo nutrizionista nei centri per la cura dei Disturbi del Comportamento Alimentare (DCA). Si aggiunge così, ad una già consolidata e folta giurisprudenza, una ulteriore importantissima sentenza.

La decisione è riferita al ricorso

promosso dal Presidente del Consiglio dei Ministri che intendeva dichiarare l’illegittimità dell’articolo 117 della legge della Regione Puglia 31 dicembre 2024, n. 42, nella quale veniva inserita la figura professionale del Biologo Nutrizionista negli organici della Rete di assistenza per i Disturbi del Comportamento Alimentare.

La sentenza, oltre a richiamare

Confermate le competenze e la necessita di avere negli organici del SSN il Biologo Nutrizionista: così la Sentenza 4/2026

leggi e normative dello stato, tra cui la legge n. 396 recante “Ordinamento della professione di biologo”, fa riferimento anche ai Regolamenti emanati dall’Ordine Nazionale dei Biologi, nell’anno 2019, confermati e aggiornati oggi dalla Federazione Nazionale degli Ordini dei Biologi (FNOB,) che individuano codici di attività per il Biologo Nutrizionista, specificando le competenze e gli ambiti professionali a lui attribuiti.

Sempre nella stessa Sentenza si legge che in piena autonomia il Biologo, come il Medico, può elaborare diete e fornire consulenze nutrizionali.

Primo Piano

“ BLERINA JANCE, LA BIOLOGA DEL SAN GERARDO PREMIATA

PER LA SCOPERTA SULLA

PSEUDOIPERKALIEMIA FAMILIARE

Sospetto nato da un esame di routine: così un valore di potassio “fuori scala” ha portato a individuare una rara variante genetica ereditaria

di Emanuela Birra

Dott.ssa Jance, il suo lavoro è stato premiato per aver por tato alla diagnosi di una rara variante genetica ereditaria. Com’è nato tutto da un esame di routine e qual è stato il segnale che le ha fatto capire che “qualcosa non tornava”?

Tutto è iniziato da un esame di routine eseguito presso il nostro centro prelievi. Al paziente sono stati prelevati contemporaneamente due campioni: uno per l’emogasanalisi e uno per i test di biochimica. Il dato che ha immediatamente attirato la nostra attenzione è stato un valore di potassio estremamente elevato rilevato dall’emogasanalizzatore, un risultato chiaramente incompatibile con il quadro clinico del paziente, che era stabile e completamente asintomatico.

Il vero campanello d’allarme, però, è scattato nel momento in cui abbiamo confrontato questo dato con il potassio sierico, che risultava perfettamente nei limiti di normalità. Una discrepanza così marcata tra due misurazioni dello stesso parametro non è fisiologicamente plausibile e rappresenta un chiaro segnale di possibile interferenza preanalitica. In quel momento abbiamo capito che non ci trovavamo di fronte a una vera iperkaliemia, ma a un fenomeno artefattuale che meritava un’analisi approfondita.

Facciamo chiarezza: che cos’è la pseudoiperkaliemia fami liare, perché il potassio risulta alto “solo in apparenza” e quali persone o famiglie può riguardare?

La Pseudoiperkaliemia Familiare è una rara condizione ereditaria a trasmissione autosomica dominante, causata da mutazioni del gene ABCB6, che codifica una proteina

presente sulla membrana dei globuli rossi.

In questi soggetti, gli eritrociti presentano una aumentata permeabilità al potassio quando il sangue viene conservato a basse temperature. Il risultato è una fuoriuscita di potassio dalle cellule verso il plasma in vitro, che genera un valore falsamente elevato al momento della misurazione. Nel paziente, però, il potassio circolante è normale e non esiste un reale rischio clinico.

Questa condizione può riguardare singoli individui o più membri della stessa famiglia e spesso rimane sconosciuta, proprio perché è silente e si manifesta solo in particolari condizioni di laboratorio.

LA PSEUDOIPERKALIEMIA FAMILIARE

È UNA RARA CONDIZIONE EREDITARIA A TRASMISSIONE AUTOSOMICA DOMINANTE, CAUSATA DA MUTAZIONI DEL GENE ABCB6, CHE CODIFICA UNA PROTEINA PRESENTE SULLA MEMBRANA DEI GLOBULI ROSSI

Quando ha capito che non era un’anomalia qualsiasi ma un indizio di qualcosa di più grande, qual è stato il suo primo pensiero?

Il primo pensiero è stato legato alla responsabilità del laboratorio: evitare un errore diagnostico potenzialmente pericoloso per il paziente. Un valore di potassio così eleva -

to può indurre a interventi terapeutici urgenti e invasivi che, in questo caso, sarebbero stati del tutto inutili e persino dannosi. Dal punto di vista scientifico, invece, è stato subito evidente che ci trovavamo di fronte a un caso estremamente istruttivo: un esempio concreto di quanto la fase preanalitica e il contesto clinico siano determinanti nell’interpretazione dei risultati. Da lì è nato l’obiettivo di studiare il fenomeno in modo rigoroso, riproducibile e documentabile.