STORIE DI ECCELLENZA E INNOVAZIONE

Infrastrutture, ma anche competenze e lavoro: dopo il capitolo PNRR, l'Italia entra in una nuova fase di (necessaria) trasformazione

La nuova rivoluzione promessa, che non potrà fare a meno del cloud.

Il mercato delle soluzioni informatiche per il settore assicurativo spalanca le porte all’AI.

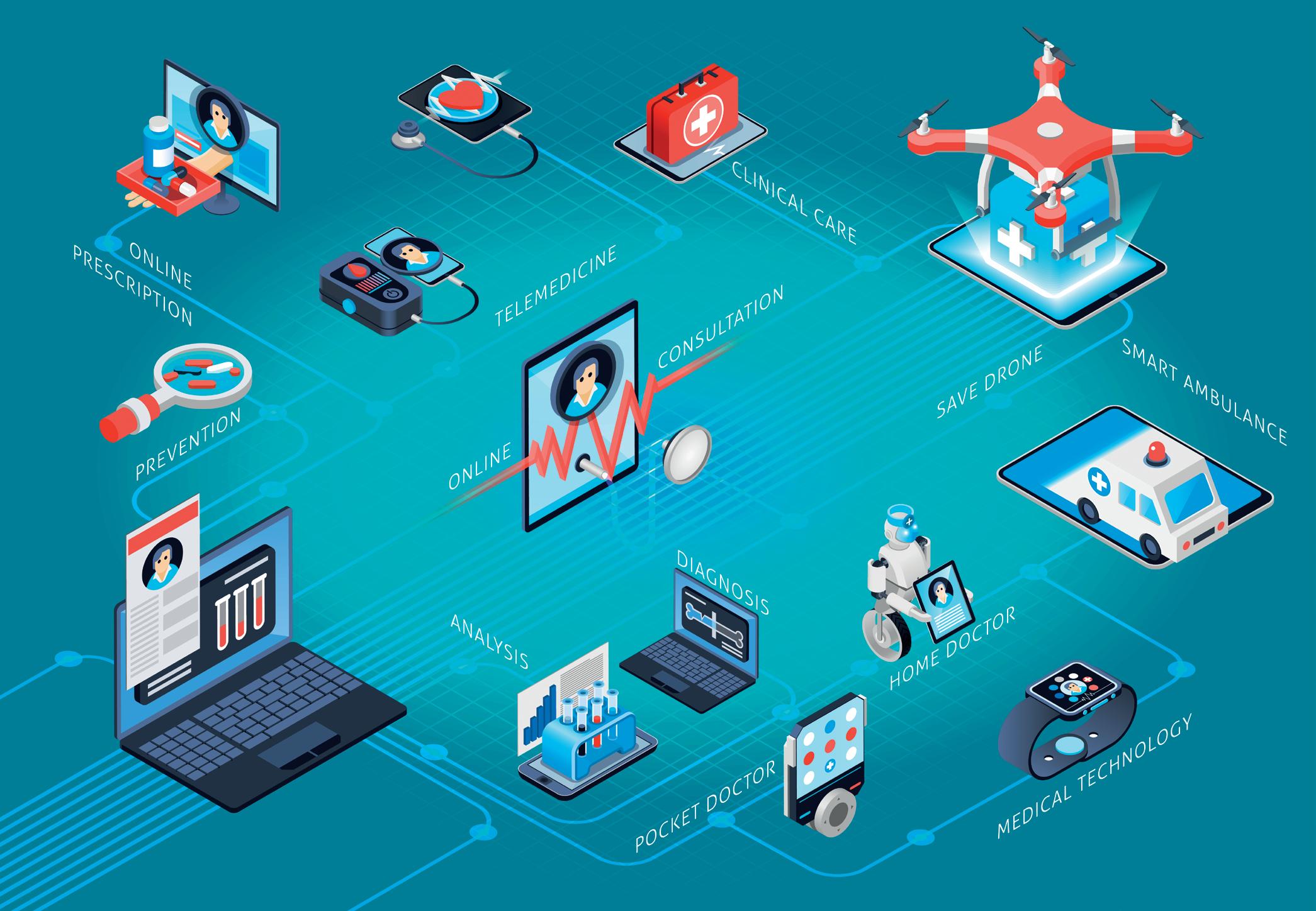

SPECIALE HEALTHCARE

Tecnologie, dati, privacy, persone: le sfide da vincere per la sanità italiana.

19-20 novembre 2025

N° 69 - OTTOBRE 2025

Periodico mensile registrato

presso il Tribunale di Milano al n° 378 del 09/10/2012

Direttore responsabile:

Emilio Mango

Coordinamento:

Valentina Bernocco

Hanno collaborato:

Camilla Bellini, Roberto Bonino, Giancarlo Calzetta, Gianluca Dotti, James Hughes, Andrea Tinti, Elena Vaciago

Foto e illustrazioni: Freepik, Pixabay, Unsplash, Shutterstock

Editore e redazione:

Indigo Communication Srl Via Ettore Romagnoli, 6 - 20146 Milano tel: 02 499881

Pubblicità:

TIG - The Innovation Group Srl tel: 02 87285500

Stampa: Ciscra SpA - Arcore (MB)

© Copyright 2024

The Innovation Group Srl Tutti i diritti di proprietà letteraria e artistica riservati.

Il Sole 24 Ore non ha partecipato alla realizzazione di questo periodico e non ha responsabilità per il suo contenuto.

Pubblicazione ceduta gratuitamente.

Una scommessa sul futuro

Nuvola tricolore in espansione

Enti locali alla prova del nove

Il manifesto del fallimento della globalizzazione

Un momento difficile, nascosto dall’invasione cinese

L’Europa, il cloud e la montagna impossibile da scalare

L’interscambio è resilienza

AI e servizio clienti: attenzione alle “trappole”

Il valore (anche invisibile) del procurement

Non trasformazione, ma transizione digitale

Agritech italiano per le sfide climatiche

Erp e intelligenza artificiale, un incontro fruttuoso

Il digitale entra in negozio 26

Cloud, la scorciatoia per la prossima rivoluzione

L’incontro tra due mondi

Fra dati, tecnologie e collaborazione

Tecnologie e progetti di trasformazione

Personalizzazione, automazione e azione

L’innovazione è assicurata

44

Il cambiamento è la costante

Azienda Trasporti Milanesi

Agos

Vetri Speciali

Gruppo Morellato

Il lavoro, il welfare, i servizi pubblici, la competitività

nello scacchiere internazionale: gli investimenti in digitale sono un passaggio obbligato per il nostro Paese.

Il mercato digitale è oggi un sorvegliato speciale. Le tecnologie dell’informatica e delle telecomunicazioni – da strumenti a supporto dell’efficienza o, al più, dei modelli di business delle aziende – sono diventate un pilastro essenziale nei meccanismi di crescita e competitività degli Stati e dei territori. Il ritorno della guerra ai confini dell’Unione Europea e il rafforzamento delle tensioni commerciali e politiche tra grandi potenze, in primis Stati Uniti e Cina, danno evidenza di un ruolo centrale del digitale nell’influenzare lo svolgimento bellico e gli scontri commerciali. Ma

non solo: i Paesi europei, e in particolare l’Italia, si trovano oggi ad affrontare una serie di sfide e trasformazioni critiche, in cui il digitale offre strumenti per mitigare o contrastare i possibili risvolti e impatti negativi. Il calo demografico, la trasformazione del mercato del lavoro e dell’impiego pubblico sono tendenze ormai in atto, che sempre più nei prossimi anni mostreranno i loro effetti sulla struttura, sull’organizzazione e sulla capacità di generare valore del Paese: il digitale, e in particolare l’intelligenza artificiale, può indubbiamente diventare un elemento rilevante all’interno di una strategia che

richiede però, più in generale, una complessa attività di ripensamento e riorganizzazione. Questi temi trovano maggior approfondimento all’interno della decima edizione del rapporto annuale di TIG – The Innovation Group, Digital Italy 2025 – Liberare il potenziale dell’innovazione, edito da Maggioli Editore: un lavoro che raccoglie, oltre alle analisi dei ricercatori e dei giornalisti di TIG, le prospettive e i punti di vista di esperti, manager e accademici sulle sfide di un Paese sempre più digitale (alcuni estratti del volume sono riportati nelle pagine di questa cover story).

Pilastro di competitività

Il 2024 può essere considerato un anno di svolta per l’Europa: in un contesto geopolitico ed economico sempre più

complicato, la presentazione di due rapporti alla Commissione Europea (quello di Mario Draghi sulla competitività e l’innovazione e quello di Enrico Letta sul futuro del Mercato Unico Europeo) ha evidenziato le sistematiche debolezze dell’Unione – soprattutto in termini di capacità di innovazione e conseguentemente di competitività – e i diversi fronti su cui agire per invertire la rotta nei prossimi anni. In queste proposte, il digitale non ha un ruolo di secondo piano: è un elemento cardine del piano di intervento. Questo è evidente anche all’interno della strategia del nuovo mandato della presidente delle Commissione Europea, Ursula von der Leyen, presentata a gennaio 2025, la cosiddetta “bussola per la competitività”, che fa proprie le indicazioni dei due italiani: in questo documento, l’ambito delle tecnologie digitali diviene terreno d’azione per colmare il gap d’innovazione che rischia di indebolire la competitività e quindi la crescita del Vecchio Continente. In questo contesto, particolare rilevanza viene riconosciuta alle tecnologie più innovative, come intelligenza artificiale e quantum computing, tra gli ambiti in cui l’Unione Europea può ancora trovare spazio per ribadire il proprio ruolo nel contesto globale.

La strada del dual-use

Anche la sicurezza e la difesa nazionale e sovranazionale sono ormai sempre più dipendenti dalle tecnologie e innovazioni dell’informatica. Droni e dispositivi a guida autonoma, algoritmi e Big Data a supporto dell’intelligence militare, la disinformazione online e gli attacchi informatici sono ormai diventati fattori distintivi e di rilievo nelle strategie di difesa e negli scontri tra Stati. In questo contesto, a livello europeo ha acquistato rilevanza il tema delle tecnologie dualuse, ossia utilizzabili in ambito sia civile sia militare: investimenti in queste aree avrebbero il potenziale di promuovere lo

“Le prospettive dell’economia italiana per il biennio 2025-2026 indicano una crescita moderata ma vulnerabile, sostenuta dalla domanda interna, dal PNRR e da un contesto finanziario in graduale miglioramento. Tuttavia, i rischi al ribasso restano elevati e spaziano da shock esterni a fragilità strutturali non ancora risolte. La qualità della risposta di policy – in termini di attuazione delle riforme, credibilità fiscale e orientamento degli investimenti – sarà determinante per tracciare un percorso sostenibile di crescita nel medio periodo”.

Gregorio

De Felice

, head of research and chief economist di Intesa Sanpaolo

sviluppo di infrastrutture per la sicurezza europea, e al contempo di rafforzare asset rilevanti per la competitività delle imprese e dell’industria. Possono essere considerate tecnologie digitali dual-use la connettività satellitare, l’intelligenza artificiale, la robotica, i droni e le soluzioni di cybersicurezza. Appare però evidente che lo sviluppo di un sistema di difesa europeo richieda un approccio coordinato e “affidabile”, anche negli investimenti in digitale: non abbiamo bisogno di nuovi silos ma di soluzioni interoperabili, che tengano conto anche degli aspetti di sovranità tecnologica per assicurare l’indi-

pendenza e la sicurezza di questi sistemi. D’altra parte, il tema degli investimenti in difesa richiede un’attenta disamina, in particolare in termini di peso sul budget di spesa per il welfare. Se in passato la riduzione degli investimenti in difesa ha consentito all’Europa di liberare risorse da rivolgere verso aree di diretto impatto sulla vita dei cittadini (come la sanità e l’istruzione), occorre oggi comprendere come, ragionando in logica dual-use, si possa effettivamente supportare la spesa in digitale senza intaccare in modo significativo gli investimenti in aree essenziali per il welfare.

“La strategia dual-use non è un ripiego, ma la più potente leva strategica per l’Europa per affrontare la duplice sfida della sicurezza e della competitività. Trasforma un onere percepito (la spesa militare) in una straordinaria opportunità di investimento (l’innovazione tecnologica), ricomponendo la frattura tra le esigenze dello Stato e le priorità dei cittadini”.

Carlo Alberto Carnevale Maffè, professore di Strategia della SDA Bocconi School of Management

“Il futuro del lavoro nell’era dell’AI dipenderà da scelte collettive. Non si tratta solo di preparare i lavoratori al cambiamento, ma di decidere quale cambiamento vogliamo. La tecnologia può rendere il lavoro più produttivo, più dignitoso, più umano, ma solo se guidata da valori e istituzioni all’altezza della sfida”.

Marco Leonardi, professore ordinario di Economia dell’Università degli Studi di Milano

“La trasformazione digitale del Paese è un processo che va ben oltre l’introduzione di nuove tecnologie. Si tratta di una trasformazione culturale e organizzativa, che coinvolge tutti i livelli della Pubblica Amministrazione. L’Agenzia per l’Italia Digitale (AgID) ha un ruolo centrale nel garantire coerenza, visione strategica e continuità in un percorso che ha l’obiettivo di rendere il digitale una leva per la modernizzazione del settore pubblico, per la semplificazione della vita di cittadini e imprese e per lo sviluppo sostenibile”.

Mario Nobile, direttore generale di AgID

“L’infrastruttura digitale europea che si sta costruendo –fondata su competenze, principi valoriali, supercalcolo, intelligenza artificiale, cloud, edge e quantum computing – costituisce il pilastro di un ecosistema capace di generare innovazione, competitività e impatto sociale su scala continentale. Il ruolo dell’Italia è centrale”.

Arnaud Ceol, technical project manager, e Davide Salomoni, innovation manager di Fondazione Icsc

Sfide demografiche e lavorative Oggi i Paesi dell’Unione (e l’Italia in particolare) devono fronteggiare, oltre a una situazione geopolitica e internazionale non facile, anche rilevanti sfide interne, i cui impatti saranno determinanti nei prossimi decenni. Una questione particolarmente critica per il futuro del Paese, che richiede analisi e interventi, riguarda la trasformazione demografica e in particolare l’aumento della popolazione anziana a discapito delle fasce più giovani, con una conseguente trasformazione della società e del lavoro: meno scuole, maggiore attenzione a temi di assistenza sanitaria e long term care, riduzione della forza lavoro e un generale rischio di perdita di produttività e competitività. Verrà influenzato da queste dinamiche anche l’impiego pubblico, sia in quanto erogatore di servizi la cui domanda è in trasformazione, sia in quanto datore di lavoro in un mercato in cui la popolazione attiva va sempre più restringendosi. È un tema, d’altra parte, estremamente complesso e che ha implicazioni sul più ampio sviluppo della società e dell’economia. In questo senso, nelle strategie per la crescita del Paese, per colmare i cali già previsti e indirizzare politiche e iniziative a supporto della natalità, è da attenzionare l’idea di puntare sull’occupazione femminile e sui Neet, ovvero le persone Not in Education, Employment or Training, che non studiano né lavorano né seguono percorsi di aggiornamento professionale.

Verso il “post-digitale”

Il quadro dei cambiamenti non riguarda, d’altra parte, solamente aspetti economici e sociali che vedono nel digitale un elemento di trasformazione o soluzione. La stessa tecnologia non è immutabile, ma evolve e apporta al contesto in cui si inserisce ulteriori funzionalità e possibilità. Negli ultimi anni, l’evoluzione dell’informatica ha abbracciato paradig-

mi quali il cloud computing e il mobile, che hanno trasformato radicalmente le modalità di accesso e fruizione di applicazioni, risorse IT e dati. Così sono nati modelli di business innovativi, differenti abitudini di lavoro e anche nuovi sistemi economici. Oggi la sfida si sposta su una nuova frontiera: l’intelligenza artificiale consente di agire sull’informazione e sulla conoscenza in modi prima non ipotizzabili, se non in scenari distopici. I supercomputer (cioè i sistemi di calcolo ad alte prestazioni, High Performance Computing) e il quantum computing promettono di elevare esponenzialmente la capacità di calcolo delle infrastrutture informatiche, liberando nuova conoscenza e nuove possibilità dai dati stessi. Rispetto allo sviluppo di queste tecnologie emergenti, l’Europa e l’Italia stanno cercando un proprio ruolo, investendo nelle gigafactory dell’AI e in supercomputer. Realtà come Dama (il Tecnopolo Data Manifattura Emilia-Romagna di Bologna) e grandi aziende come Eni stanno investendo in questi ambiti, per abbracciare la nuova sfida quantistica e del supercalcolo.

Infrastrutture materiali e immateriali Affinché tutti gli elementi che ruotano oggi intorno al digitale – alimentandosene e alimentandolo – convergano verso l’obiettivo di una maggiore crescita e sostenibilità della società e dell’economia europea e italiana, occorrono strategie di governo e di sviluppo delle infrastrutture (materiali e immateriali) coerenti. Investire in connettività e in data center diventa un elemento di particolare attenzione, specie rispetto alla necessità di assicurare sempre più l’indipendenza e autonomia dei territori nel contesto digitale, con il dibattuto tema della sovranità tecnologica. In uno scenario in cui la connettività diventa ibrida, integrando nuove reti e player del satellitare, in cui i data center devono trovare il proprio ottimo in termini di sviluppo per evitare sprechi di suolo e di risorse energetiche e naturali, occorre realizzare coerentemente le infrastrutture immateriali pubbliche in grado di abilitare in modo sicuro la

crescita di un’economia digitale. Da un paio di anni si parla con sempre maggiore interesse delle cosiddette digital public infrastructure, che l’Undp, il Programma delle Nazioni Unite per lo Sviluppo, definisce come “un insieme di sistemi digitali condivisi, sicuri e interoperabili, che possono essere costruiti su standard aperti e promuovere l’accesso ai servizi per tutti”. In questo ambito l’Italia ha assunto, anche grazie al supporto dei fondi del PNRR, una posizione di rilievo sia per quanto riguarda lo sviluppo dell’identità digitale (con il sistema Spid e la Carta di Identità Elettronica) e i pagamenti digitali (pagoPA), sia in termini di interoperabilità e valorizzazione dei dati pubblici (con la Piattaforma Digitale Nazionale Dati e l’app IO). Occorre, tuttavia, far sì che tutti questi elementi continuino a svilupparsi lungo una direttrice comune: solo così il nostro Paese potrà prepararsi ad affrontare il futuro.

Camilla Bellini

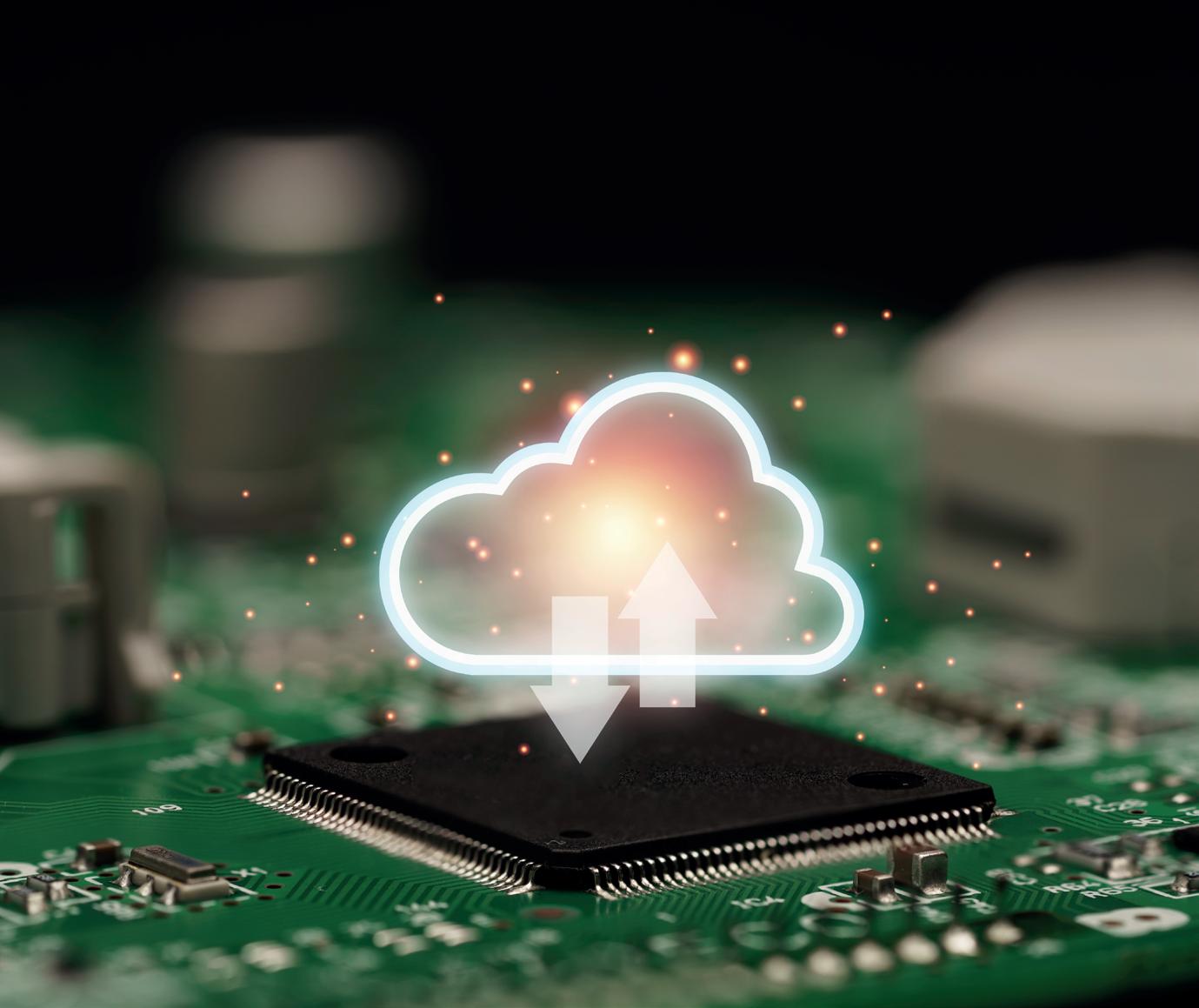

La domanda di servizi cloud per le aziende spinge il mercato italiano, mentre sorgono nuovi data center.

Una grande accelerazione: il mercato del cloud computing italiano sta vivendo una fase di questo tipo, che lo porta a distinguersi nel panorama europeo per la dinamicità, l’entità degli investimenti e il numero di nuovi data center. Nel 2024, secondo Banca d’Italia, oltre il 60% delle aziende italiane da almeno dieci dipendenti utilizzava servizi cloud: un dato che colloca il nostro Paese sopra la media europea con una differenza di circa 20 punti percentuali, in base a dati Eurostat. Rimaniamo, tuttavia, sotto le punte massime di Paesi nordici come Finlandia (78%), Svezia (72%), Norvegia

(71%) e Danimarca (70%). Le stime di TIG – The Innovation Group prefigurano una forte espansione di questo settore in Italia nei prossimi anni. Nel 2024 il mercato aveva raggiunto un valore di 8,3 miliardi di euro, con un incremento del 18% rispetto all’anno precedente, mentre per il 2025 si stima un valore di 9,6 miliardi di euro. Si prevede, poi, che il giro d’affari raggiungerà i 12,3 miliardi entro il 2027, con un tasso annuo composto di crescita nel periodo 2024-2027 superiore al 15%. La tendenza positiva riguarda tutte le componenti e in particolare il cloud infrastrutturale (Infrastructure as-aService; IaaS), oggi spinto anche dalla domanda di risorse performanti per gli sviluppi AI, e che si prevede smuoverà un giro d’affari di 7,6 miliardi di euro nel 2027. Il cloud applicativo (Software as-a-Service, SaaS) crescerà invece fino a un valore di 4,7 miliardi di euro nel 2027.

I motori della crescita

Le aziende adottano sempre più strategie multi-cloud e ibride (che integrano cloud pubblico, privato e sistemi legacy di differenti fornitori) per ridurre la dipendenza dal singolo provider, per mitigare i rischi e per massimizzare la flessibilità operativa. Le grandi imprese, in particolare, dimostrano un’elevata fiducia per il cloud: l’84% di esse ha “migrato” in toto o in parte i dati critici del core business, secondo l’Osservatorio Cloud Transformation del Politecnico di Milano. La robusta crescita del mercato nostrano è alimentata da una combinazione di fattori strategici e operativi. Da un lato, le imprese italiane riconoscono al cloud la capacità di aiutare a restare competitivi, grazie a infrastrutture sempre disponibili, all’automazione, alla rapidità con cui l’offerta dei provider introduce servizi innovativi come quelli legati al mondo dell’AI. Dall’altro lato, il cloud diventa indispensabile per supportare i nuovi sviluppi in area Big Data e

Il cloud computing è ancora una delle forze trainanti nel più ampio mercato dell’Ict italiano. Secondo i dati del report 2024 di Assintel-Confcommercio, realizzato in collaborazione con TIG – The Innovation Group e Istituto Ixé, la quota di piccole e medie imprese che nel 2024 avevano già adottato strutturalmente soluzioni cloud è pari al 68%. Gli utilizzi sono ampi e trasversali e in particolare il cloud è funzionale all’adozione dell’intelligenza artificiale (sia lo sviluppo di soluzioni customizzate tramite Platform as-a-Service, sia la semplice fruizione di Softwareas-a-Service) e alle attività di sviluppo, test ed esecuzione di applicazioni basate su architetture a microservizi. Secondo l’ultimo “Enterprise Cloud Index” di Nutanix (interviste condotte da Vanson Bourne nell’autunno del 2024 su 1.500 responsabili IT, di DevOps e platform engineering di aziende di diversa dimensione, settore e area geografica), il 71% delle aziende italiane necessita di modernizzare la propria infrastruttura IT per far funzionare meglio le applicazioni cloud-native.

intelligenza artificiale. La raccolta di Big Data, basata sulla consapevolezza del valore strategico delle informazioni nel contesto competitivo attuale, unita a un’adozione sempre più estesa di applicazioni basate su AI e strumenti analitici avanzati, sta facendo crescere la domanda di infrastrutture cloud capaci di gestire grandi volumi di dati e di garantire una potenza di calcolo elevata. L’AI è considerata per i prossimi anni il maggiore abilitatore di crescita del cloud in Italia.

A tutto ciò, come motori di crescita della domanda, si aggiungano gli incentivi e le iniziative legate a norme e regolamenti. Il Piano Nazionale di Ripresa e Resilienza (PNRR) stanzia fondi per la migrazione al cloud delle pubbliche amministrazioni, con l’obiettivo di modernizzare i servizi digitali e garantire maggiore sicurezza e affidabilità. Gli stanziamenti previsti, suddivisi tra due misure del piano (“Infrastrutture digitali” e “Abilitazione e facilitazione migrazione al cloud”) ammontano a 1,9 miliardi di euro e stanno spingendo nelle aziende l’adozione di soluzioni cloud. Sempre nell’ambito del Pnrr, 280 milioni di euro servono invece alla migrazione di dati e servizi degli enti pubblici verso il Polo Strategico Nazionale (Psn), con un avviso specifico per le Pubbliche amministrazioni centrali. A tutto ciò si aggiungono finanziamenti privati: Intesa Sanpao-

lo, UniCredit, Cassa Depositi e Prestiti, Banco Bpm e Bper, con il supporto della Banca Europea per gli Investimenti (Bei), hanno stanziato oltre 200 milioni di euro. Ulteriori risorse sono state stanziate per favorire la migrazione al cloud di tutti i Comuni italiani. Anche aspetti come sicurezza, conformità a vecchi e nuovi regolamenti (Gdpr, Nis2 e Dora) e sovranità dei dati, oggi cruciali per imprese e pubblica amministrazione, favoriscono la migrazione verso ambienti cloud qualificati e le partnership con fornitori di fiducia.

I data center dello Stivale

Nel biennio 2023-2024 gli investimenti in data center nel nostro Paese hanno superato i 5 miliardi di euro. La Italian Datacenter Association (Ida) ha affermato a inizio di quest’anno che diversi progetti sono già in fase di avvio, per un valore totale di 15 miliardi di euro, con termine dei lavori previsto entro il 2028. A settembre 2025, come riporta la DataCenterMap, l’Italia conta 204 infrastrutture di elaborazione dati da oltre 300 MW di potenza, posizionandosi come il quarto Paese europeo dopo Regno Unito, Germania e Francia, e prima di Paesi Bassi e Spagna. Milano e la Lombardia guidano il settore, con rispettivamente 74 e 85 data center, mentre nel Meridione spicca il ruolo della Puglia, favorita dalla disponibilità di rinnovabili e da una mag-

V.B.

giore presenza di società tecnologiche. L’espansione della domanda di servizi cloud in Italia sta avendo un impatto diretto e significativo sulla creazione di nuovi data center localizzati sul territorio nazionale. L’aumento della domanda, infatti, spinge sia i provider globali (come Amazon, Microsoft, Google, Equinix, Oracle e Vantage) sia quelli locali (come Aruba e Seeweb) a investire nella costruzione di nuove infrastrutture collocate materialmente in Italia.

Lo scorso ottobre, durante un incontro di Assolombarda, il ministro delle imprese e del made in Italy, Adolfo Urso, ha sottolineato l’importanza che il nostro Paese, in quanto membro del G7 posizionato nel Mediterraneo, potrà acquisire favorendo gli interscambi dell’economia digitale tra nazioni e continenti. Oltre alla spinta della domanda, ci sono fattori che rendono lo Stivale attrattivo per la realizzazione di nuovi data center: come la disponibilità di grandi aree industriali dismesse, i collegamenti ai cavi marittimi e alla dorsale terrestre e una fornitura affidabile di energia da fonti rinnovabili. La posizione geografica rafforza il ruolo dell’Italia come hub digitale nel Mediterraneo, anche grazie allo sviluppo di nuove dorsali e cavi sottomarini che la collegano ai mercati europei, al Medio Oriente e al Nordafrica. Elena Vaciago

Quanto e come saranno sostenibili nel lungo periodo, nel “post PNRR”, i progetti digitali avviati sul territorio?

Il 2026 sarà un anno importante per il processo di trasformazione digitale delle pubbliche amministrazioni italiane: con la chiusura del capitolo del Piano Nazionale di Ripresa e Resilienza e, di conseguenza, con l’esaurirsi dei fondi che hanno supportato molte iniziative digitali in ambito pubblico, gli enti si devono interrogare su come affrontare quello che viene spesso chiamato il “post PNRR”. Dovranno farlo per assicurare la sostenibilità anche nel medio-lungo periodo dei progetti intrapresi. Alcuni spunti di riflessione su come gli enti pubblici, in particolare quelli locali, si stanno apprestando alla sfida emergono dalla rilevazione annuale che TIG – The Innovation Group e Gruppo Maggioli conducono per monitorare il sentiment e lo sviluppo del digitale sul territorio italiano: quest’anno la nostra “Indagine sulla transizione digitale nella PA locale” – i cui risultati verranno presentati nel dettaglio a novembre all’interno della decima edizione del rapporto annuale “Digital Italy”, curato da TIG ed edito da

Maggioli Editore – si sofferma sul punto di vista di Comuni, Unioni di Comuni, Città Metropolitane e Province sul territorio italiano, attraverso le risposte (raccolte tra giugno e luglio di quest’anno) di 476 rappresentanti di in questi enti.

Un impatto innegabile

Dall’indagine emerge che l’impatto del PNRR sugli enti locali della Pubblica Amministrazione è un dato di fatto: se si considerano le aree in cui si sono concentrati i progetti nell’ultimo anno, il 66% degli intervistati dichiara di aver visto la propria organizzazione focalizzarsi su iniziative di adozione di piattaforme digitali pubbliche, come l’identità digitale, pagoPA, l’app IO o Send (Servizio Notifiche Digitali); il 63% sull’aggiornamento della propria infrastruttura e sulla migrazione al cloud; il 37% sull’integrazione di dati e servizi. Ambiti, dunque, che rientrano nell’area di intervento promossa tramite il PNRR.

Anche di fronte a domande dirette sul peso dei finanziamenti del Piano nelle

fasi di avvio e sviluppo di progetti digitali, il 90% degli intervistati sostiene abbiano avuto un ruolo importante o fondamentale. Inoltre, rispetto all’edizione dello scorso anno della stessa indagine, è cresciuta la percentuale di chi ritiene questi finanziamenti molto o estremamente efficaci per la trasformazione digitale del proprio ente: dal 30% al 35%. La categoria di chi li ritiene “estremamente efficaci” cresce in modo particolare, passando dal 5% al 9%. In sintesi, dunque, la maggior parte dei rispondenti rafforza la prospettiva sull’utilità ed efficacia di questi fondi per lo sviluppo di una Pubblica Amministrazione digitale.

Il nodo delle competenze

Se questa è l’opinione comune, e quindi si guarda positivamente al cammino intrapreso, d’altro canto solo un intervistato su quattro dichiara che il proprio ente si è già attivato per affrontare il tema della gestione post PNRR dei progetti digitali in essere; uno su cinque ammette di non stare affrontando il tema, mentre circa uno su due non è a conoscenza dei piani del proprio ente. È evidente, quindi, come questo argomento resti dibattuto e come ben lontano sia l’effettivo de-

I focus dei progetti digitali

Adozione piattaforme digitali pubbliche

Aggiornamento infrastruttura e migrazione cloud

Dematerializzazione

e servizi

TIG – The Innovation Group e Gruppo Maggioli, “Indagine sulla transizione digitale nella PA locale 2025”. Base: tutti i rispondenti (476). Risposta alla domanda: “Negli ultimi 12 mesi, in quali aree si sono concentrati i progetti digitali all’interno del suo Ente?”; possibili più risposte, primi cinque esposti.

Iniziative per la gestione post PNRR

CHI SI È ATTIVATO

Come il suo Ente si è attivato per affrontare la gestione post PNRR dei progetti digitali avviati?

Attivazione di programmi di formazione

Reperimento di risorse economiche alternative

Ripensamento e rivalutazione dei progetti

Creazione di un fondo interno per il mantenimento dei progetti

Sviluppo di modelli innovativi di sourcing

Stiamo cercando di capire come agire, ma ci sono azioni concrete

CHI NON SI È ATTIVATO O NON SA

Come il suo Ente dovrebbe attivarsi per affrontare la gestione post PNRR dei progetti digitali avviati?

TIG – The Innovation Group e Gruppo Maggioli, “Indagine sulla transizione digitale nella PA locale 2025”. Base: a sinistra, chi si è attivato (100), a destra, chi non si è attivato o non sa (288). Domande a risposta multipla.

linearsi di una exit strategy condivisa, di un piano di gestione oltre l’orizzonte del prossimo anno. Questa interpretazione è confermata anche da chi, in realtà, dichiara una qualche forma di attivazione: tra questi, uno su quattro si è già mosso in qualche modo, ma non ha ancora individuato azioni concrete per gestire questo aspetto. Quali possono essere, d’altra parte, gli strumenti e le iniziative per affrontare il “dopo PNRR”? Indubbiamente quella della formazione resta una

strada condivisa, sia tra i più consapevoli sia tra chi non si è attivato (o non sa). Il tema del post PNRR si innesta infatti su un dibattito – parimenti rilevante – che riguarda il futuro dell’impiego pubblico, delle sue numeriche e delle sue competenze, in particolare in ambito digitale: se da un lato verranno meno le risorse economiche che hanno permesso di fare anche maggiore affidamento su competenze esterne, come potranno strutture già in carenza di personale specializzato

gestire internamente le iniziative di trasformazione digitale? Per questo si vuole o si vorrebbe investire in formazione, per rafforzare le competenze interne necessarie per supportare e sviluppare ulteriormente le progettualità già avviate.

Tra ripensamenti e consapevolezza

Emerge però un punto di attenzione: tra i rispondenti che si sono attivati per gestire il PNRR, uno su cinque ammette di essere in fase di ripensamento o di rivalutazione dei progetti digitali in corso. Dunque il rischio di assistere a “passi indietro” nei percorsi di digitalizzazione degli enti locali esiste, benché in una quota limitata rispetto alle iniziative che proseguono in avanti, tese a rafforzare le competenze interne o a reperire risorse economiche alternative. Per gli intervistati, quindi, l’intervento del PNRR per il supporto a percorsi di trasformazione digitale all’interno degli enti locali ha avuto e sta avendo un ruolo rilevante ed efficace rispetto agli obiettivi posti. La preoccupazione rispetto alla gestione di queste iniziative e alla loro sostenibilità dopo il 2026 emerge però tra le righe, dove per lo più, consapevolmente o inconsapevolmente, si fa fatica a trovare una risposta comune per affrontare i prossimi anni. Quello che è certo è che occorrono competenze, e non è una sorpresa: con l’apprestarsi della chiusura di un capitolo significativo per la digitalizzazione degli enti locali, e con l’affacciarsi nel panorama digitale di tecnologie sempre più dirompenti e trasformative (si pensi all’intelligenza artificiale), diventa quanto mai rilevante promuovere lo sviluppo non solo di una cultura digitale, ma di competenze specialistiche in grado di valorizzarla al meglio. Solo così gli enti della Pubblica Amministrazione locale potranno restare attori attivi e consapevoli nei percorsi di digitalizzazione intrapresi.

Camilla Bellini

Schiacciata fra le tecnologie (e le regole) di Stati Uniti e Cina, l’Europa deve trovare una terza via.

C’è stato un momento in cui l’ottimismo regnava sovrano e si pensava che la Terra intera dovesse veleggiare verso lo sviluppo di una sola, grande comunità, magari ispirata al mondo fantascientifico di Star Trek, con un singolo governo a livello planetario e un’unica popolazione sparsa sui vari continenti. Purtroppo, le cose non sono andate così. Dopo il crollo del muro di Berlino, dall’enorme valore simbolico per l’abbattimento delle divisioni tra nazioni e popoli, l’ingresso della Cina nel WTO rievocò nelle menti di molti la scoperta delle Americhe: enormi praterie di mercati da sviluppare e trasformare in oro. In effetti, da quel lontano 2001 il valore del PIL del colosso asiatico è cresciuto enormemente, ma la sua integrazione è rimasta marginale.

Un commercio meno libero

La Cina ha usato la manodopera a basso costo per attirare capitali enormi, per decuplicare le proprie capacità e… iniziare a ripiegarsi su sé stessa. Già da diversi anni il Dragone ha dimostrato una poco ammirevole vocazione per la raccolta di proprietà intellettuali tramite mezzi poco leciti e nelle ultime settimane siamo arrivati a una chiusura molto spinta in diversi ambiti. Stati Uniti limitano il commercio di chip di ultima generazione e la Cina smette di comprare quelli (in primis, di Nvidia) dedicati all’AI perché ormai è sulla buona strada per raggiungere una sorta di autonomia nella produzione di acceleratori costruiti in casa (sempre ringraziando qualche “manina d’oro” che ha recuperato progetti e altri segreti che ne hanno accelerato lo sviluppo produt-

tivo). Dei ban più o meno incrociati nel settore delle telecomunicazioni si è detto fin troppo e, in generale, ormai si guarda con discreto sospetto qualsiasi prodotto cinese, sapendo che i dati conservati su questi dispositivi arriveranno “in qualche modo” fino alle orecchie del partito.

Il vantaggio statunitense

Per fortuna, l’occidente può contare sui vari Stati che da anni lavorano insieme come alleati, giusto? In realtà, già in passato questa alleanza non sembrava brillare, ma con l’arrivo di Donald Trump alla Casa Bianca la situazione è diventata davvero traballante. Gli Usa hanno sviluppato un vantaggio tecnologico in ambito informatico davvero molto forte (ne parliamo anche a pagina 15): i giganti del cloud sono tutti americani, così come i pochi grandi produttori di hardware informatico non cinesi, e anche le grandi software house di servizi software provengono dagli States. E

Come ridurre la dipendenza tecnologica nella cybersicurezza? Ovvero come scegliere fornitori e soluzioni informatiche in modo da limitare il più possibile problemi imprevedibili di supply chain (come interruzioni, dazi e rialzi di prezzi) e rischi di sicurezza (come il cyberspionaggio e l’ingerenza di governi esteri)? L’Europa e l’Italia hanno i mezzi tecnologici e, soprattutto, le infrastrutture necessarie per poter diventare più indipendenti? A queste e altre domande cercherà di rispondere la conferenza “Sovranità digitale e cybersecurity”, il primo evento di TIG–The Innovation Group specificamente dedicato a questo tema. Un tema, purtroppo, rimasto sottovalutato per anni ma su cui oggi, sempre più, le aziende devono confrontarsi, anche alla luce del contesto geopolitico ed economico internazionale. L’evento, in programma il 2 dicembre nella sede di Cefriel a Milano (in viale Sarca, 226), proporrà keynote, sessioni tematiche, panel con esperti e workshop pratici. Si parlerà di strategie per la sovranità digitale, delle normative europee in materia, dei pericoli legati all’intelligenza artificiale e alle catene di fornitura, ma anche di come dribblare il rischio di una eccessiva “chiusura tecnologica”.

sono tutte aziende sottoposte a un duro controllo dalla nuova amministrazione. Intendiamoci: le leggi americane hanno sempre previsto la possibilità di accedere ai dati in mano alle aziende statunitensi anche se in sedi all’estero. Ma l’audizione dello scorso luglio, davanti a una commissione del Senato francese, in cui un rappresentante di Microsoft dichiarava di non poter garantire la riservatezza dei dati europei, in quanto sarebbe obbligato a trasmetterli all’estero dietro richiesta della casa madre, ha fatto suonare molti campanelli d’allarme. Campanelli che, in realtà, erano silenti solo per chiara volontà di chi non voleva sentirli suonare dal momento che la legislazione statunitense in materia è sempre stata piuttosto chiara. Ma adesso c’è di più: c’è Trump. La nuova amministrazione, infatti, non si è mai fatta scrupolo di utilizzare mezzi coercitivi poco eleganti contro Stati alleati e non, trattandoli in modo molto simile. Gli esempi più lampanti sono quelli del-

le armi a sostegno di alcune zone “calde” del mondo. Abbiamo assistito a scene impensabili nei confronti dell’Ucraina e, recentemente, il governo statunitense si è rimangiato la parola su degli aiuti militari per Taiwan che erano già stati stanziati. Questo lungo preambolo serve a giungere a una domanda: se gli Usa hanno dimostrato di poter giocare a dadi con la sicurezza nazionale di Stati alleati, quanto tempo passerà prima di vederli usare la loro supremazia tecnologica per ottenere più vantaggi economici? Che cosa accadrà quando, nonostante tutte le rassicurazioni che i colossi americani stanno dando ai loro clienti, un ordine esecutivo li costringerà a triplicare i prezzi o sospendere i servizi? È uno scenario remoto? Certo, ma non più remoto di quanto, nelle nostre menti di europei, il pensare di assistere a un presidente americano che definisce un “affare immobiliare” un’operazione militare nella Striscia di Gaza.

La sovranità necessaria

Così si arriva alla necessità della sovranità tecnologica: una serie di iniziative che raccontano quanta poca fiducia sia rimasta nella globalizzazione. Trump non sarà rieletto, ma le cose sono ormai cambiate per sempre: l’Europa deve trovare un modo tutto suo di sviluppare tecnologia ed è indietro. Molto indietro. Le prime cose da fare sono capire in che direzione andare; quali eccellenze abbiamo già e quali mancano; quante aziende sanno già di dover iniziare a pensare di staccare il cordone che li lega a tecnologie in mano a determinati Paesi e quante non riescono a vedere come potrebbero farlo. C’è il nodo della produzione dei dispositivi, della scrittura del software, delle infrastrutture fisiche. C’è così tanto da fare che non sarebbe sbagliato definire la sovranità digitale europea come una completa rivoluzione. Abbiamo il tempo e la forza per metterla in atto? Bisogna iniziare... per capire dove si può arrivare. Giancarlo Calzetta

Il settore fieristico attraversa una non fase critica: questa edizione di Ifa, a Berlino, ne è emblema.

L’Ifa, Internationale Funkausstellung Berlin, è sicuramente la fiera di elettronica di consumo più importante dell’anno a livello europeo. Come tutte le manifestazioni di questo tipo, però, sta soffrendo il cambiamento indotto dalla voglia dei vendor di comunicare direttamente con il proprio pubblico, consumer o B2B che sia. I numeri sono in decrescita, i grandi nomi dell’informatica praticamente non ci sono più e quelli dell’elettronica di consumo presenziano senza portare grandi novità. Basti pensare a Samsung: ha ancora il suo padiglione dedicato (il “City Cube”) all’ingresso Sud della fiera, ma ha fatto praticamente tutti gli annunci di prodotto prima dell’inizio della manifestazione, lasciando solo un tablet e uno smartphone per il giorno precedente e riservando quasi tutto il keynote alle novità dell’ecosistema di intelligenza artificiale. Lg, invece, ha addirittura portato una rappresentanza risicata di televisori, dedicando il grosso dello stand al “bianco” e, anche loro, all’ecosistema. Insomma, quella che una volta era la fiera dei televisori, oggi è qualcosa di molto diverso. Un evento molto incentrato sull’elettrodomestico bianco, dove la tecnologia galoppa rispetto al passato, ma ha un appeal decisamente minore. Passeggiando tra gli stand, si vedono praterie di dispositivi indossabili, asciugacapelli, accessori per cellulari, smartphone e tablet dai marchi sconosciuti e un

generale appiattimento dell’offerto. Eppure, Ifa è cresciuta rispetto allo scorso anno. Com’è possibile? Per quanto possa suonare strano, bisogna ringraziare i dazi di Trump, che hanno spinto i marchi cinesi a riversarsi in massa verso un mercato che adesso vedono come molto più promettente rispetto a quello statunitense. Il numero di espositori provenienti dal Paese del dragone è quasi raddoppiato rispetto all’edizione precedente, passando dai circa 400 del 2024 agli oltre 700 di Ifa 2025. Una valanga di marchi dai nomi stranamente familiari che risuonano nella nostra testa, finché non realizziamo di averli già letti mille volte tra quelli proposti su Amazon. Aziende che stavano già presidiando in maniera secondaria il nostro mercato tramite le vendite online

e che adesso si preparano a sbarcare in grande stile. Alla luce della situazione vista a Ifa, l’offerta avanzata da JD.com per acquistare il detentore dei marchi Mediaworld, Media Market e Saturn, assume una luce ben più articolata. Le tre catene, infatti, potrebbero diventare il veicolo ideale per tutta la tecnologia per la casa in arrivo dalla Cina. La qualità dell’offerta sta crescendo molto rapidamente: scope elettriche, robot lavapavimenti, telecamere, tagliaerba, frigoriferi, forni e i mille altri piccoli dispositivi per le faccende domestiche stanno diventando sempre più intelligenti e connessi, e sempre più cinesi. Non è chiaro quanta dell’offerta rispetti le normative europee per la protezione dei dati e della privacy, ma quello, oggi, è un dettaglio. Il vero nodo è che la Cina sta per lanciare una nuova “offensiva commerciale” e stavolta non sarà basata solo sul prezzo, ma anche sulla qualità dei prodotti. Come reagirà l’Europa davanti a questa nuova invasione? Reagirà? Si inizia a parlare di produzione che dev’essere portata di nuovo “in casa”, ma non è troppo tardi? Siamo rimasti indietro con le fabbriche, certo, ma anche con il know-how che sta dietro a progettazione, materiali, hardware e software. Abbiamo la forza per scuoterci? Domande pesanti, che è strano siano nate passeggiando nei corridoi di quella che era la vetrina della tecnologia made in Europe. Giancarlo Calzetta

Gli hyperscaler statunitensi dominano il mercato Ue, ma il market share dei fornitori europei negli ultimi anni non è sceso.

Il mercato europeo del cloud computing è molto statunitense. Ovvero le aziende, le pubbliche amministrazioni e i cittadini del Vecchio Continente utilizzano in larga parte i servizi di infrastruttura, di piattaforma e applicativi dei fornitori nordamericani, in particolare Amazon (con la divisione Aws), Microsoft e Google. D’altra parte questi hyperscaler, cioè proprietari di data center “giganti” (con almeno cinquemila server, in base alla tassonomia di Fortune Business Insight), negli ultimi anni hanno investito pesantemente per dotarsi di nuove infrastrutture collocate in Europa. Infrastrutture da cui poter erogare servizi “locali”, che non prevedono trasferimenti di dati negli Stati Uniti.

Big Tech ingombranti

Sommati fra loro, Aws, Microsoft e Google detengono sul mercato europeo una quota di circa il 70% a valore, stando agli ultimi dati di Synergy Research Group. Ci sono poi, a comporre il quintetto, altri due colossi meno “generalisti” e più foca-

lizzati su specifiche aree di attività, ovvero Ibm e Oracle, quest’ultima in particolare protagonista di una fase di forte crescita. “Il mercato del cloud”, ha commentato John Dinsdale, chief analyst di Synergy Research Group, “è un gioco di scala, in cui aspiranti leader devono fare enormi scommesse finanziarie, devono avere una visione di lungo termine su investimenti e profittabilità, devono conservare una determinazione focalizzata e raggiungere costantemente l’eccellenza operativa. Nessuna società europea si è avvicinata a questa serie di criteri e il risultato è un mercato in cui i cinque grandi leader sono tutti statunitensi”.

Un’impresa quasi impossibile

Gli operatori europei come Sap, Deutsche Telekom, Ovhcloud, Telecom Italia e Orange (oltre a una lunga serie di player nazionali e locali) si stanno difendendo come possono, puntando sui legami con il territorio e su vantaggi di sovranità e controllo sul dato.

Tra il 2017 e il 2024 il loro giro d’affari è triplicato, ma nel frattempo il mercato europeo del cloud computing è cresciuto il doppio (risulta, cioè, moltiplicato per sei volte). Il risultato è che il market share dei fornitori cloud europei in territorio Ue è sceso dal 29% del 2017 al 15% del 2022, quota rimasta poi comunque stabile fino a oggi. In testa alla classifica ci

sono Sap e Deutsche Telekom, ciascuno con un market share a valore pari al 2%. Il fatto è che gli hyperscaler investono fino a dieci miliardi di dollari a trimestre per il potenziamento dei propri data center e della relativa offerta di servizi. Livelli di spesa inarrivabili per gli operatori cloud europei, che si trovano davanti “una montagna impossibile da scalare”, come scrive Dinsdale. “Di conseguenza, i fornitori cloud europei per lo più si sono posizionati nel servire gruppi di clientela locale con necessità specifiche, lavorando a volte come partner per i grandi provider statunitensi. Molti operatori cloud europei continueranno a crescere, ma è improbabile che riescano a spostare di molto l’ago della bilancia in termini di market share nel contesto europeo generale”.

Opportunità crescenti

Il mercato del cloud è comunque un terreno fertile, che permetterà un po’ a tutti i fornitori di germogliare. Considerando le componenti infrastrutturali, di piattaforma e i servizi di cloud privato, Synergy stima per i soli primi sei mesi del 2025 un giro d’affari di 36 miliardi di euro. La previsione per l’intero anno è di una crescita del 24% sul 2024, spinta soprattutto dai servizi legati all’intelligenza artificiale.

Valentina Bernocco

La crescita del traffico, le Big Tech, l’AI, la geopolitica: il punto di vista di Namex sull’evoluzione e sul futuro di Internet.

Non è una rete ma la Rete, con l’articolo determinativo e l’iniziale maiuscola. Internet negli anni è diventata un’infrastruttura critica su cui si reggono grandi porzioni dell’economia e della società moderna. E oggi è anche al centro della contesa geopolitica. Come è cambiata Internet negli anni? L’Europa e l’Italia hanno voce in capitolo? Ne abbiamo parlato con Maurizio Goretti, direttore generale di Namex (NAutilus MEditerranean eXchange point), il più importante nodo di interscambio del Centro-sud Italia.

Che aspetto ha la Internet odierna?

Internet è diventata un’infrastruttura critica quanto la rete elettrica, lo abbiamo visto durante il blackout spagnolo di alcuni mesi fa, quando l’assenza di connettività ha destato più preoccupazione dei frigoriferi spenti. Il traffico dati è cresciuto esponenzialmente negli ultimi anni: l’Osservatorio Namex ha registrato un aumento del 300% nei picchi di traffico dall’inizio della pandemia oggi. Nel frattempo l’architettura della rete sta cambiando radicalmente. I colossi tech di oltreoceano, come Meta, Google, Microsoft e Amazon, non si accontentano più di utilizzare le infrastrutture esistenti: stanno costruendo le proprie reti private, dai data center ai cavi sottomarini. Questa verticalizzazione concentra non solo i servizi, ma anche i punti ne-

vralgici dell’interconnessione globale. La risposta del settore è ancora tutta da capire. La buona notizia è che in Europa la rete in fibra ottica è molto più capillare che altrove e decisamente plurale. In Italia, come nella maggior parte dell’Unione Europea, la presenza di collegamenti ridondanti tra operatori ha creato una rete resiliente che può assorbire il guasto di singoli nodi senza che se ne accorga l’utente finale. In questo i punti di interscambio hanno assunto un ruolo fondamentale, nell’assicurare resilienza, efficienza ed economicità a una rete sempre più complessa.

Quali dinamiche stanno influenzando il presente e il futuro di Internet?

Le infrastrutture digitali sono diventate terreno di competizione geopolitica e, sempre più spesso purtroppo, obiettivi militari. Da un lato assistiamo a una corsa globale per connettere ogni angolo del pianeta, dalle nuove dorsali oceaniche alle costellazioni satellitari che garantiscono connettività anche in luoghi impensabili, come il mare aperto o le cime alpine. Dall’altro, i cavi sottomarini e, per ora in misura minore, i satelliti si rivelano obiettivi sensibili nelle guerre ibride contemporanee. Sul piano economico, il dominio è quasi esclusivamente americano e cinese, con rare eccezioni europee nel panorama dei contenuti digitali. Questo squilibrio spinge l’Unione Europea a interrogarsi su

normative per tutelare concorrenza e utenti, alimentando dibattiti sempre più accesi sulla sovranità tecnologica. La complessità sta nel definire confini in un ecosistema, Internet, che è nato senza confini. L’accelerazione nell’adozione dell’intelligenza artificiale, in particolare dei Large Language Model, e il dispiegamento delle reti satellitari stanno ridefinendo completamente le esigenze di connettività, ponendo sfide inedite di governance e sostenibilità ambientale.

E il settore dei cavi sottomarini, che fase sta attraversando?

Il settore dei cavi sottomarini vive una trasformazione senza precedenti. Negli ultimi anni stiamo assistendo a un veloce cambiamento: aziende di Maurizio Goretti

servizi come Meta, Google, Microsoft e Amazon investono in infrastrutture complesse, posando cavi sottomarini fino a realizzare reti proprietarie che attraversano gli oceani e fanno il giro del mondo. In Europa i cavi sono tradizionalmente di proprietà di consorzi di imprese e collegano il continente ad Africa, Medio ed Estremo Oriente. La priorità oggi è creare rotte alternative ai colli di bottiglia strategici. Il progetto Blue & Raman, ad esempio, evita il passaggio attraverso l’Egitto, dove si concentra gran parte del traffico mondiale e che rappresenta un potenziale tallone d’Achille. Gli incidenti recenti nel Mar Baltico, ma anche le sole minacce, hanno evidenziato la criticità di queste infrastrutture. È essenziale diversificare i percorsi e rafforzare la cooperazione internazionale per proteggerli. Le buone notizie sono che l’Italia può avere un ruolo da protagonista, vista la posizione geografica e il know-how di aziende come Sparkle, Retelit e ora anche Unitirreno, la quale sta terminando un cavo che collega la Sicilia con Genova passando per Fiumicino e Olbia.

Internet reggerà l’urto dell’intelligenza artificiale, così come ha retto (finora) l’impatto del boom dei dati? Il volume dei dati in transito, cioè del traffico Internet, è letteralmente esploso, ma possiamo serenamente affermare che finora la rete ha retto grazie ai continui potenziamenti delle infrastrutture. Dal punto di vista tecnico, Internet potrà sostenere l’urto dell’AI solo evolvendo verso l’edge computing: i nuovi flussi generati dall’AI dovranno spostarsi ai margini della rete, portando capacità di calcolo e nodi di scambio più vicini agli utenti finali. Sul fronte energetico,

la questione è ancora più complessa. I data center dedicati all’AI consumano quantità enormi di energia, tant’è che negli Stati Uniti si stanno riattivando centrali nucleari dismesse. Senza un’adeguata pianificazione delle infrastrutture energetiche e di rete rischiamo di creare “scatole vuote”, strutture di dimensioni e costi significativi, ma poco funzionali. In Italia e in Europa la sfida è anche un’altra. Non esistono i soli Large Language Model generalisti, ma c’è un settore in rapida ascesa che è quello dei modelli di AI verticali, specializzati in un particolare contesto e studiati per servire contemporaneamente un numero di utenti limitato. I data center che li ospitano possono essere concepiti diversamente da quelli di OpenAI o Google, avendo dimensioni e consumi decisamente inferiori.

Che aspirazioni, realisticamente, può nutrire l’Europa nella corsa all’intelligenza artificiale?

Nel campo dell’AI e dei data center, la leadership resta saldamente americana, mentre la Cina si conferma sempre di più come un credibile concorrente al vertice. Tuttavia, l’Europa ha ancora carte da giocare se i Paesi Ue uniranno le forze. Una strategia coordinata – dall’armonizzazione delle

rotte dei cavi sottomarini agli investimenti in ricerca – potrebbe trasformare ogni nazione da spettatore passivo ad attore protagonista, scegliendo quale AI vogliamo per il nostro presente e per i nostri figli. Il nostro continente non parte da zero: la ricerca europea contribuisce significativamente all’innovazione mondiale, ma manca la capacità di scalare a una competitività globale nell’industria dei contenuti. È qui che si gioca la partita: definendo regole condivise e investimenti strategici, l’Europa può ancora ritagliarsi un ruolo centrale in quella che sarà una rivoluzione epocale per la nostra quotidianità.

Avete celebrato i trent’anni di Nap Roma, l’Internet Exchange Point della Capitale. Come si posiziona oggi Roma nello scenario dell’interconnessione?

Per anni Milano è stata l’unico vero polo digitale italiano, mentre Roma rimaneva ai margini. Oggi questa concentrazione non è più ottimale e le esigenze di connessione dell’intera popolazione italiana sono diverse: serve distribuire data center, nodi di rete e interconnessione in generale su tutto il territorio nazionale. Oggi il traffico Internet dell’Urbe è quasi la metà di quello di Milano, mentre fino a pochi anni fa era meno di un quinto. Roma sta emergendo come hub complementare, che affianca Milano rafforzando la posizione dell’Italia come snodo strategico del Mediterraneo. Namex ha creduto in questa visione policentrica fin dalla sua fondazione, trent’anni fa: nati a Roma per servire il Centro-sud, abbiamo aperto un Ixp a Bari e uno a Napoli per portare connettività di qualità alle comunità locali. V.B.

Valutare le relazioni fra elementi umani e tecnologie, dribblando la tentazione di ottimizzare solo, è cruciale. L’opinione di Covisian.

Il servizio clienti e la più ampia area della customer experience sono ambiti in cui l’AI ha attecchito da tempo, da prima che si parlasse di chatbot basati su Large Language Model. Ma è ancora facile commettere errori, sia tecnici sia strategici. Per esempio, si potrebbe cadere nella “trappola della pura ottimizzazione dei processi”, come l’ha definita discutendo sul tema Fabio Sattolo, chief people and technology officer di Covisian

A che punto siamo con l’adozione di tecnologie di AI per il servizio clienti?

Settori come utilities, telco e servizi finanziari hanno avviato l’adozione dell’AI già da diversi anni, spesso con un focus iniziale sulla riduzione dei costi e sull’automazione massiva. Oggi, però, stanno rivedendo profondamente il modo in cui utilizzano queste tecnologie, spostando l’attenzione dall'automazione fine a sé stessa a modelli più integrati e collaborativi tra AI e persone. L’obiettivo è migliorare non solo l’efficienza, ma soprattutto l’esperienza complessiva del cliente, rendendola più fluida, personalizzata e umana, anche nei contesti digitali. Paradossalmente, i settori che hanno adottato l’AI più lentamente – come retail, sanità o Pubblica Amministrazione – si trovano oggi in una posizione potenzialmente vantaggiosa. Non devono “disimparare” o superare modelli ormai obsoleti, ma possono partire direttamente con un

approccio ibrido, in cui AI e operatore umano collaborano in modo sinergico, ciascuno valorizzando le proprie capacità distintive: velocità, precisione e disponibilità nel caso dell’AI; empatia, giudizio e gestione della complessità per l’essere umano.

Quali sono le criticità da considerare in un progetto di adozione dell’AI nel customer care?

Nel nostro lavoro con Smile.CX vediamo chiaramente che la vera innovazione oggi non è solo nell’adozione dell’AI, ma nel disegno intelligente delle interazioni, nella capacità di orchestrare tecnologie e persone per offrire esperienze che siano davvero centrate sul cliente. E questo è un terreno su cui anche le aziende meno “digitalizzate” possono giocare un

ruolo da protagoniste, se guidate da una visione chiara.

Una delle sfide principali, quando si parla di AI nel customer care, è non cadere nella trappola della pura ottimizzazione dei processi. L’obiettivo non è sostituire l’interazione umana, ma trovare il giusto equilibrio: calibrare l’intelligenza artificiale affinché porti un valore reale, mantenendo una relazione con il cliente che resti autentica ed empatica. Noi la consideriamo un abilitatore intelligente, che potenzia le competenze dell’operatore e lo libera dalle attività più ripetitive, senza mai togliergli quel ruolo centrale dove empatia e comprensione fanno la differenza.

Un altro aspetto cruciale riguarda la gestione della knowledge base e dei dati aziendali, che devono essere accurati, costantemente aggiornati e progettati per alimentare in modo efficace i modelli di AI. Senza una knowledge base solida e un’architettura dei dati coerente, anche gli algoritmi più avanzati non possono garantire risposte davvero pertinenti e di valore. Proprio per questo i nostri modelli sono auto-alimentati e imparano continuamente sul campo, evolvendo grazie alla supervisione umana che li guida, corregge e affina.

C’è poi il tema dell’integrazione con i sistemi del cliente, che spesso in alcuni mercati risulta delicata e complessa per motivi di compliance. Non si tratta di una resistenza al cambiamento,

ma di una sfida tecnica e organizzativa. Oggi siamo posizionati con successo in settori tra i più rigidi, come il finance e l’healthcare, e questa è una sfida che stiamo cavalcando con determinazione. L’integrazione intelligente tra AI e l’ecosistema del cliente – Crm, Erp, piattaforme di ticketing – permette ottimizzazioni molto più funzionali e una customer experience più fluida. Grazie alle API in lettura e scrittura, l’AI non si limita a fornire risposte, ma può mantenere aggiornati i sistemi del cliente, automatizzare processi, aggiornare dati e togliere agli operatori gran parte delle attività di back office, permettendo loro di concentrarsi su ciò che porta vero valore.

Un tema molto dibattuto riguarda il rapporto fra elementi “umani” e artificiali. Come trovare un giusto equilibrio?

Non crediamo in un’automazione totale: la vera forza sta nell’equilibrio tra automazione e competenza umana, dove l’AI accelera i processi e fornisce insight, mentre l’operatore interviene nei momenti chiave per offrire personalizzazione, empatia e comprensione che nessuna macchina può replicare. L’adozione della tecnologia deve essere accompagnata da una strategia ben definita e orientata al cliente, combinando automazione e competenza umana. Il giusto equilibrio si raggiunge attraverso un’integrazione sinergica: l’AI come supporto agli operatori, capace di migliorare l’efficienza aziendale senza sacrificare, anzi potenziando, la qualità della customer experience. Questo approccio human-to-human, potenziato dall’AI, consente di automatizzare le attività ripetitive e garantire risposte rapide, lasciando agli operatori il compito di

intervenire nei momenti chiave, offrendo personalizzazione ed empatia. Si risolve così non soltanto il problema delle attese, ma anche il senso di frustrazione che gli utenti possono provare di fronte all’interazione con macchine non realmente in grado di comprendere le loro richieste. In questo modo, gli addetti al contact center si trasformano in veri e propri professionisti della customer experience, in grado di orchestrare tecnologie avanzate per offrire un servizio sempre più efficace, umano e soddisfacente. Questo porterà alla nascita del settore CxTech, in cui ogni interazione diventa un’opportunità di dialogo e fidelizzazione.

Ci fa qualche esempio di casi d’uso concreti?

Abbiamo detto che una sfida chiave è capire quando l’AI deve fare un passo indietro. In un’emergenza, come il blocco di una carta di credito dopo una frode, il cliente non cerca solo velocità ma rassicurazione. In quei momenti, una voce sintetica – per quanto naturale – rischierebbe di aumentare lo stress. Per questo l’operatore resta in prima linea, mentre l’AI lavora dietro le quinte: prepara i dati, velocizza le procedure e riduce i tempi di intervento, ma lascia all’umano il compito di dare empatia e sicurezza. Un’altra sfida è quella della compliance, soprattutto nel mondo sanitario,

dove la gestione dei dati sensibili richiede standard altissimi di sicurezza e tracciabilità. Con progetti come Smiling Cup e Centralino Sanitario, abbiamo affrontato questo tema integrando l’AI con i sistemi regionali, ma sempre con controlli rigorosi su privacy e governance. In questi casi, l’AI automatizza la prenotazione o lo smistamento delle chiamate, mentre la supervisione umana assicura che ogni interazione resti conforme alle normative e personalizzata sulle esigenze del paziente.

A quali evoluzioni tecnologiche guardate con maggiore interesse?

L’Agentic AI rappresenta sicuramente una frontiera molto promettente: sistemi in grado di pianificare, decidere e agire in modo autonomo sulla base di obiettivi, contesto e feedback. È un passo avanti rispetto ai classici modelli predittivi o conversazionali, ma proprio per questo la sua adozione richiede una profonda riflessione sul ruolo della supervisione umana. Noi crediamo che l’Agentic AI sia un’evoluzione naturale, ma non lineare né automatica. Il suo vero potenziale emerge quando è inserita all’interno di modelli ibridi, dove l’essere umano resta al centro: come supervisore, come escalation point, ma anche come risorsa che contribuisce attivamente all’apprendimento e all’ottimizzazione del sistema. Le tecnologie che più ci interessano, quindi, sono quelle che abilitano questa collaborazione fluida tra AI e persone: orchestratori intelligenti dei flussi conversazionali, interfacce adattive che consentano all’operatore di intervenire quando necessario, e strumenti di explainability e di monitoraggio in tempo reale. V.B.

Le scelte di approvvigionamento possono costruire relazioni e resilienza nelle aziende.

Spesso si pensa al procurement come a una funzione tecnica, legata solo a numeri, contratti e fornitori: in realtà è uno snodo strategico, che può accelerare la trasformazione completa di un’azienda. In un mondo in cui la volatilità è la nuova normalità – tra crisi geopolitiche, instabilità delle catene di fornitura, transizione green e rivoluzione tecnologica – chi si occupa di acquisti ha un ruolo chiave nel disegnare il futuro. Non si tratta solo di comprare, ma di costruire relazioni, attivare cambiamenti e generare impatti concreti su ogni area dell’impresa. Il procurement è quel tassello essenziale che tiene insieme efficienza e visione, contribuendo a trasformare il modo stesso in cui un’azienda crea valore e si prepara al domani. Oggi il procurement è chiamato in causa non solo per ottimizzare costi o gestire fornitori, ma per rendere la supply chain più efficiente, solida, flessibile e strategica. Per affrontare questo percorso servono nuove competenze, il coraggio di sperimentare approcci innovativi e la capacità di costruire relazioni di partnership autentiche e durature. Le aziende che lo comprendono stanno già investendo su competenze trasversali, soluzioni digitali e partnership solide, consapevoli che il vero vantaggio competitivo si costruisce lungo tutta la supply chain. I nostri numeri parlano chiaro: la funzione acquisti sta abbandonando la vecchia etichetta di semplice “controllore dei costi”. Solo un’azienda su quattro continua a inter-

pretare gli acquisti in modo tradizionale, limitandosi alla gestione di ordini e budget. Il 33%, invece, riconosce negli acquisti un motore strategico capace di introdurre nuove competenze, strumenti e processi innovativi.

Tra vantaggio economico e resilienza Per troppo tempo il ruolo degli acquisti è stato confinato a una semplice gara alla contrattazione. Oggi il procurement moderno gioca su un campo molto più ampio e strategico per generare valore su più livelli, visibili e invisibili. Pensiamo al valore economico: il risparmio non si esaurisce nel prezzo d’acquisto, ma si costruisce guardando all’intero ciclo di vita di beni e servizi. Con un approccio più ampio e lungimirante orientato al Total Cost of Ownership, si considerano aspetti come manutenzione, durata, efficienza e smaltimento. È qui che nascono il vero vantaggio economico e la sostenibilità di lungo periodo. Ma c’è di più, il procurement è anche uno scudo contro i rischi di mer-

cato. Oscillazioni dei prezzi delle materie prime, interruzioni nelle forniture, crisi globali sono eventi che è possibile gestire se si adottano scelte strategiche, si analizzano i mercati e si costruiscono partnership solide. Il procurement moderno non può più essere una funzione a sé stante, deve muoversi al passo con gli obiettivi strategici dell’impresa. Dalla selezione di fornitori locali per sostenere l’espansione internazionale, alla creazione di partnership che garantiscono compliance e innovazione: chi si occupa di acquisti oggi è protagonista nel guidare la crescita.

Innovazione e identità aziendale Dal procurement passa gran parte dell’innovazione. Se coltiviamo relazioni di fiducia con i fornitori, questi diventano una fonte preziosa di idee, tecnologie e materiali in grado di migliorare prodotti, processi e competitività. Dallo sviluppo congiunto di soluzioni alla scelta di materiali innovativi, il procurement è il punto d’accesso privilegiato al cambiamento. Infine, ogni acquisto racconta qualcosa dell’identità aziendale. Il procurement responsabile riduce l’impatto ambientale, promuove pratiche etiche nella filiera e risponde alle crescenti aspettative di trasparenza e sostenibilità privilegiando fornitori che operano con criteri green. Al contempo, attraverso pratiche etiche, il procurement contribuisce a garantire condizioni di lavoro dignitose, sicurezza e diritti in tutta la filiera. Non è solo un obbligo, ma una leva reputazionale. Un procurement trasparente, innovativo e sostenibile rafforza la credibilità, alimenta il brand e prepara l’azienda alle sfide future. Il valore che può generare è trasversale, concreto e strategico. Andrea Tinti, Ceo e founder di Iungo

La filosofia di Archiva Group, che dalla gestione documentale si estende fino all’AI. Al centro, il valore dei dati.

Archiva Group nasce per custodire dati e documenti preziosi per i propri clienti. In 25 anni di presenza sul mercato, tale obiettivo è rimasto nel DNA di un gruppo che nel tempo, però, è cresciuto molto e ha ampliato il proprio spettro di azione, dalla gestione documentale ad altre tecnologie che regolano processi aziendali come la fatturazione e la compliance. Recentemente tramite Progressio Investimenti IV, il fondo di private equity che controlla Archiva, è stata acquisita Mitric, una software house che ha sviluppato un’offerta di app dedicate a processi core, come controllo qualità, gestione della logistica, qualifica dei fornitori e gestione della supply chain. A questa acquisizione è seguita quella di Ddm Technology, società padovana che propone una soluzione di gestione documentale integrata nell’ambiente Sap.

“Stiamo vivendo anni di grande crescita ma ci tengo a fare chiarezza su un concetto”, esordisce Loris Marchiori, corporate communication director di Archiva Group. “C’è una differenza tra digital transformation e digital transition. Trasformazione è quando l’azienda decide di cambiare il proprio modello di business attraverso il digitale, mentre percorrere la transizione digitale significa cambiare modalità operative e sfruttare le tecnologie per ottenere un vantaggio competitivo o per adeguarsi a fattori esogeni, come nuove leggi e regolamenti. Archiva affianca i propri clienti prevalentemente

in quest’ultimo processo”. Tra i cam biamenti normativi di maggiore im patto sulle aziende, l’obbligo di fattu razione elettronica è particolarmente significativo, considerato che il nostro Paese ne è stato (insieme al Portogallo) tra i principali promotori. Altra tematica “esogena”, spiega Mar chiori, è la creazione di uno spazio unico doganale, dove poter gestire il flusso informativo e informatico dell’import-export. “Su questo tema ci siamo posizionati con soluzioni di automazione per interagire con l’agen zia delle dogane”, racconta. Un terzo “fattore esogeno” a cui le aziende devono adeguarsi è l’evoluzione tecnologica: anche in questo caso Archiva si propone come alleato che aiuta a recepire concretamente il cambiamento.

Un approccio pragmatico

Con la propria suite di applicazioni per la gestione dei processi, la collaborazione e l’archiviazione digitale, Requiro, Archiva supporta diversi dipartimenti aziendali, come quello amministrativo-finanziario, l’area acquisti e gestione dei fornitori, le vendite, le risorse umane e anche le attività legal e la compliance. Può trattarsi di processi estesi, complessi e internazionali, ma il target non è necessariamente la grande azienda.

“Lavoriamo nei processi di supporto, che in una media azienda farmaceutica, per fare un esempio, possono essere molto più numerosi rispetto a

ciale”, fa notare Marchiori. Archiva promuove un approccio pragmatico all’innovazione tecnologica, e l’ambito dell’intelligenza artificiale non fa eccezione. Recentemente in Requiro sono state integrate tecnologie di machine learning e Large Language Model per poter trattare dati di vario tipo (strutturati, semistrutturati, non strutturati) e per automatizzare attività come il controllo di documenti di trasporto e fatture.

L’AI può anche combinarsi con l’automazione robotica di processo, che da sempre fa parte della piattaforma di Archiva. “In un contesto di innovazione velocissima, abbiamo scelto di non sviluppare prodotti di AI frontend, ma di usare questa tecnologia per aiutare i clienti a mettere a frutto i propri dati”, spiega Marchiori.

“Le aziende non sfruttano il 70% del proprio patrimonio informativo. L’AI aiuta a far leva sui dati, ne accelera la fruibilità”. E.M.

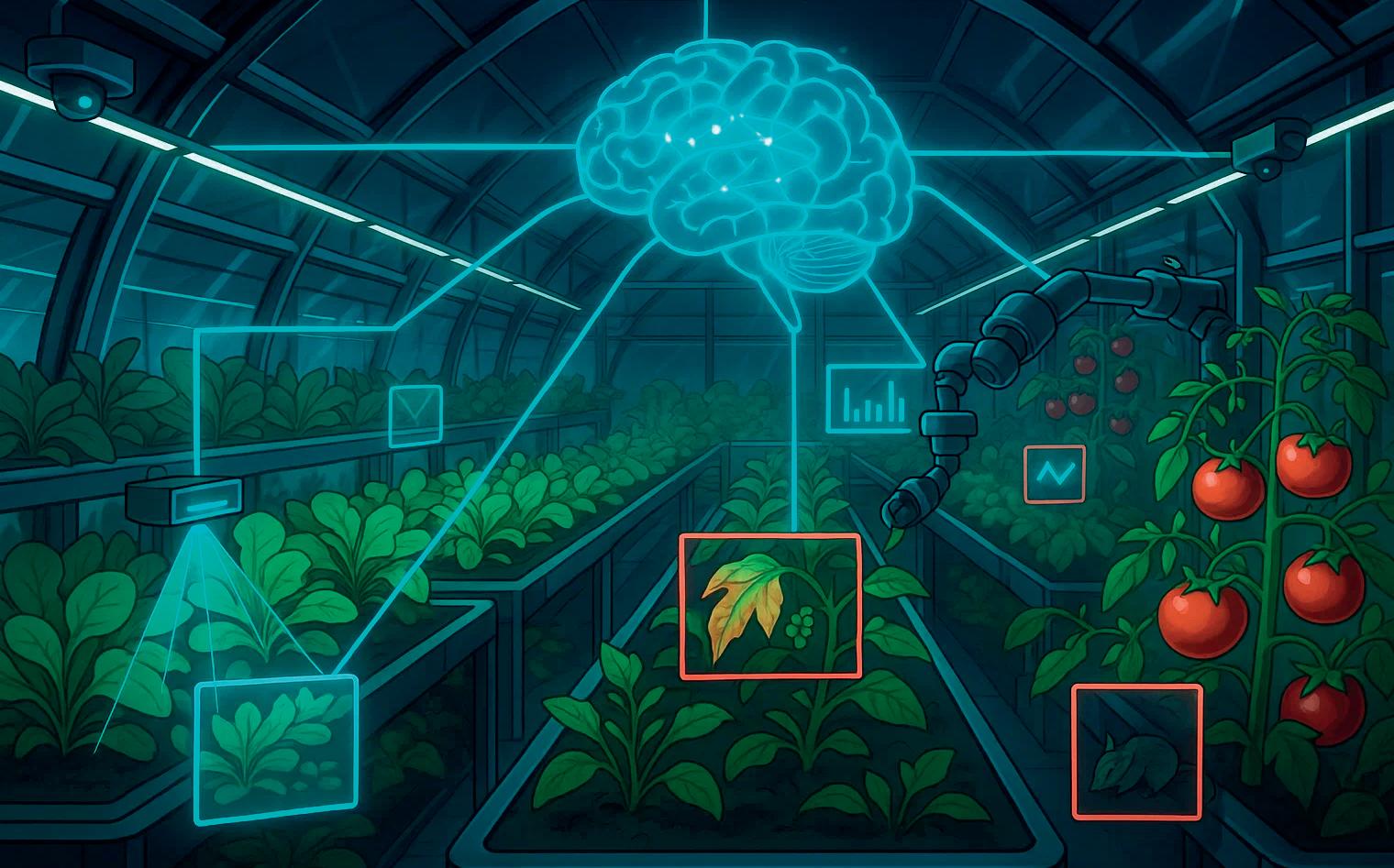

Serra Archimede, progettato con la collaborazione di Pragma Etimos, è un sistema agrifotovoltaico integrato e complesso, che punta alla sostenibilità.

Tecnologie digitali e sostenibilità non sempre vanno a braccetto. Ma se c’è un ambito in cui questi due elementi spingono nella stessa direzione, quello è l’agricoltura: diventando più smart diventa anche più sostenibile, perché ottimizza il consumo di risorse preziose e limitate, come l’acqua e la terra. “L’agritech non è speculazione, è visione. È il passaggio da un modello predatorio a uno generativo, dove ogni pianta e ogni watt lavorano in sinergia per restituire valore, non solo per estrarlo”. Parole di Gaetano Lo Presti, Ceo e founder di Pragma Etimos, azienda informatica di Aprilia (Latina) che opera nel campo della computer vision, dell’intelligenza artificiale e dei dati. O meglio, dei green data: dati che sia possono essere prodotti, raccolti e gestiti in

modo più sostenibile, sia possono a loro volta contribuire a obiettivi di riduzione dei consumi energetici e degli impatti ambientali. Un perfetto e innovativo esempio è Serra Archimede: un progetto (promosso da Regran, società di rinnovabili del ragusano) a cui Pragma Etimos ha collaborato, portando in dote le proprie tecnologie di intelligenza artificiale e i propri modelli di analisi predittiva. Il nome non è casuale, perché Serra Archimede nasce in Sicilia come l’inventore e matematico a cui si ispira. Ed è altrettanto ingegnosa: si tratta, infatti, di un sistema agrifotovoltaico che bilancia una serie di fattori potenzialmente in conflitto tra loro. Da un lato, la serra massimizza la resa delle colture attraverso la radiazione fotosinteticamente attiva (Photosynthe-

tically Active Radiation, o Par), cioè la parte dello spettro solare utilizzabile dalle piante per la fotosintesi; dall’altro, ottimizza la produzione di energia fotovoltaica tramite pannelli solari. Attraverso dati raccolti da sensori e analizzati con l’AI, il sistema ricerca l’equilibrio perfetto fra le variabili, fra ombra e calore, e lo fa adattandosi continuamente alle condizioni ambientali.

Si tratta non solo di un sistema altamente tecnologico ma anche di un sistema integrato, dove elementi differenti cooperano tra loro: i sensori, gli algoritmi, ma anche i materiali della serra, le sue forme e l’architettura solare. L’orientamento, l’inclinazione e la curvatura delle superfici sono, infatti, variabili che influenzano la quantità e la qualità della radiazione Par ricevuta dalle piante. La progettazione tiene conto anche della fisiologia delle piante, ovvero di come esse reagiscono alla luce, che se eccessiva può surriscaldare le foglie e inibire la fotosintesi, se insufficiente o incostante può rallentare la produzione di clorofilla e il metabolismo delle piante stesse. “Investire in una serra intelligente significa investire in resilienza: è come costruire un ponte sul domani invece di rattoppare una strada vecchia”, ha commentato Lo Presti. “Il vero vantaggio competitivo è l’equilibrio: tra energia e agricoltura, tra intelligenza artificiale e sapienza umana, tra forma e funzione”.

Se oggi Serra Archimede è un progetto avanguardistico, in futuro sistemi di questo tipo potrebbero diventare una necessità, uno strumento che permette di far germogliare piante e ortaggi anche in condizioni climatiche estreme. Lo Presti riassume così la propria visione: “Immagino un domani in cui l’agricoltura non sarà più sinonimo di fatica cieca, ma di intelligenza condivisa: e le serre intelligenti saranno i primi capitoli di questa nuova storia”. V.B.

L’impiego dell’AI nell’Enterprise Resource Planning (anche quello per piccole e medie imprese), secondo lo specialista francese Bonx.

Intelligenza artificiale ed Enterprise Resource Planning: che rapporto hanno queste due tecnologie? E che valore aggiunto può portare l’AI in un ambito consolidato e core come quello del software gestionale? Lo abbiamo chiesto ad Alexandre Barroux, Ceo di Bonx, azienda francese specialista dell’Erp per le piccole e medie imprese manifatturiere.

Quali vantaggi comporta l’inserimento dell’AI in un Erp?

Non parliamo di tecnologie parallele, ma complementari. Il software Erp è la spina dorsale operativa, mentre l’AI è l’intelligenza che lo rende predittivo, adattivo e strategico. A differenza della Robotic Process Automation (Rpa), che automatizza compiti ripetitivi seguendo regole rigide, l’AI è in grado di apprendere dai dati, adattarsi al contesto e supportare decisioni sempre più accurate. In Bonx, ad esempio, l’AI aiuta a prevedere ritardi, ottimizzare la produzione e migliorare i margini. Non si limita a eseguire: capisce che cosa serva davvero e lo suggerisce in anticipo.

Quello tra AI ed Erp è un incontro perfetto o ci sono criticità da considerare?

L’incontro tra AI ed Erp è potente, ma non è magia. Perché l’AI sia utile davvero, servono condizioni chiare con dati affidabili, contesti coerenti e obiettivi ben definiti. L’intelligenza artificiale può fare molto, ma va alimentata con

informazioni corrette e comprensibili. Non sostituisce il lavoro dell’azienda ma lo amplifica, aiuta a prendere decisioni più veloci e a evitare errori. L’AI fa davvero la differenza nella vita operativa di tutti i giorni, ma ha bisogno di una base solida da cui partire.

Quali specifiche tecnologie di AI possono essere usate in un Erp?

Le applicazioni dell’intelligenza artificiale in ambito Erp sono tante e in continua evoluzione, con funzionalità che spaziano dall’analisi predittiva agli agenti AI, fino a nuovi modi di interagire con i dati. In Bonx oggi l’AI è già attiva in tre aree chiave: legge ordini e documenti e compila i campi necessari automaticamente, eliminando l’inserimento manuale; permette di generare dashboard semplicemente scrivendo ciò che si vuole vedere; e semplifica la pianificazione della produzione, dando la possibilità di spiegare i vincoli in linguaggio naturale. Inoltre, il nostro

software è in continua evoluzione con molte nuove funzioni AI che verranno implementate in futuro.

Il mercato dell’Erp è storicamente presidiato da alcune Big Tech. Come vi posizionate in questo scenario?

Il mercato Erp è dominato da grandi player pensati per realtà molto strutturate. Bonx, invece, nasce con un focus verticale sulla gestione delle operations, a servizio delle Pmi manifatturiere. I nostro approccio è completamente diverso, prevendendo un’implementazione in poche settimane, un sistema no-code che dà autonomia agli utenti e una piattaforma evolutiva che si adatta nel tempo. I nostri clienti cercano controllo, velocità e semplicità: Bonx è una soluzione su misura senza necessità di sviluppi custom, pensato esattamente per la complessità delle Pmi. Il nostro obiettivo è diventare il punto di riferimento per le Pmi manifatturiere italiane che vogliono modernizzare la gestione operativa senza complicarsi la vita. L’Italia ha un tessuto industriale straordinario ma spesso ancora legato a strumenti lenti, frammentati o troppo rigidi. Possiamo semplificare la gestione quotidiana delle Pmi, rendendo accessibile una tecnologia che spesso è percepita come distante o complessa: il nostro obiettivo è fornire alle aziende un sistema semplice e intuitivo. Stiamo lavorando all’apertura di un ufficio a Milano, che sarà il nostro hub commerciale e operativo. V.B.

Realtà aumentata, GenAI, 5G: sono alcune delle tecnologie che potenziano l’esperienza di acquisto nei punti vendita fisici.

L’e-commerce sta inevitabilmente cambiando il settore del consumo al dettaglio. I consumatori hanno a portata di mano prodotti e opportunità impensabili fino a cinque anni fa, mentre i retailer si trovano ad affrontare sfide sempre più grandi in termini di logistica, tecnologia e soddisfazione del cliente. Nel frattempo, i negozi fisici devono fare i conti con la concorrenza agguerrita dei grandi brand presenti in rete e con richieste sempre più pressanti da parte dei consumatori, che vedono ancora nello store tradizionale uno spazio in cui avere un’esperienza di acquisto più umana e personalizzata. Ed è su questo che i retailer devono puntare per convincere i clienti a non abbandonare del tutto il mondo degli acquisti fisici a vantaggio di quelli online. Secondo un recente studio internazionale di Verizon, l’88% è soddisfatto nell’interagire con persone in carne e ossa al momento di fare acquisti, a fronte di un 60% che apprezza lo shopping con interazioni guidate dall’intelligenza artificiale.

Il digitale entra in negozio

Un uso ben calibrato di tecnologie quali la realtà aumentata e il 5G può aiutare i negozi fisici a mantenere attrattività nei confronti dei consumatori, offrendo esperienze sempre più personalizzate. Strategie di gamification o il “camerino virtuale” (virtual try-on) rappresentano strumenti im-

portanti per convincere i consumatori a passare dal divano al negozio. Ad esempio, grazie al virtual try-on i negozianti possono ovviare alle code ai camerini per provare i capi, permettendo ai clienti di visualizzare taglie, colori o fantasie diverse senza dover attendere l’arrivo di un assistente agli acquisti.

L’Augmented Reality, assieme ad app e chioschi digitali, può anche aiutare il cliente a muoversi all’interno del negozio, guidandolo attraverso le varie aree dello store, in modo da facilitare la sua permanenza e migliorare la sua esperienza di acquisto. Altro tema importante è quello della fluidità e semplicità di acquisto: attraverso applicazioni dedicate e pagamenti elettronici, i clienti possono concludere senza intoppi e rapidamente la fase di checkout.

Personalizzazione e multicanalità Un po’ come sta accadendo per i grandi marchi del lusso, il passaggio dal negozio fisico dovrebbe diventare qualcosa di esperienziale, non solo un evento legato all’acquisto. Pensiamo a mostre d’arte, ristoranti gourmet, ma anche un tuffo nel “dietro le quinte” di prodotti iconici che hanno fatto la storia delle maison di moda più blasonate al mondo: tutto questo può essere veicolato grazie alla realtà aumentata, a infrastrutture di rete moderne e basate sul 5G. Anche la consulenza all’acquisto può essere supportata dal-